在逼真的空战模拟中实现任务目标极具挑战性,这源于态势感知的不完善和非线性飞行动力学。本文提出一种新型三维多智能体空战环境及分层多智能体强化学习框架以应对这些挑战。我们的方法融合了异构智能体动力学、课程学习、联赛式训练以及新改进的训练算法。该决策过程被组织为两个抽象层级:底层策略学习精确的飞控机动,而高层策略根据任务目标发布战术指令。实证结果表明,在复杂近距空战场景中,我们的分层方法提升了学习效率和作战性能。关键词——多智能体强化学习、分层策略、课程学习、空战模拟。

强化学习(RL)在复杂决策任务中展现出显著潜力。洛克希德·马丁公司的研究[1]是其有效性的典范——RL智能体在模拟空战场景中超越人类飞行员,成为该领域的里程碑。多智能体近距空战作为战斗机之间的近距离空中对抗,涉及快速机动、高速接战与精确协同。其固有复杂性源于部分可观测性、非线性动力学和对抗性交互,这使得近距空战成为多智能体强化学习(MARL)研究中极具挑战性的领域,要求精确控制和高级战术推理。

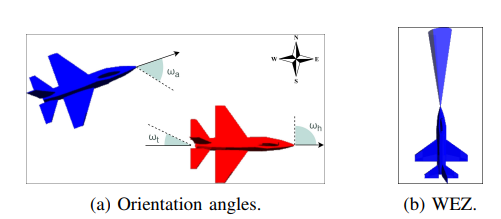

为应对这些挑战,开发了定制化的三维多智能体空战环境,该环境集成JSBSim飞行动力学模型[2],可实现物理精确且空气动力学精准的飞行器行为模拟。为有效学习复杂机动,我们采用分层多智能体强化学习(HMARL)方法,将决策过程构建为两个抽象层级:底层策略处理连续飞行器控制,高层策略发布引导战略行动与接战决策的战术指令。这种分层结构支持可解释的推理过程,促进复杂空战战术的涌现。我们进一步引入异构智能体以反映真实对抗中的多样化能力和作战角色。本文主要贡献包括:

• 提出适用于异构动力学条件下MARL模拟的逼真空战环境;

• 构建有效HMARL框架以学习竞争性空战中的高级策略;

• 改进新近提出的简单策略优化(SPO)算法[3]以适应多智能体场景;

• 通过实证验证模型优势并论证设计选择的合理性。

代码开源地址:github.com/IDSIA-papers/HHMARL_AirCombat。