深度学习

·

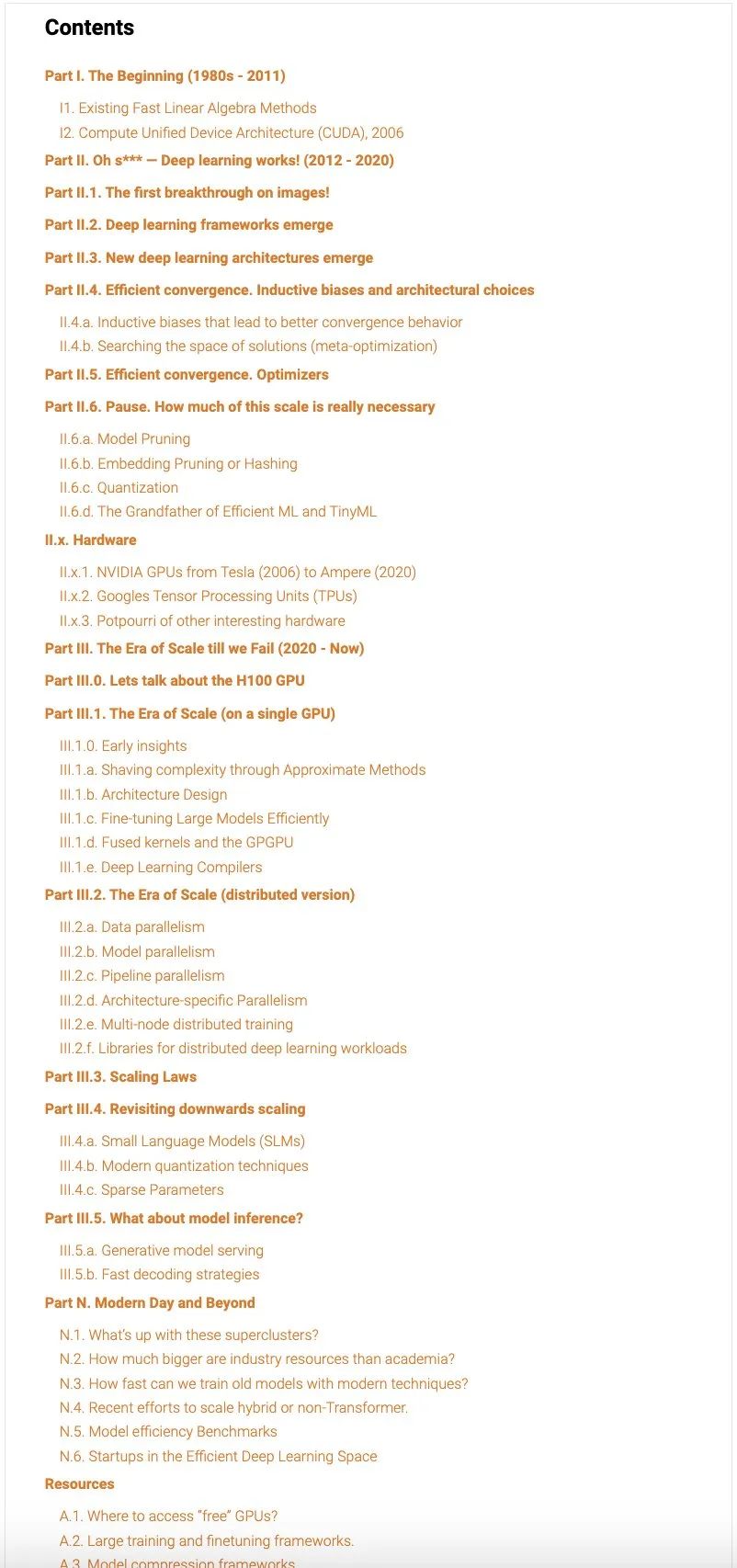

本文提供了从效率角度出发的深度学习进展的全面时间顺序指南:涵盖了集群、独立硬件、深度学习库、编译器,甚至架构的变化。本文并非一篇综述论文,旨在为读者提供对该领域的广泛直观理解——在过去 40 年中涌现的每一个细节都不可能全部涵盖。 前言:在过去十年中,深度学习领域蓬勃发展,发展到无论是研究人员还是学生都很难跟踪其动态的程度。有时,我甚至发现自己难以把握该领域的实际方向。在这个常常显得飘忽不定的领域,许多方法和结果在实际中显得差强人意,我希望至少对我们当前所处的进展有一个概念。 我希望以叙述的形式写这篇文章——1)使其对读者易于理解,而不是信息过载;2)让读者从宏观视角审视该领域,并理解其演变轨迹。我尽量以论文为中心(类似于 Lilian Weng 风格的博客!),并包含了我认为适当的标志性(或酷炫)作品;如果读者觉得需要包含或修改某些内容,请随时告知!在开始之前,让我先列出一些相关的数字,以帮助大家更好地了解即将讨论的进展。对于不熟悉这些数字的朋友,我也添加了一些说明。

- NVIDIA 最新的 Blackwell B200 GPU 估计售价为 3 万至 4 万美元。

- 对于 FP8,它的性能可达约 4500 TeraFLOPS,性能非常惊人!

- 它配备了 192GB 的高带宽内存/DRAM,这是主要的 GPU 内存。

- Llama 3.1 405B,Meta 最新的开源语言模型,参数量达 4050 亿(约 800GB)。

- 它的训练使用了高达 16000 张 NVIDIA H100(位于 24000 GPU 集群上)。

- 它的训练数据集包含了 15 万亿个 token。

成为VIP会员查看完整内容