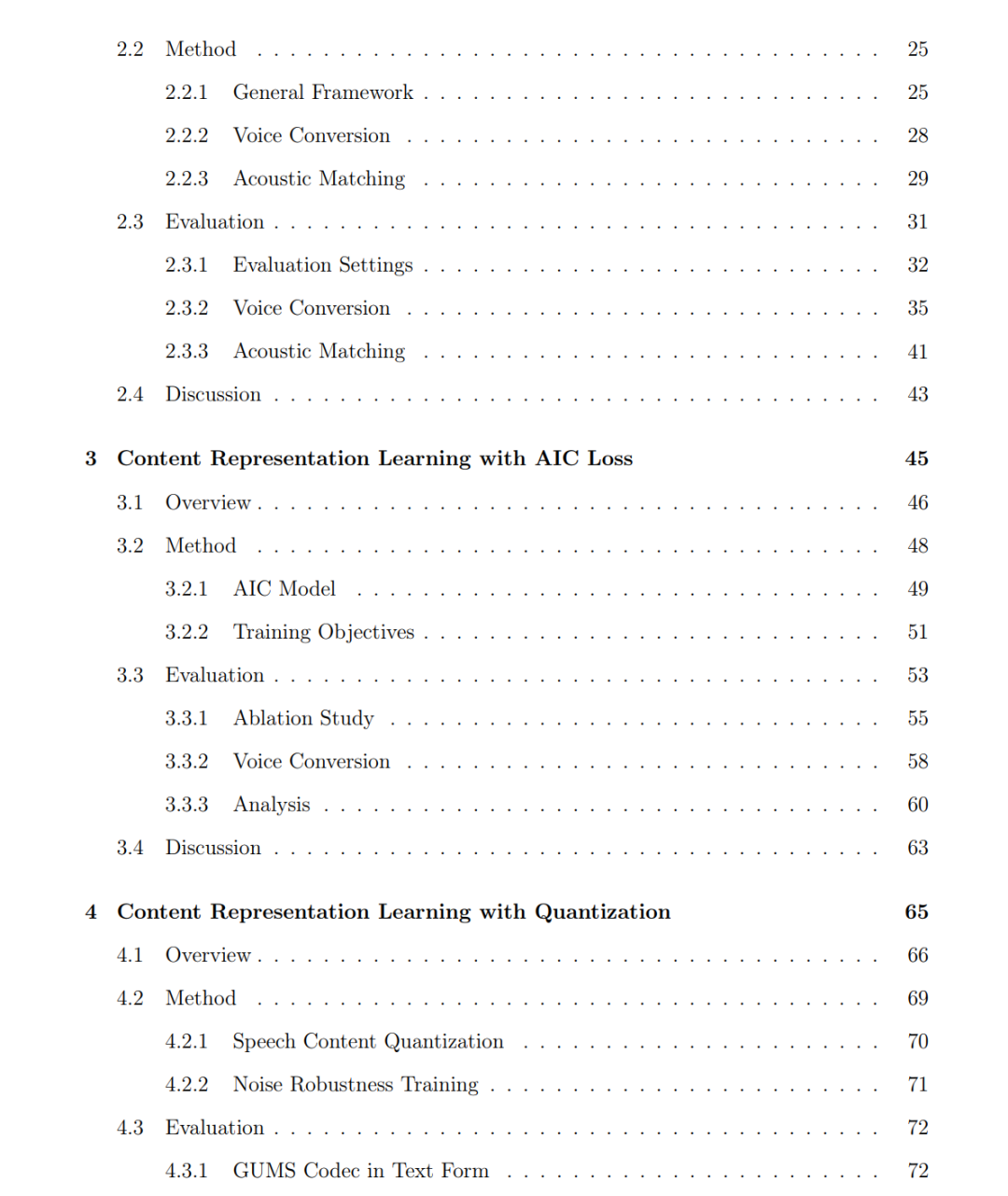

本论文提出了一个通过自监督生成式建模实现可控语音合成的综合框架。我们提出 GUMS(Generative Universal Models for Speech),该系统将语音分解为可解耦的表征——说话人嵌入、声学嵌入以及内容表征,并通过一个合成模型重建语音。该方法能够对说话人音色、环境声学特性、语音内容以及语速进行细粒度控制。 我们引入了三个关键的表征模型。首先,GR0 通过将全局说话人特征与随时间变化的局部内容解耦,在不依赖说话人标签的情况下学习全局说话人嵌入。其次,我们提出内容表征模型 AIC 与 GUMS Codec,分别以连续形式与量化形式捕获语音内容。AIC 模型通过 alteration invariant content loss(变换不变内容损失)来确保表征对说话人和音高不敏感。GUMS Codec 基于语音编码器模型 DAC 构建,结合残差向量量化,并引入说话人和音高条件,从而形成一种高度紧凑、离散且与语言无关的表征,非常适用于操作、控制与高效传输。 随后,我们将这些表征整合到一个高保真语音合成模型 DiTVC 中,该模型基于 Diffusion Transformer 架构。DiTVC 支持使用目标说话人音频进行直接提示,而不是依赖固定嵌入,从而实现更具表现力的语音转换和更稳健的韵律控制。通过结合这些模型,我们在未标注的真实环境数据上实现了可控的高质量语音合成。该统一框架在表征学习与生成两个方面均取得了重要进展,为语音合成提供了一种可解释且可编辑的方法。

成为VIP会员查看完整内容