【CVPR2018最佳论文重磅出炉】斯坦福伯克利折桂,何恺明获TPAMI年轻研究员奖

【导读】美国当地时间6 月 18 号,CVPR 2018 在犹他州盐湖城开幕。作为计算机视觉领域的全球顶会,吸引了国内外众多学界、产业界的研究人员参与。CVPR 2018最佳论文奖以及其他奖项刚刚揭晓。最佳论文花落斯坦福和伯克利大师论文,最佳学生论文奖授予了CMU。值得一提,何恺明获得了PAMI年轻研究员奖。2018年的CVPR最佳论文,授予了来自斯坦福大学和加州大学伯克利分校著名教授Jitendra Malik和Silvio Savarese的Taskonomy: Disentangling Task Transfer Learning。

来源:新智元

编辑:专知

最佳论文

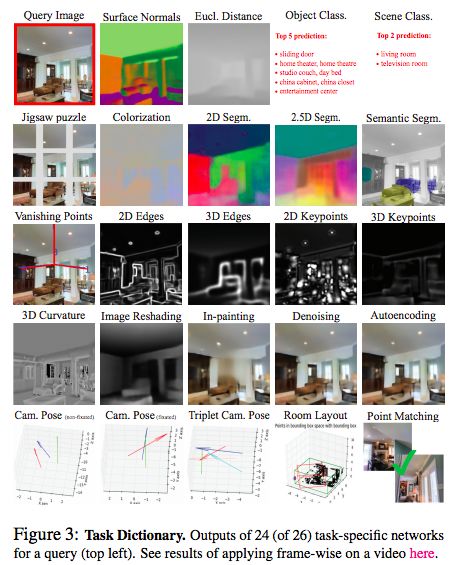

最佳论文题目:Taskonomy: Disentangling Task Transfer Learning

论文地址:https://arxiv.org/pdf/1804.08328.pdf

作者来自斯坦福大学和加州大学伯克利分校,包括计算机视觉领域的著名教授Jitendra Malik和Silvio Savarese。

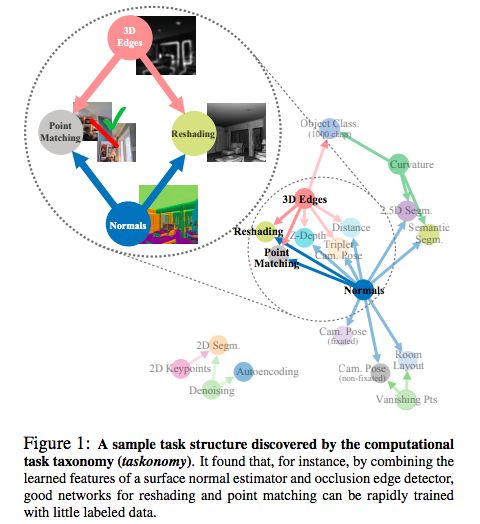

不同的视觉任务是相关的,还是毫不相关的?例如,曲面法线(surface normals)是否可以用来简化对图像深度的估计?显然是的,这意味着视觉任务之间存在一种结构。了解这种结构很有好处;它是迁移学习的底层概念,并为识别跨任务的冗余信息提供了一种原则性方法。例如,在相关任务之间无缝地重用监督,或者在一个系统上解决多个任务,而不增加复杂性。

在这篇论文中,作者提出一种完全计算的方法来建模视觉任务的空间结构。这是通过在一个潜在空间的26个2D,2.5D,3D和语义任务中找到(第一阶和更高阶)的迁移学习依赖关系来实现的。其产物是一个用于任务迁移学习(task transfer learning)的计算分类图(computational taxonomic map)。我们研究了这种结构的影响,并利用它们来减少对标记数据的需求。

例如,我们证明了,解决一组10个任务所需的标记数据池的总数可以减少大约2/3个(与独立训练相比),同时保持性能几乎一致。我们提供了一套用于计算和检测这种分类结构的工具,包括一个求解器,用户可以使用它为他们的用例设计有效的监督策略。

图1:计算任务分类法(taskonomy)发现的一个示例任务结构。

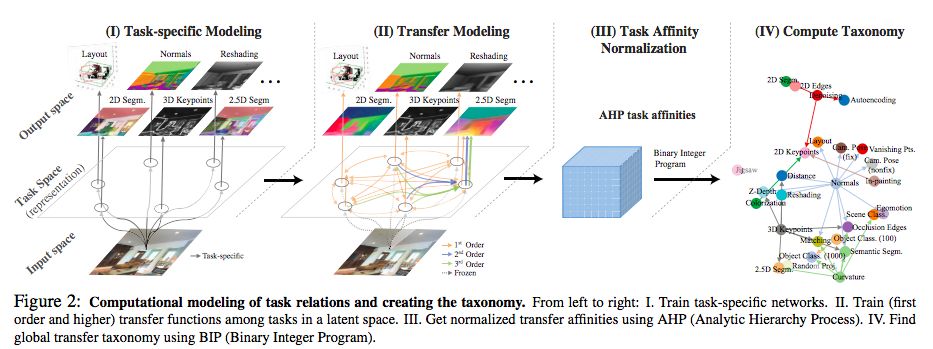

论文将这一方法分解为4个步骤:

图2:任务关系的计算建模和创建分类。 从左到右:I. 训练特定任务的网络。II. 在潜在空间的任务之间训练(一阶和更高阶)迁移函数。III. 使用AHP(层级分析法)获得标准化的迁移关系。IV. 使用BIP(二进制整数程序)查找全局迁移分类。

第一步: 特定于任务的建模

第二步:迁移建模

第三步:使用层级分析法(AHP)进行序数标准化

第四部:计算全局分类

图3:任务词典。

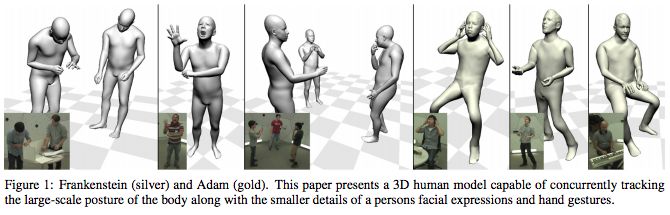

最佳学生论文

论文:完全捕获:跟踪脸部、手部和身体的3D变形模型

Total Capture: A 3D Deformation Model for Tracking Faces, Hands, and Bodies

作者:Hanbyul Joo,Tomas Simon,Yaser Sheikh,均来自CMU

我们提出了一个统一的变形模型(deformation model),用于无标记地捕捉人体运动的多个尺度,包括面部表情、身体动作和手势。初始模型是通过局部缝合人体各个部分的模型产生的,我们称之为“弗兰肯斯坦”模型。这个模型可以通过单一的无缝模型完整地表达人体部位的移动,包括面部和手部。通过大规模捕捉穿着日常服装的人,我们优化了弗兰肯斯坦模型,创建了“亚当”模型。“亚当”是一个校准模型,与最初的模型享有相同的骨架层次结构(skeleton hierarchy),但可以表达头发和服装的几何形状,使其可以直接用于人们的日常生活中。最后,我们展示了使用这些模型进行全身运动追踪,同时捕捉大规模的身体动作以及社交群体的微妙脸部和手部动作。

论文地址:http://www.zhuanzhi.ai/document/0cd16c85ed083701f0b5688bcc95770a

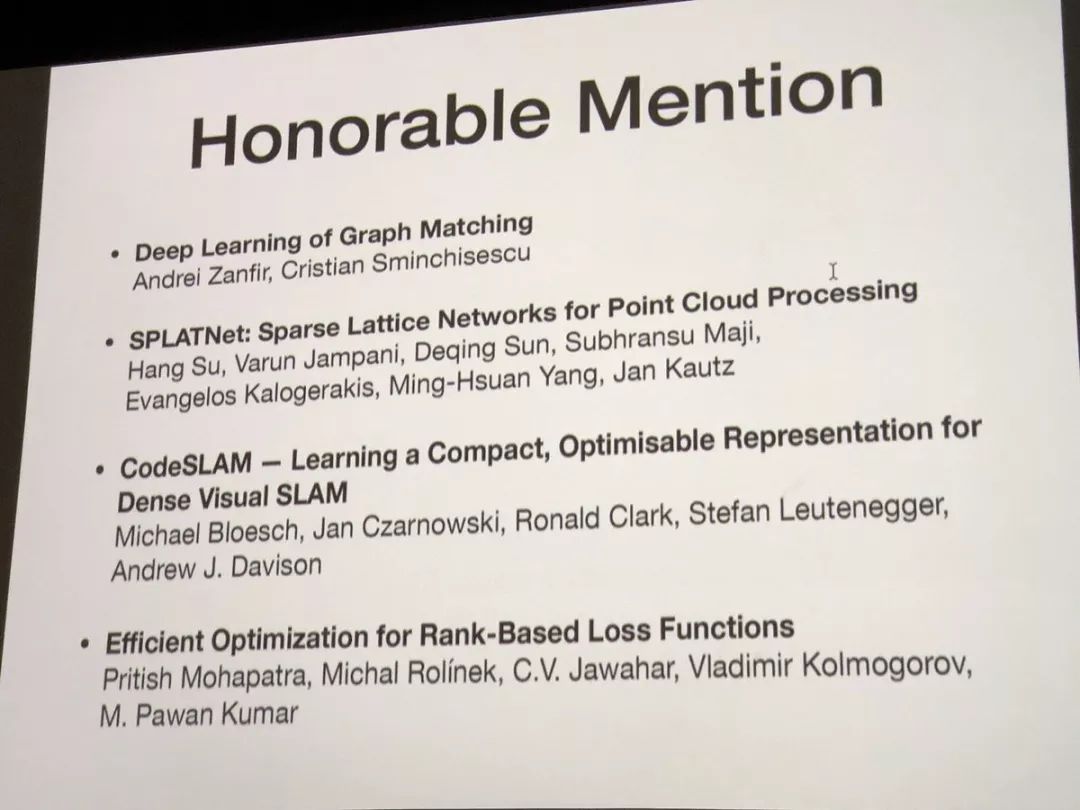

最佳论文提名

Deep Learning of Graph Matching

作者:Andrel Zanfir, Cristian Sminchisescu

地址:

http://openaccess.thecvf.com/content_cvpr_2018/CameraReady/1830.pdf

SPLATNet: Sparse Lattice Networks for Point Cloud Processing

作者:Hang Su, Varun Jampani, Deqing Sun, Subhransu Maji, Evangelos Kalogerakis, Ming-Hsuan Yang, Jan Kautz

地址:

https://arxiv.org/pdf/1802.08275.pdf

CodeSLAM-learning a Compact, Optimisable Representation for Dense Visual SLAM

作者:Michael Bloesch, Jan Czarnowski, Ronald Clark, Stefan Leutenegger, Andrew J. Davison

地址:

https://arxiv.org/pdf/1804.00874.pdf

Efficient Optimization for Rank-based Loss Functions

作者:Pritish Mohapatra, Michal Rolínek C.V. Jawahar, Vladimir Kolmogorov, M. Pawan Kumar

地址:

https://arxiv.org/pdf/1604.08269.pdf

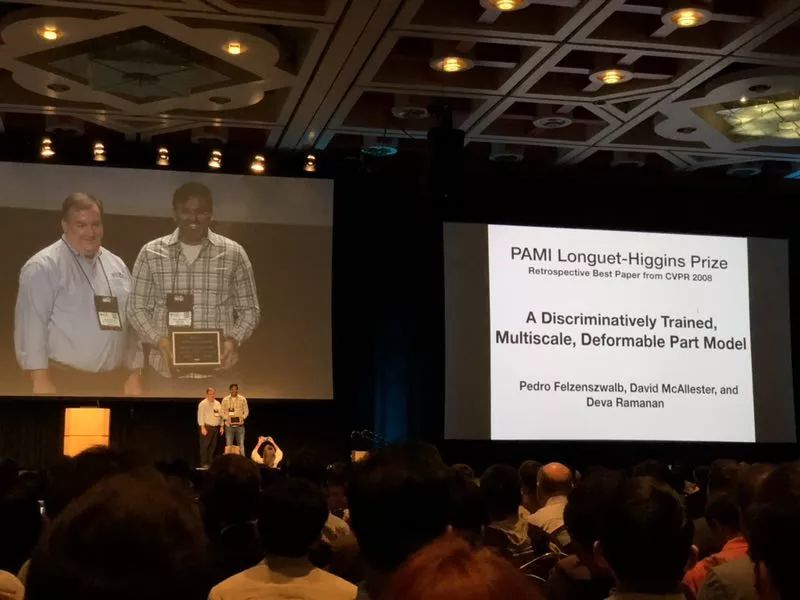

经典论文:Longuest-Higgins奖

Longuet-Higgins 奖是 IEEE 计算机协会模式分析与机器智能(PAMI)技术委员会在每年的 CVPR 颁发的“计算机视觉基础贡献奖”,表彰十年前对计算机视觉研究产生了重大影响的 CVPR 论文。奖项以理论化学家和认知科学家 H. Christopher Longuet-Higgins 命名。

2018 年的Longuet-Higgins 奖被授予了P. Felzenszwalb等人在 2008 年发表的 CVPR 论文“A discriminatively trained, multiscale, deformable part model”。根据谷歌学术搜素引擎,这篇文章的被引次数高达 2075 次。

获得经典论文奖的作者上台领奖。图片来源:熊霖

A discriminatively trained, multiscale, deformable part model

作者:Pedro.Felzenszwalb(芝加哥大学),David.McAllester(芝加哥丰田技术研究所),Deva.Ramanan(UC Irvine)

本文介绍了一种用于目标检测的判别训练的多尺度可变形部件模型。我们的系统在平均精度上达到了2006 PASCAL 人体检测竞赛中最优结果的两倍,同样比2007 PASCAL目标检测比赛中20个类别中的10个的最优结果都要好。此系统非常依赖于可变形部件模型。随着可变形部件模型逐渐流行,它的价值并没有在类似PASCAL的较难的数据集上被展示。我们的系统还依赖于判别训练的新方法。我们将一种挖掘难例(Hard Negative Example)的间隔敏感方法与隐藏变量 SVM 结合在一起。隐藏SVM类似于隐藏条件随机场(Hidden CRF)问题,最终是一个非凸规划的训练问题。隐藏SVM是半凸规划问题,但是一旦将隐藏信息指明给正样本,则训练问题变为凸规划问题。我们相信我们的训练方法最终可以利用更多的隐藏信息,例如层次(grammar)模型以及包含隐式三维姿态的模型。

论文地址:https://ieeexplore.ieee.org/document/4587597/

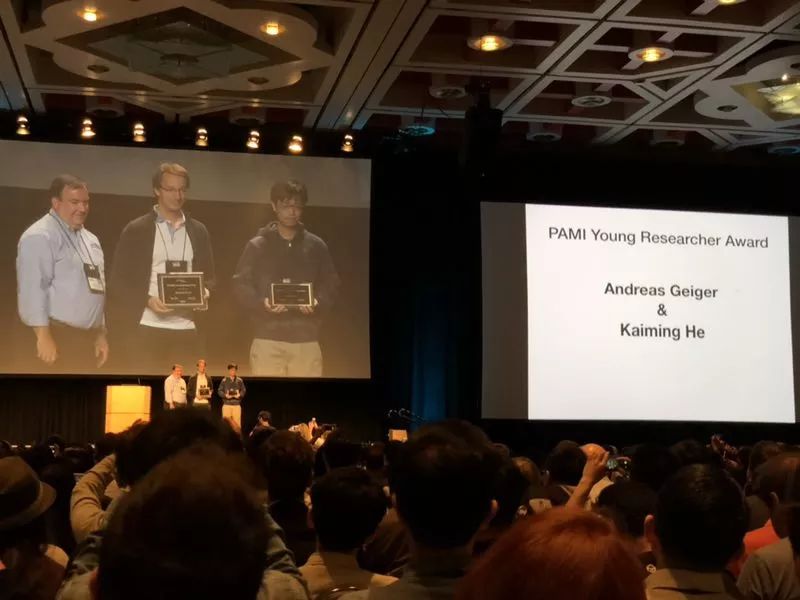

何恺明获 PAMI 年轻研究员奖

另一个奖项是“PAMI 年轻研究员奖”(PAMI Young Researcher Award),这个奖项授予那些博士毕业不超过 7 年并在计算机视觉方面有卓越研究贡献的的年轻研究人员。PAMI 年轻研究员奖自 2013 年起颁发,继承了 2012 年IVC 的“杰出青年研究员奖”(Outstanding Young Researcher Award)。

2018 年的 PAMI 年轻研究员奖得主是德国蒂宾根大学的 Andreas Geiger 和Facebook 人工智能研究所(FAIR)的何恺明。

两位获奖者上台领奖。图片来源:熊霖

从以上多个奖项的获奖者来看,虽然华人学者在CVPR的论文提交数量和竞赛上有出色表现,但是获奖的比例并不算高。

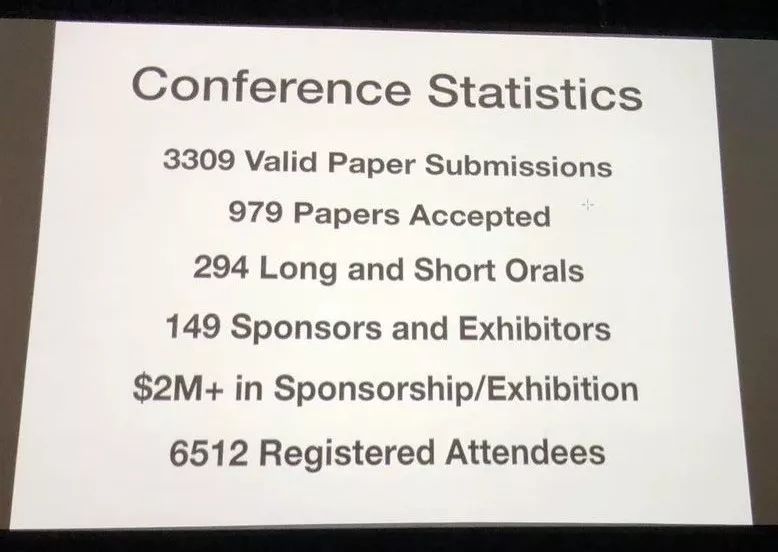

在 3309 篇有效投稿中,有 979 篇论文被接收,294 篇长文和短文,149 项赞助和展出,而赞助商费用也超过了 200 万美元。

-END-

专 · 知

人工智能领域26个主题知识资料全集获取与加入专知人工智能服务群: 欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知