【表示学习(Representation Learning)】8篇 NeurIPS 2019论文选读

NeurIPS 2019(Neural Information Processing Systems)将在12月8日-14日在加拿大温哥华举行。NeurIPS 是全球最受瞩目的AI、机器学习顶级学术会议之一,每年全球的人工智能爱好者和科学家都会在这里聚集,发布最新研究。今天小编整理了表示学习相关论文。

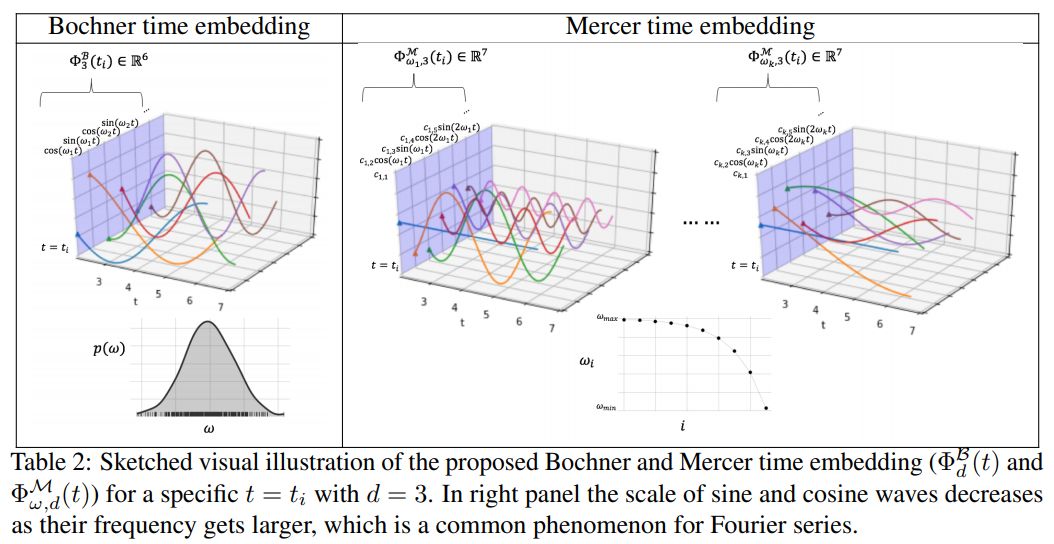

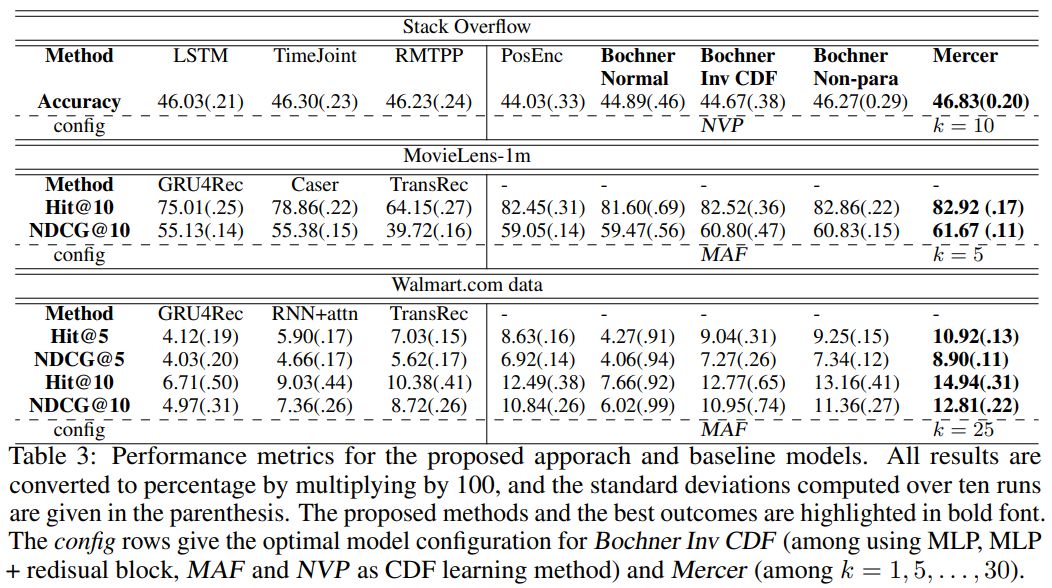

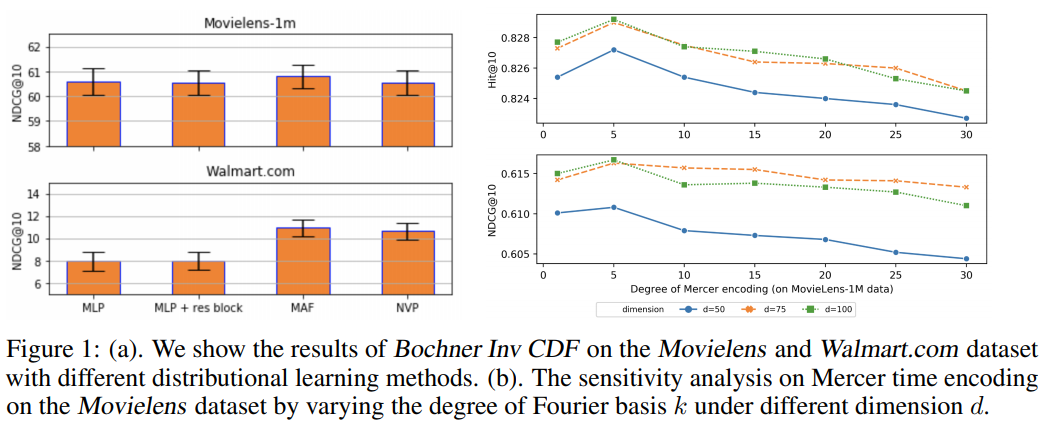

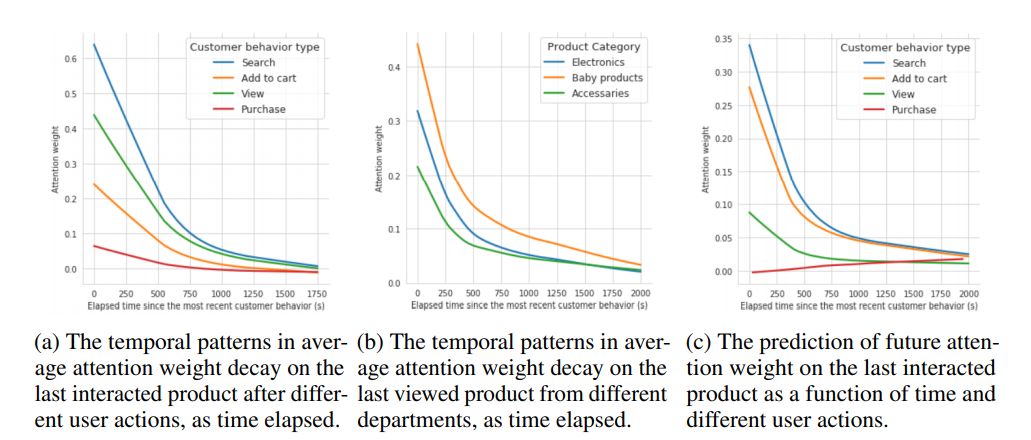

1. Self-attention with Functional Time Representation Learning

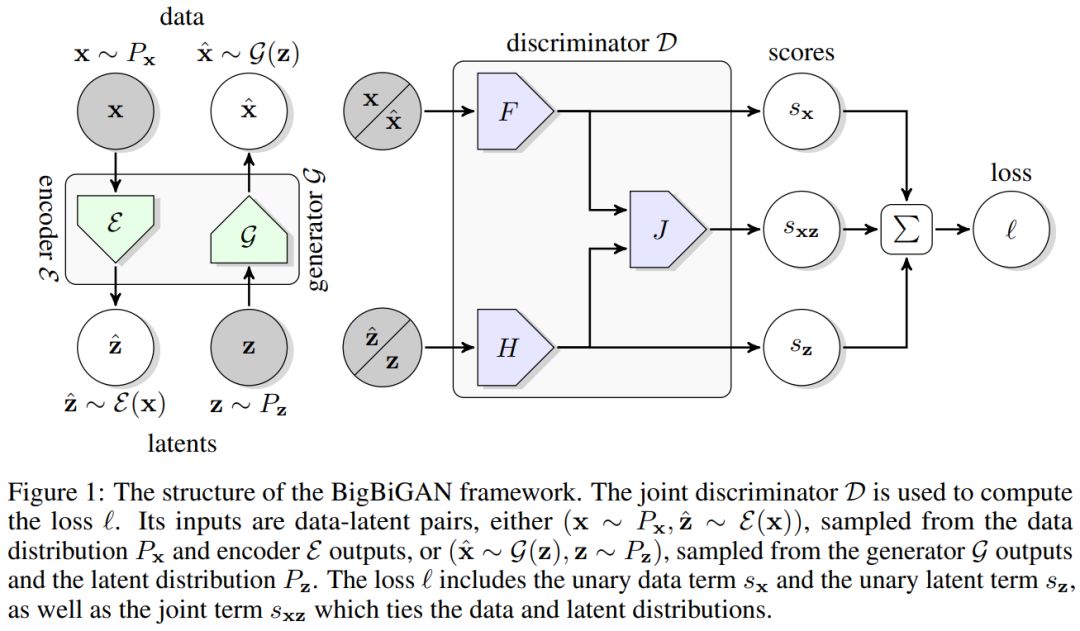

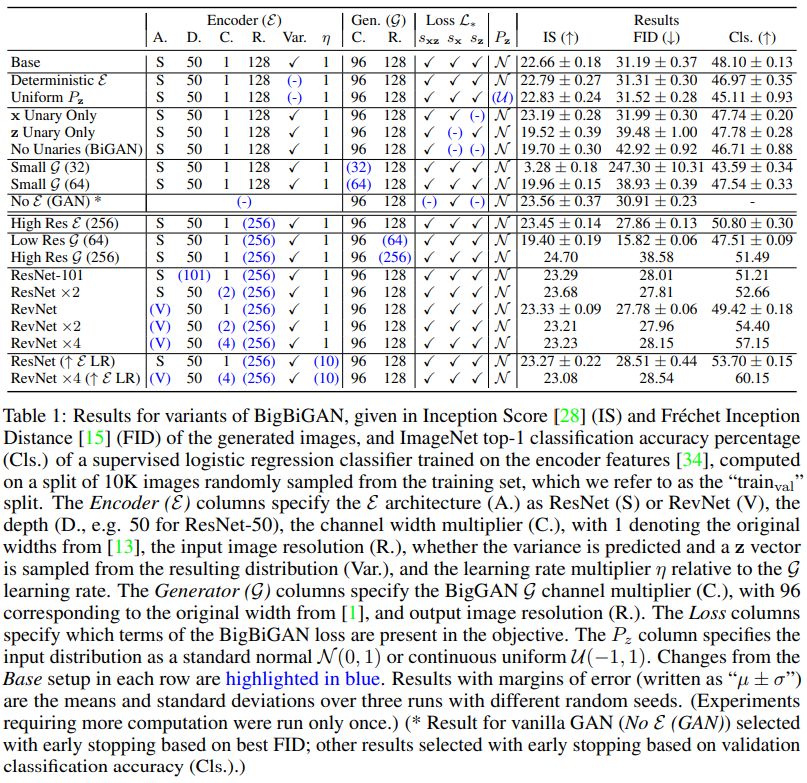

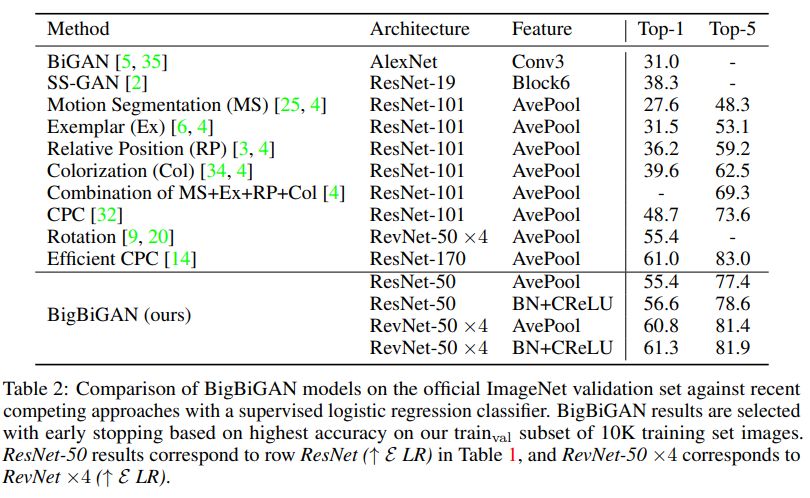

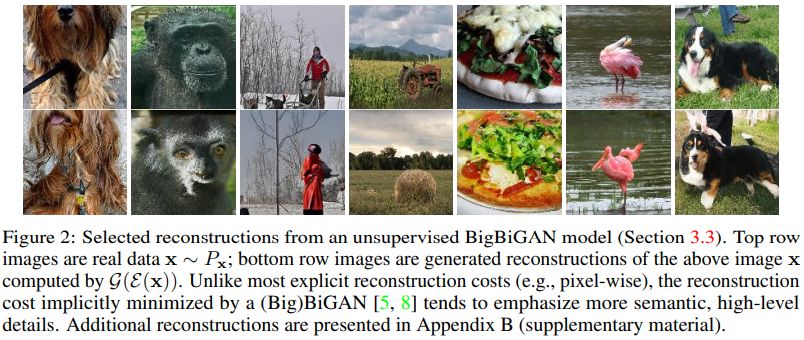

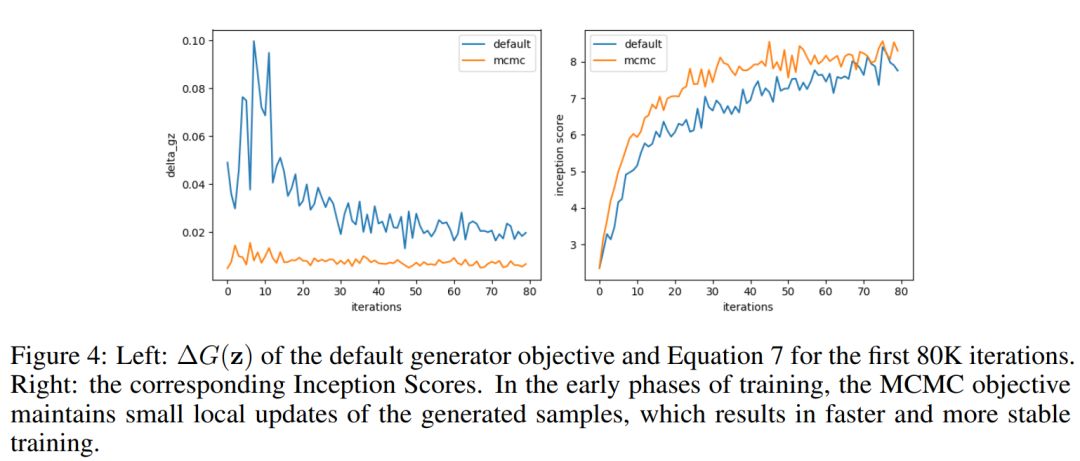

2. Large Scale Adversarial Representation Learning

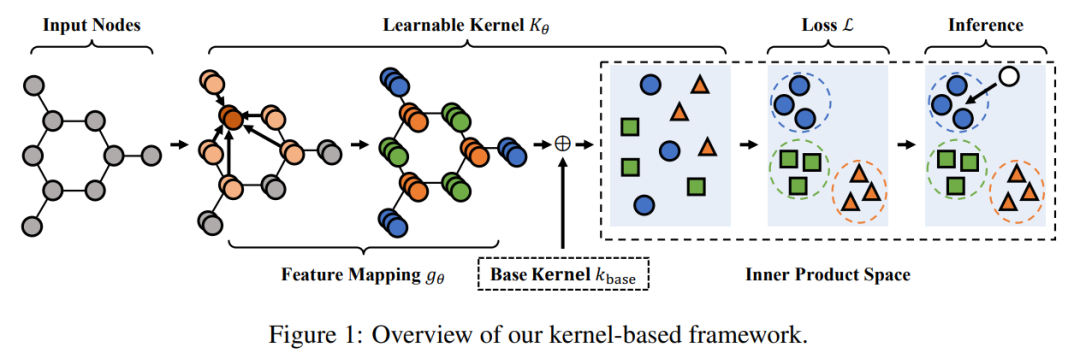

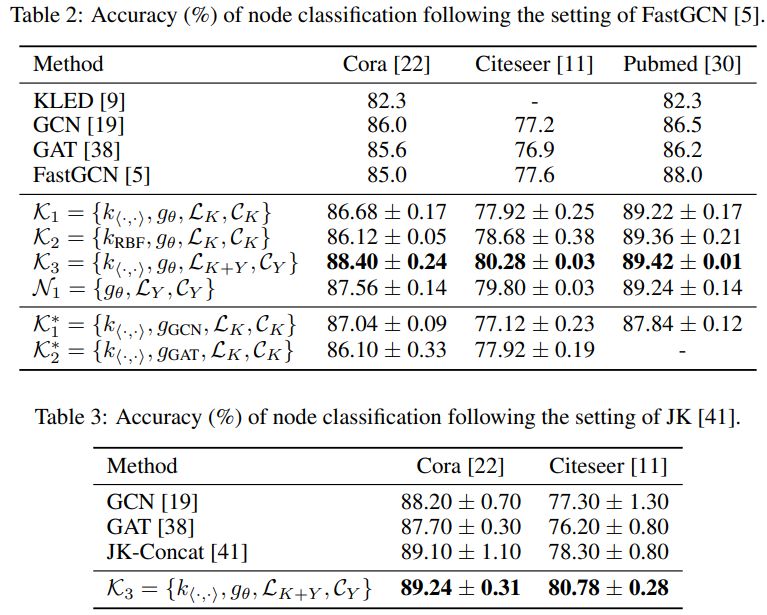

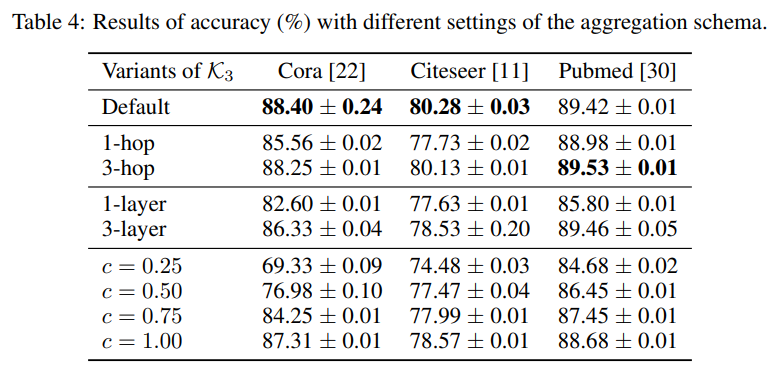

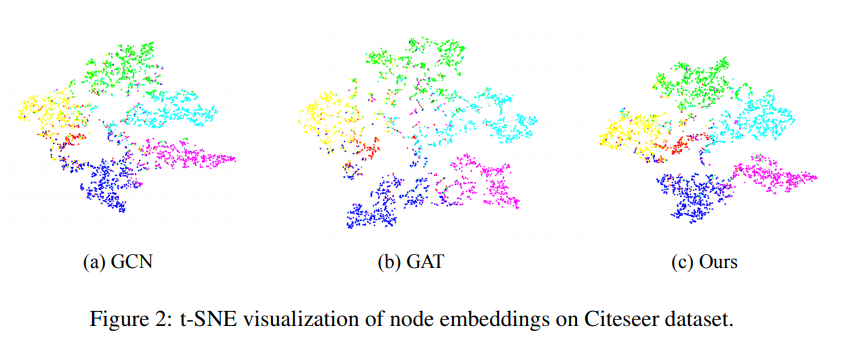

3. Rethinking Kernel Methods for Node Representation Learning on Graphs

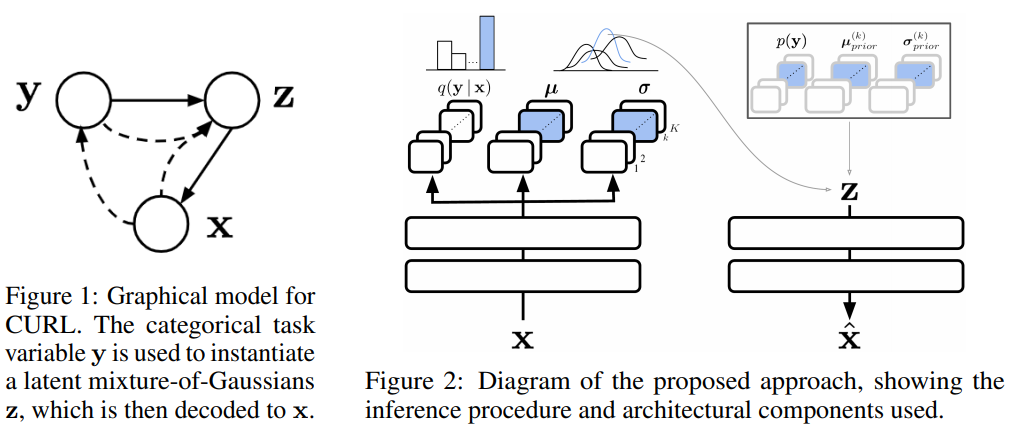

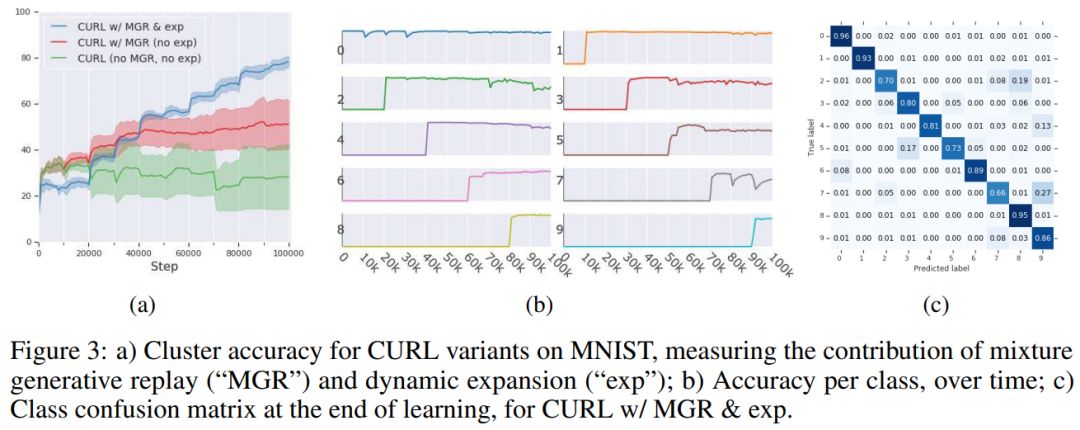

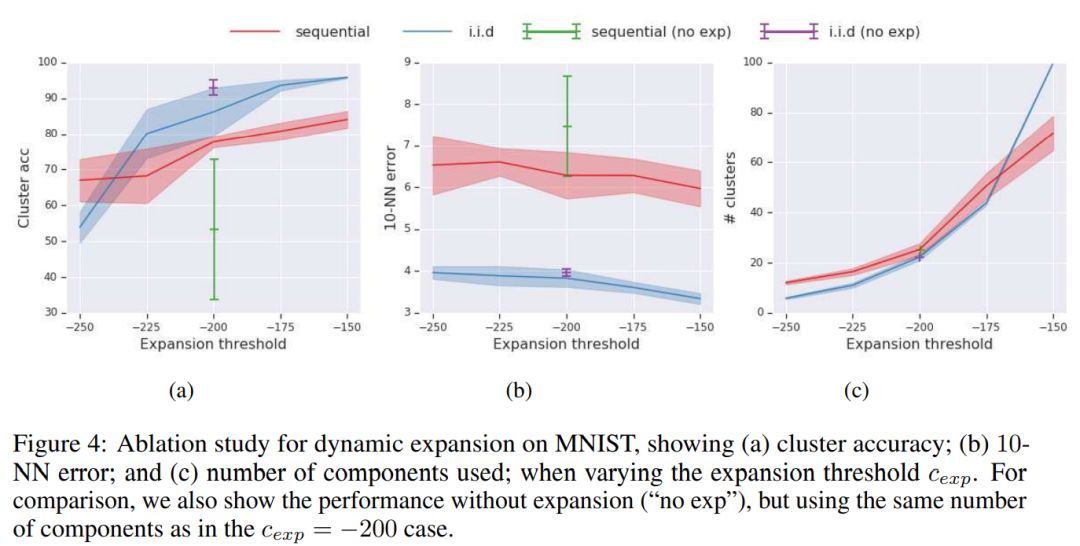

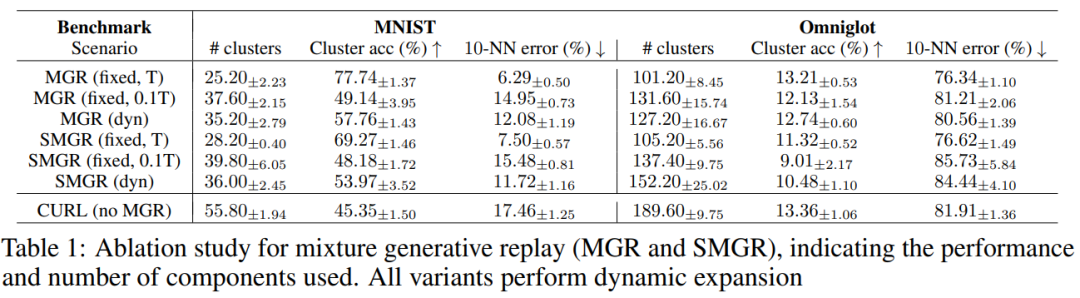

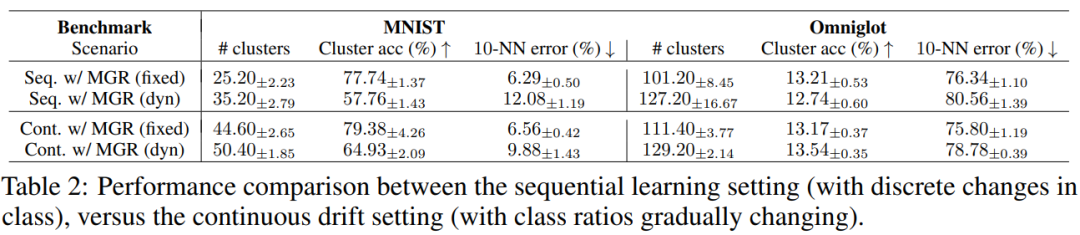

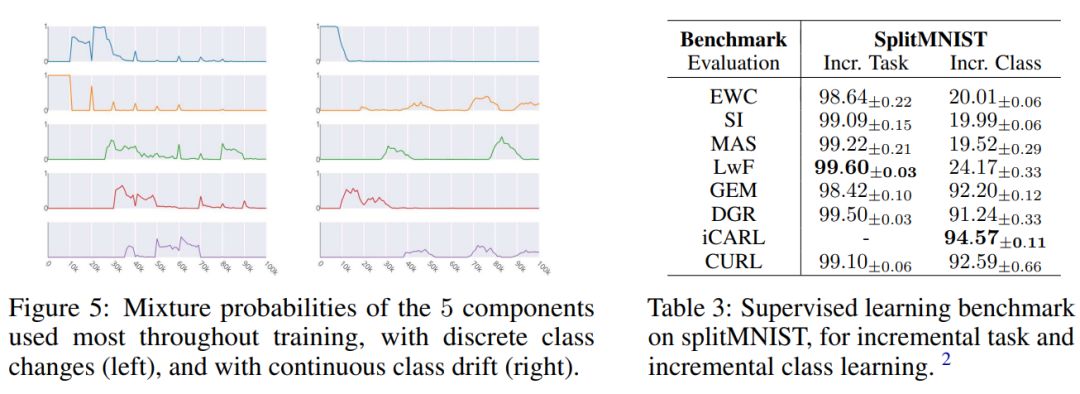

4. Continual Unsupervised Representation Learning

论文链接:

论文链接:

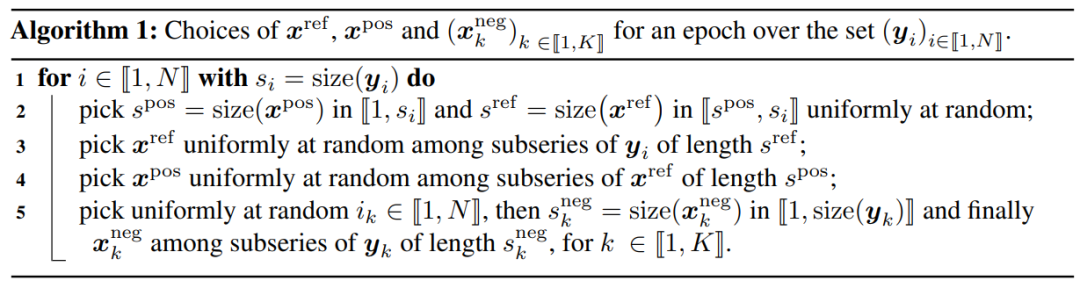

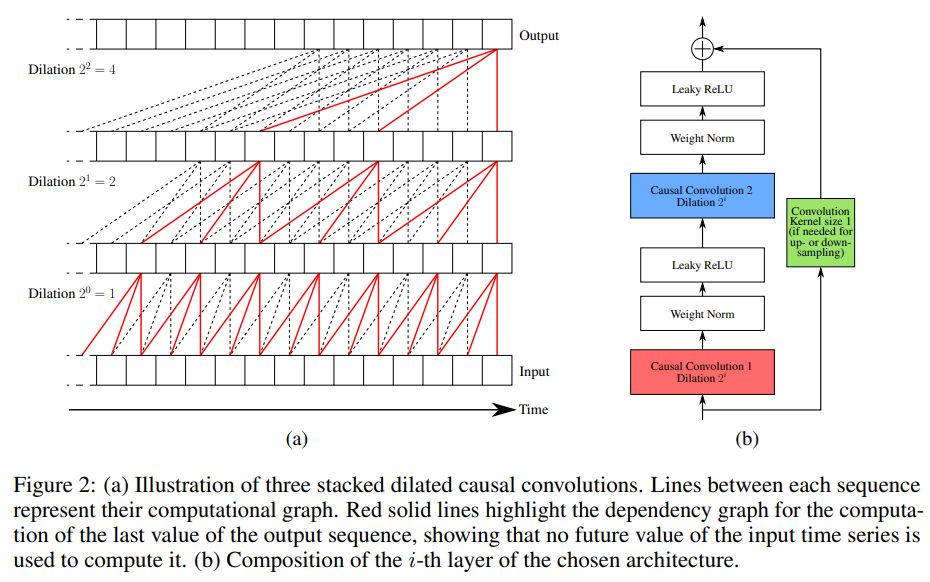

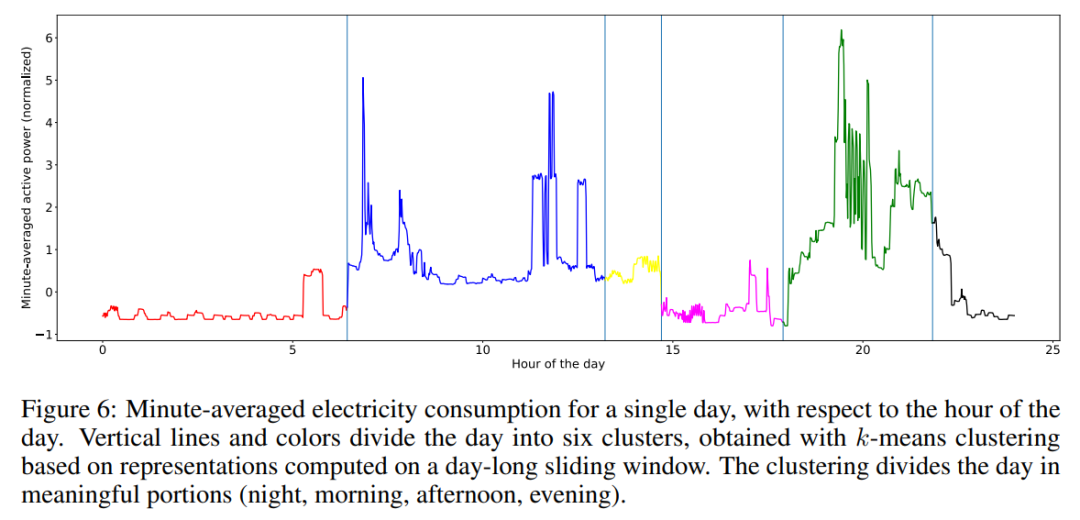

5. Unsupervised Scalable Representation Learning for Multivariate Time Series

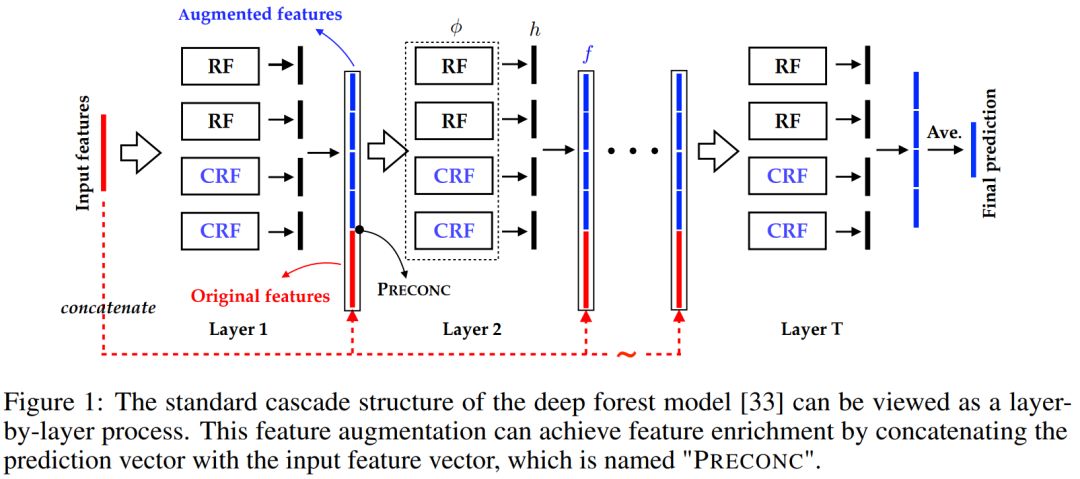

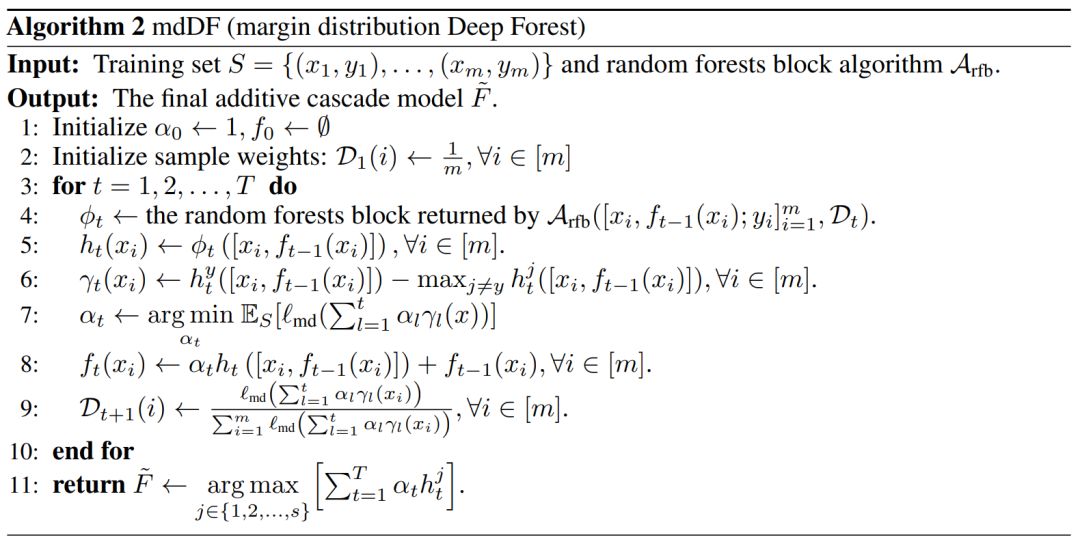

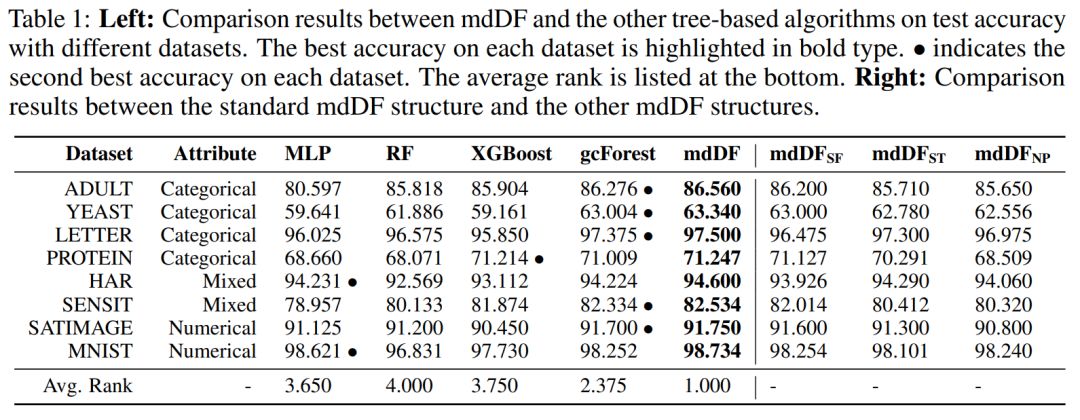

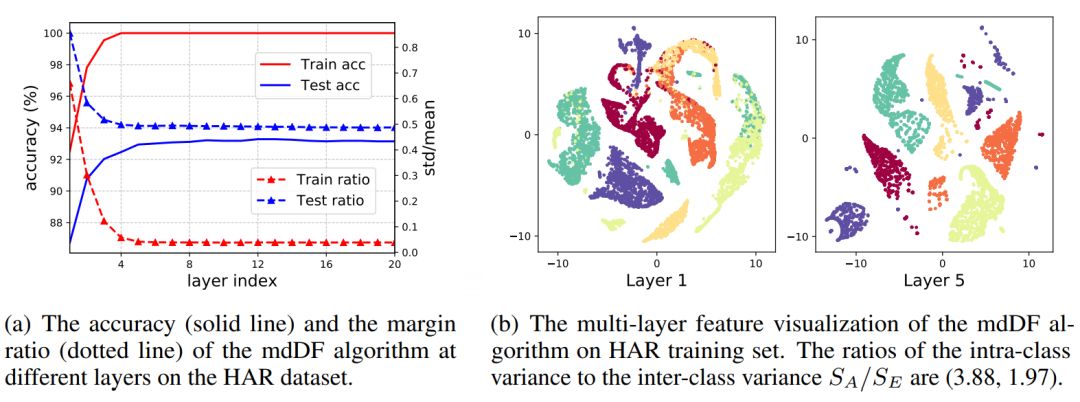

6. A Refined Margin Distribution Analysis for Forest Representation Learning

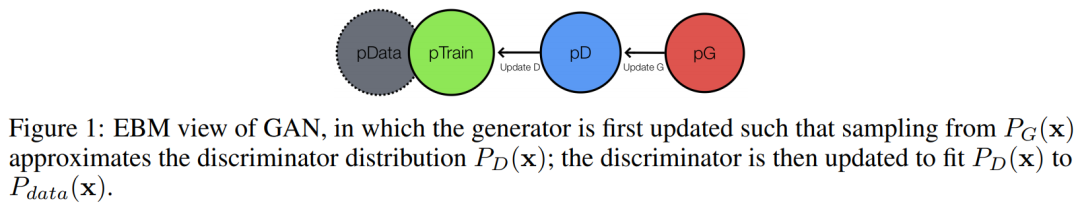

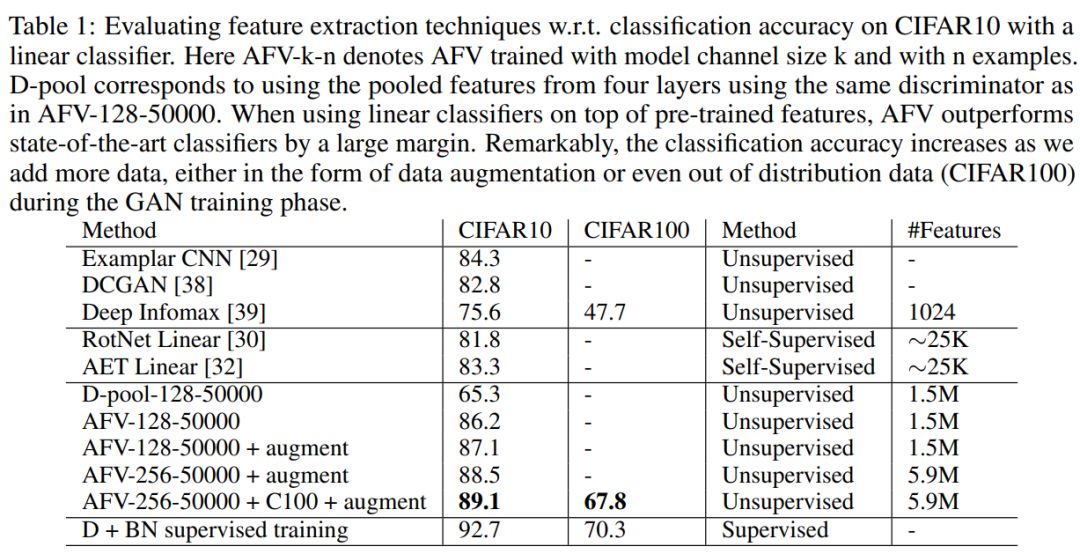

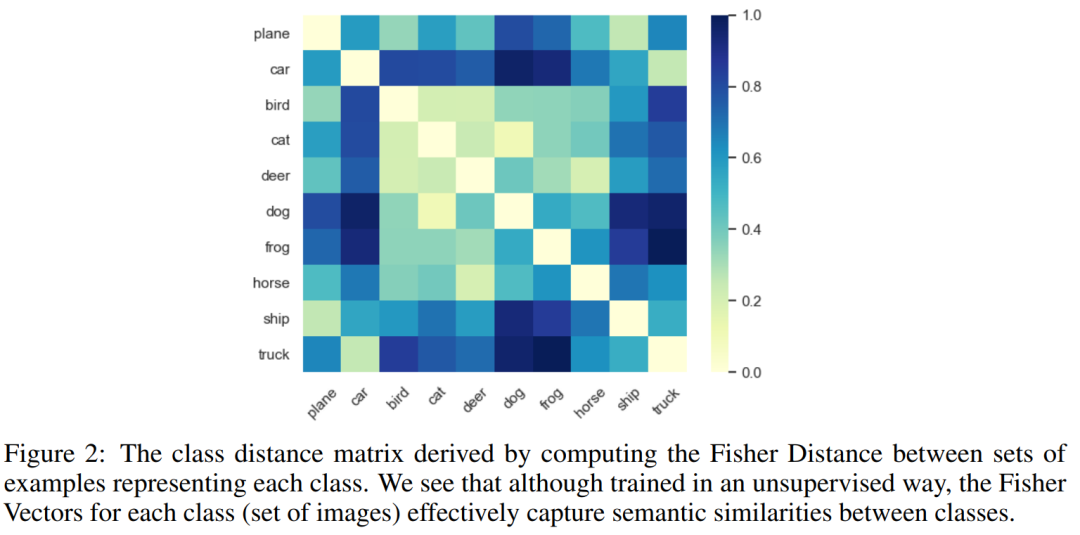

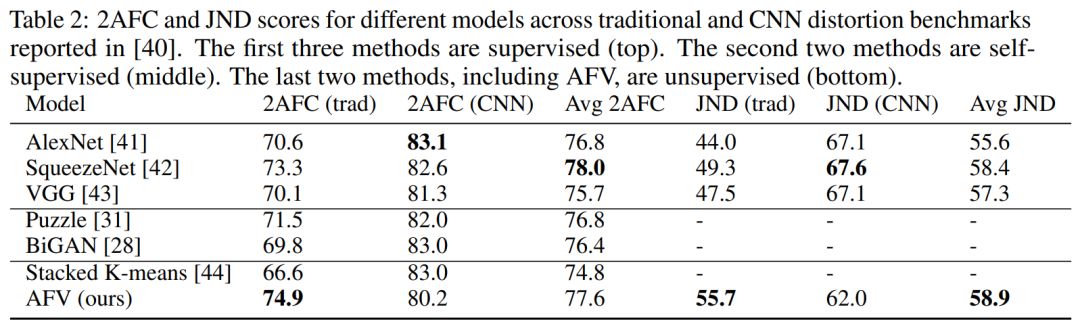

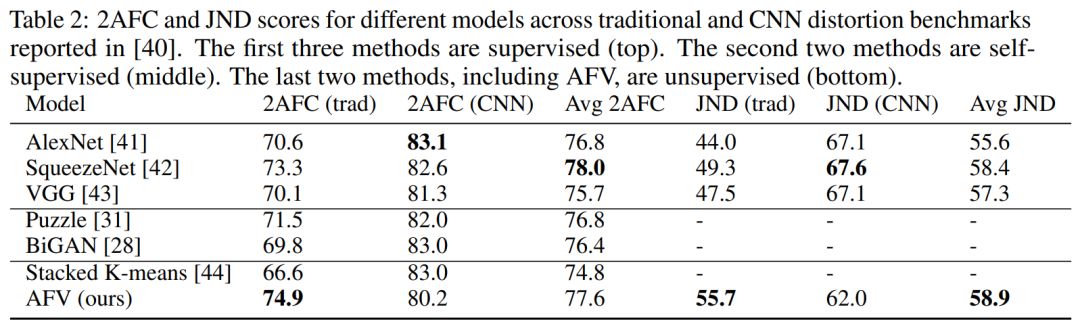

7. Adversarial Fisher Vectors for Unsupervised Representation Learning

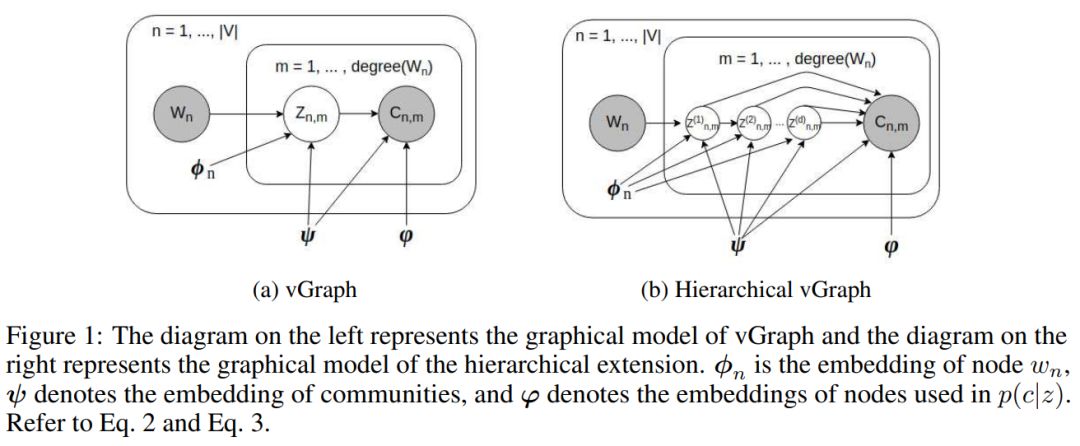

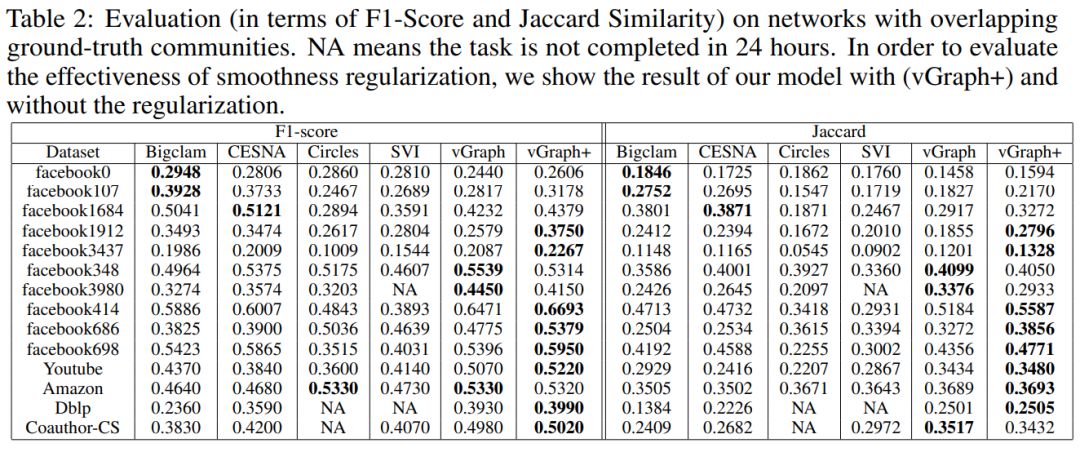

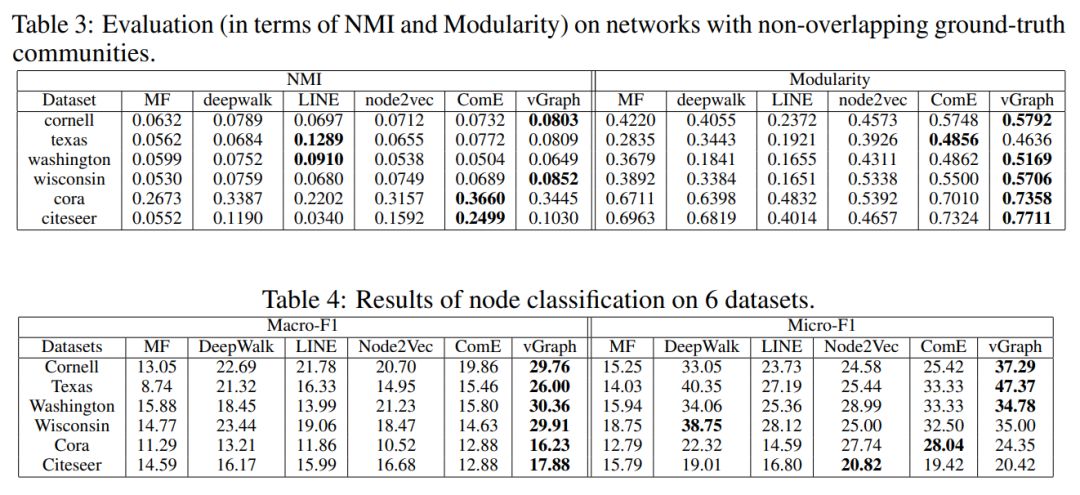

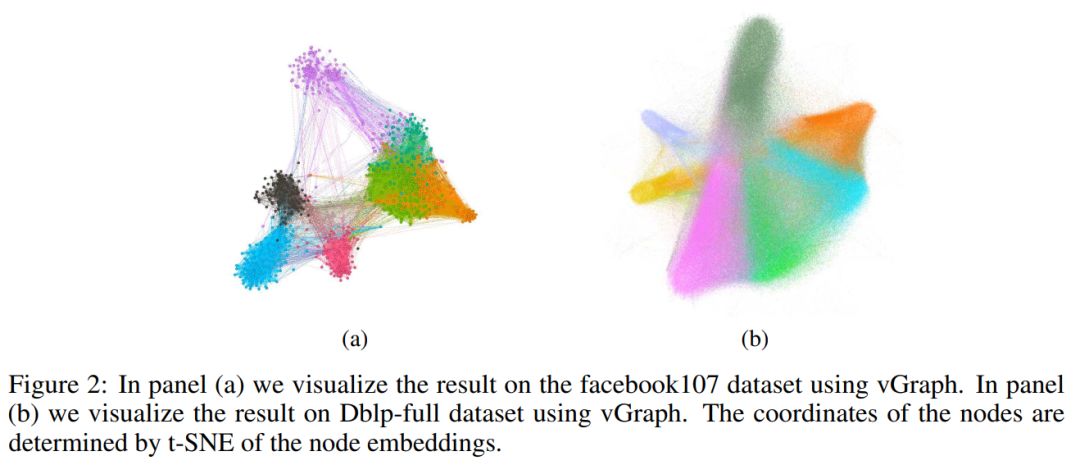

8. vGraph: A Generative Model for Joint Community Detection and Node Representation Learning

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“RLNP” 就可以获取8篇《表示学习》论文下载链接索引~

展开全文