【NeurIPS2019】图变换网络:Graph Transformer Network

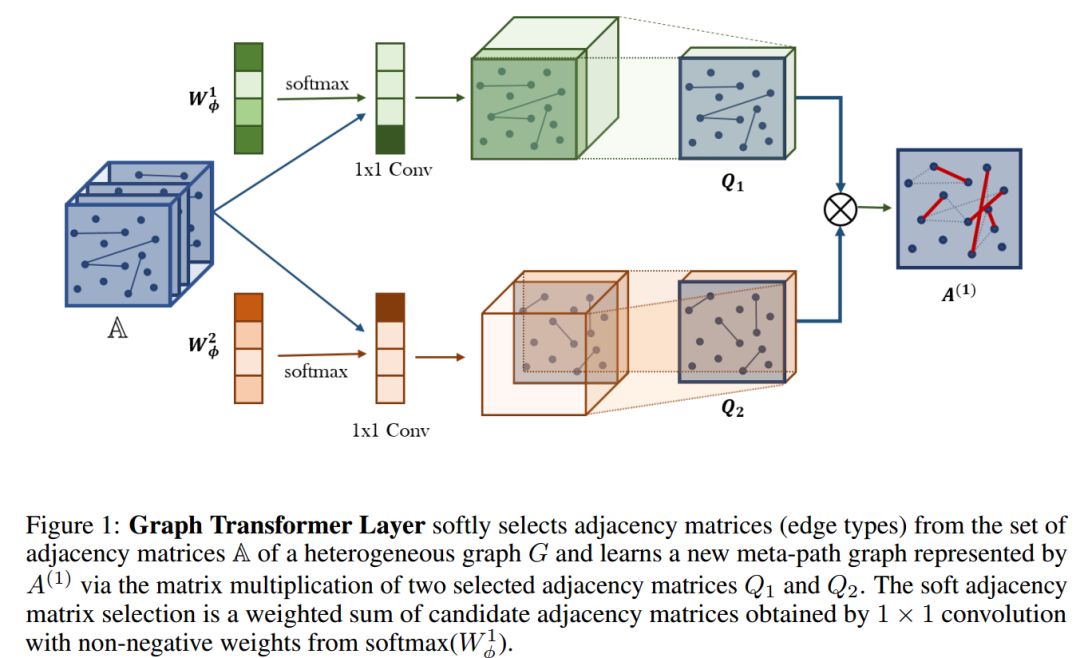

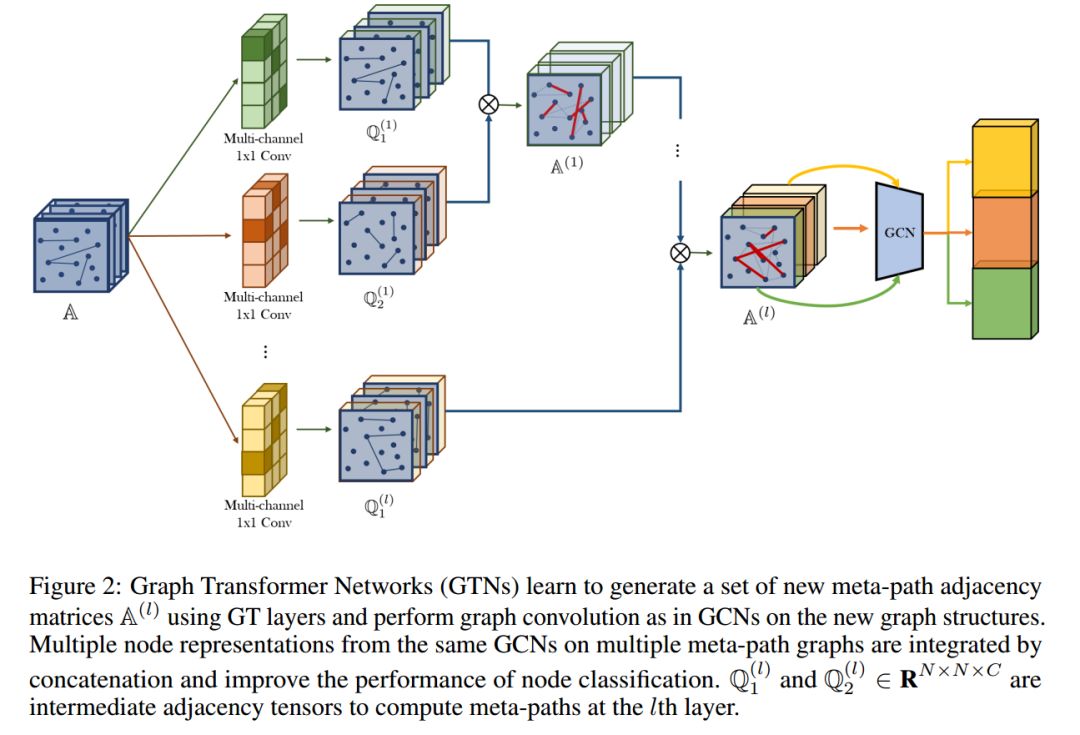

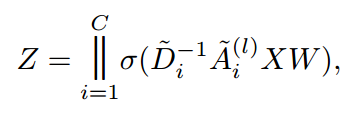

大多数GNN的一个限制是它们假设在固定和同质图的情况下进行GNNs操作。当在不确定的图或由各种类型的节点和边组成的异构(heterogeneous)图上学习表示时,这些限制尤其成问题。本文提出了能够生成新的图结构的图变换网络(Graph Transformer Networks, GTNs),该方法将异构图转化为由任意边类型和任意长度的元路径定义的多个新图,同时通过对学习到的元路径图进行卷积学习节点表示。GTN打破了手工构建元路径的现状,构建了自动化的图生成及表示学习模式。

{

简介

Introduction

}

{

方法

Method

}

{

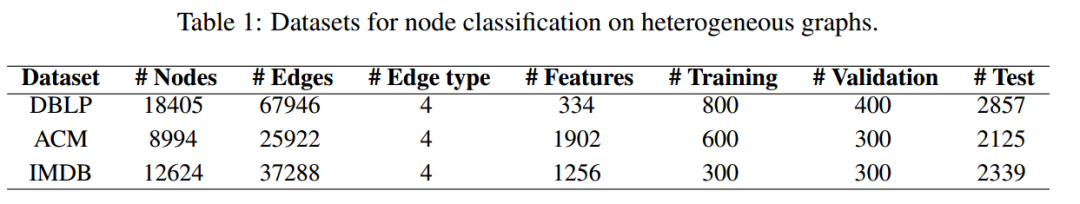

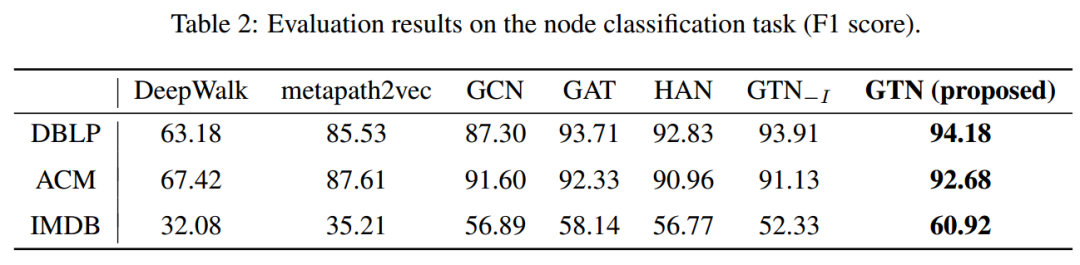

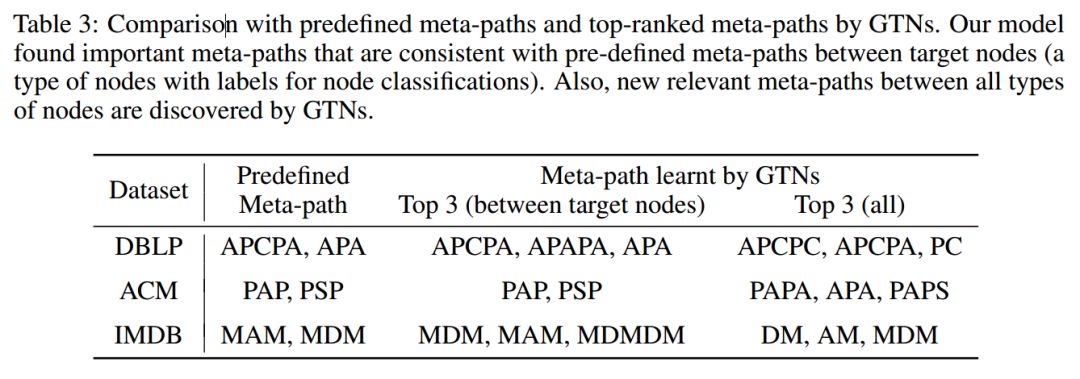

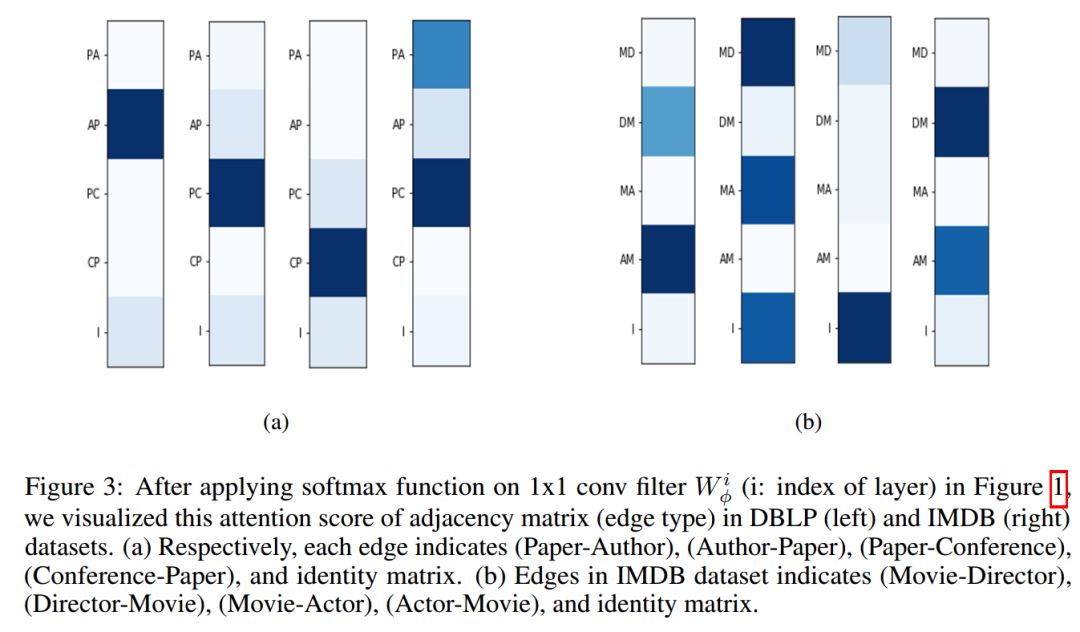

实验

Experiments

}

{

结论

Conclusion

}

展开全文