重磅!Geoffrey Hinton新论文「视觉表示对比学习简单框架」自监督学习建立新SOTA-ImageNet准确率76.5%

【导读】自监督学习是新的研究热点-【AAAI2020图灵奖得主YannLecun】自监督学习Self-Supervised Learning是未来 。近日,深度学习先驱Geoffrey Hinton领衔的Google大脑团队发布了他们在视觉表示对比学习的最新研究成果-SimLCR,建立了新的SOTA视觉ImageNet识别模型,76.5%的top-1准确度,比以前的水平提高了7%,与监督的ResNet-50的性能相当。并有一系列重要的发现:包括(1) 数据增广的组成在定义有效的预测任务中发挥了至关重要的作用,(2) 引入一个可学的非线性变换在视觉表示和对比损失之间大大提高学习表示的质量,和 (3) 与监督学习相比,对比学习受益于更大的批量尺寸和更多的训练步骤,不得不看!

地址:

https://www.zhuanzhi.ai/paper/27304375fe433d3aaba84bd9b0bcbb91

本文提出了一个简单的视觉表示对比学习(contrastive learning)框架。我们简化了最近提出的对比型自监督学习算法,不需要专门的架构或存储库。为了了解是什么使对比预测任务能学习有用的表示,我们系统地研究了我们提出的框架的主要组成部分。我们表明, (1) 数据增广的组成在定义有效的预测任务中发挥了至关重要的作用,(2) 引入一个可学的非线性变换在视觉表示和对比损失之间大大提高学习表示的质量,和 (3) 与监督学习相比,对比学习受益于更大的批量尺寸和更多的训练步骤。结合这些发现,我们能够在很大程度上超越以往的方法,在ImageNet上进行自监督和半监督学习。在SimCLR学习的自监督表示上训练的线性分类器实现了76.5%的top-1准确度,比以前的水平提高了7%,与监督的ResNet-50的性能相当。当仅对1%的标签进行微调时,我们实现了85.8%的前5名准确度,以100倍的标签数超过了AlexNet。

概述

学习没有人类监督的有效视觉表示是一个长期存在的问题。大多数主流方法可分为两类:生成式和判别式。生成式方法学习在输入空间中生成或以其他方式建模像素 (Hinton et al., 2006; Kingma & Welling, 2013; Goodfellow et al., 2014)。然而,像素级的生成在计算上是昂贵的,而且对于表示学习可能不是必需的。判别方法使用与监督学习类似的目标函数来学习表示,但是训练网络执行下游任务,其中输入和标签都来自未标记的数据集。许多这类方法依赖于启发法来设计下游任务(Doersch et al., 2015; Zhang et al., 2016; Noroozi & Favaro, 2016; Gidaris et al., 2018),这可能限制了学习表示的普遍性。基于潜在空间中的对比学习的判别方法最近显示出了巨大的潜力,取得了最先进的结果(Hadsell et al., 2006; Dosovitskiy et al., 2014; Oord et al., 2018; Bachman et al., 2019)。

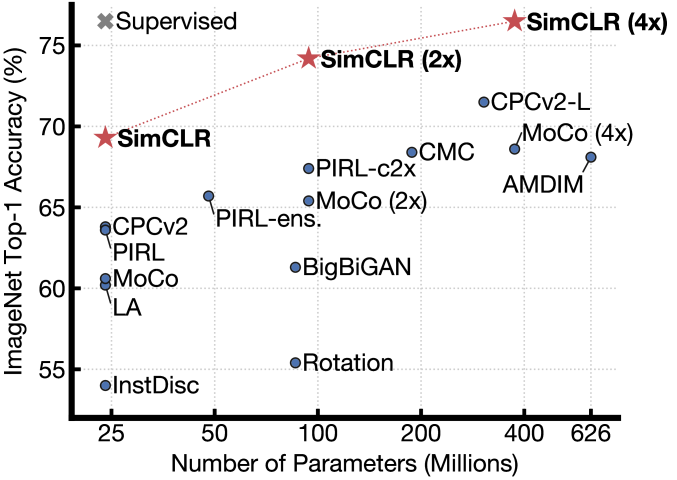

图1: ImageNet top-1在不同自监督方法学习的表示上训练的线性分类器的精度(在ImageNet上预先训练)。灰色十字表示有监督的ResNet-50。我们的方法SimCLR以粗体显示。

在这项工作中,我们介绍了视觉表示对比学习的一个简单框架,我们称之为SimCLR。SimCLR不仅优于以前的工作(图1),而且更简单,不需要专门的架构(Bachman et al., 2019; Hénaff et al., 2019)或者存储池 (Wu et al., 2018; Tian et al., 2019; He et al., 2019a; Misra & van der Maaten, 2019)。

为了了解是什么使好的对比表示学习成为可能,我们系统地研究了我们的框架的主要组成部分,并表明:

[topsep=0pt, partopsep=0pt, leftmargin=13pt, parsep=0pt, itemsep=4pt]

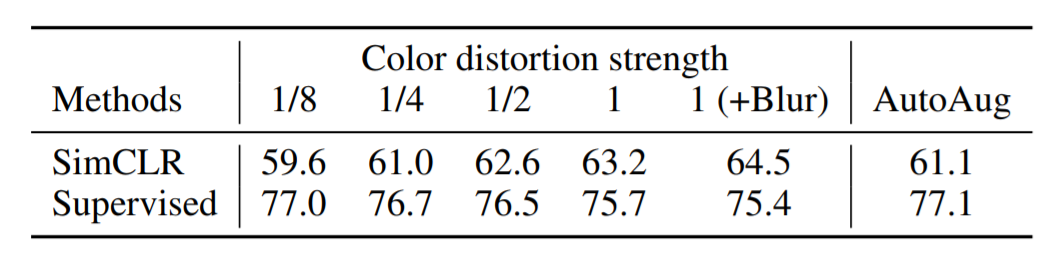

在定义产生有效表示的对比预测任务时,多个数据增强操作的组合是至关重要的。另外,无监督对比学习比监督学习具有更强的数据增强性。

在表示和对比损失之间引入一个可学习的非线性变换,极大地提高了学习表示的质量。

具有对比交叉熵损失的表示法学习得益于归一化嵌入和适当调整的温度参数。

与监督学习相比,对比学习受益于更大的批量和更长的训练。与监督学习一样,对比学习也受益于更深更广的网络。

我们结合这些发现,在ImageNet ILSVRC-2012上实现了一种新的自监督和半监督学习(Russakovsky et al., 2015)。在线性评价方案下,SimCLR达到了76.5%的top-1准确率,相对于之前的最先进水平(Henaff et al., 2019)提高了7%。当仅使用1%的ImageNet标签进行微调时,SimCLR达到了85.8%的top-5准确率,相对提高了10% (Henaff et al., 2019)。当对其他自然图像分类数据集进行微调时,SimCLR在12个数据集中的10个上的表现与强监督基线(Kornblith et al., 2019)相当或更好。

方法

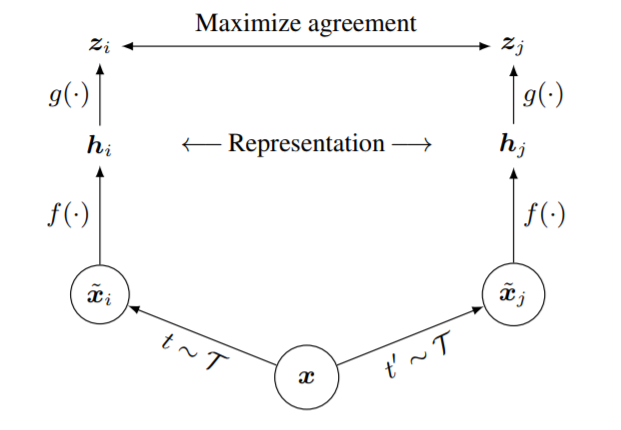

受最近的对比学习算法的启发(见第7节的概述),SimCLR通过通过潜在空间的对比损失最大限度地提高相同数据样本的不同扩充视图之间的一致性来学习表示。如图2所示,该框架包含以下四个主要组件。

图2: 视觉表示对比学习的简单框架。从相同的增广族系(t∼T 和t′∼T) 中采样两个独立的数据增广操作符,并应用于每个数据示例,以获得两个相关的视图。基础网络编码器f(⋅)和投影头g(⋅)训练协议使用对比损失最大化。训练完成后,我们通过投影头g(⋅)和使用编码器h f(⋅)和表示下游任务。

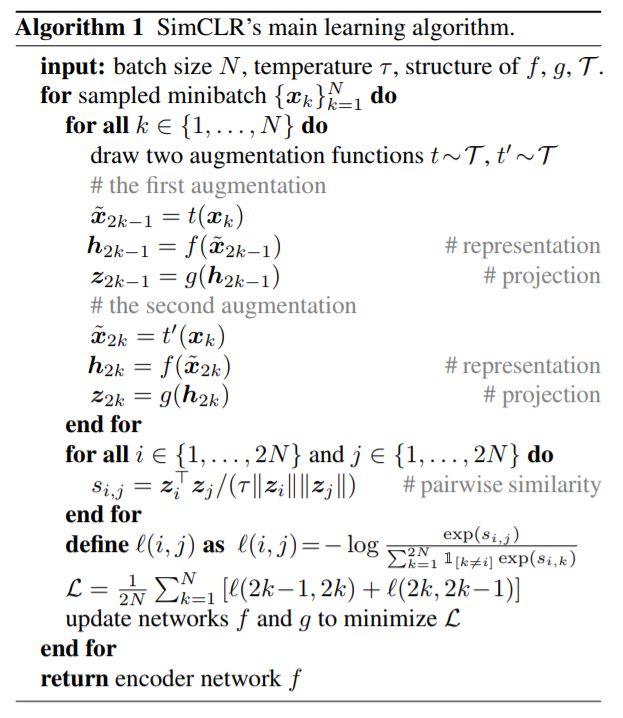

算法1 SimCLR的主要学习算法。

实验结果

1. 数据增强对比表示学习

数据增强定义预测任务。而数据增强在有监督和无监督表示学习中都得到了广泛的应用(Krizhevsky et al., 2012; Hénaff et al., 2019; Bachman et al., 2019),它还没有被认为是一个系统的方式来定义对比预测任务。许多现有的方法通过改变体系结构来定义对比预测任务。如Hjelm et al. (2018); Bachman et al. (2019)通过限制网络架构中的感受域实现全局到局部的视图预测,而Oord et al. (2018); Hénaff et al. (2019) 通过固定的图像分割过程和上下文聚合网络实现邻近视图预测。我们证明,通过对目标图像执行简单的随机裁剪(调整大小),可以避免这种复杂性,从而创建包含上述两个任务的一系列预测任务,如图3所示。这种简单的设计选择方便地将预测任务与其他组件(如神经网络体系结构)解耦。广义的对比预测任务可以通过扩展扩展族并随机组合来定义。

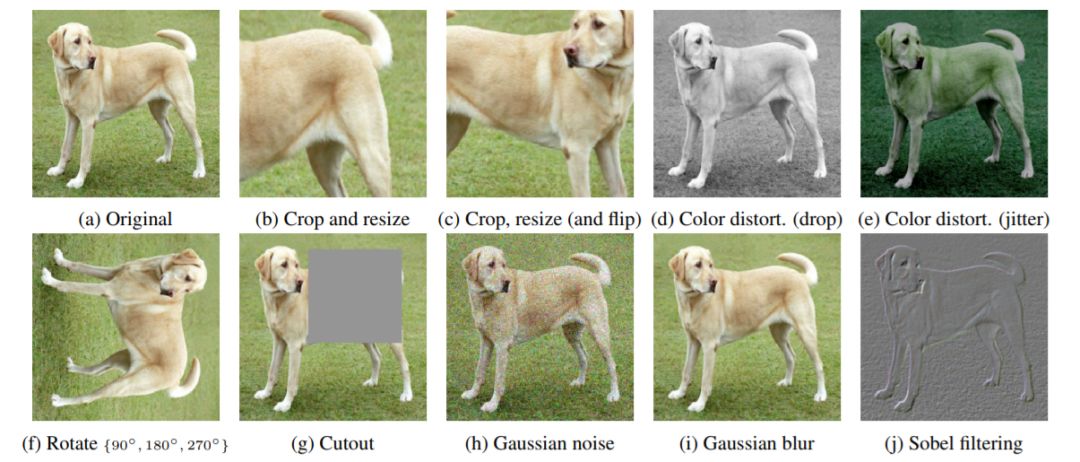

图4: 所研究的数据增强操作的示意图。每个增量都可以随机地利用一些内部参数(如旋转度、噪声水平)对数据进行转换。请注意,我们只在消融中测试这些操作符,用于训练我们的模型的增强策略只包括随机裁剪(通过翻转和调整大小)、颜色失真和高斯模糊

数据增强操作的组合对于学习好的表示非常重要,对比学习需要比监督学习更强的数据增强能力。

2. Architectures for Encoder and Head

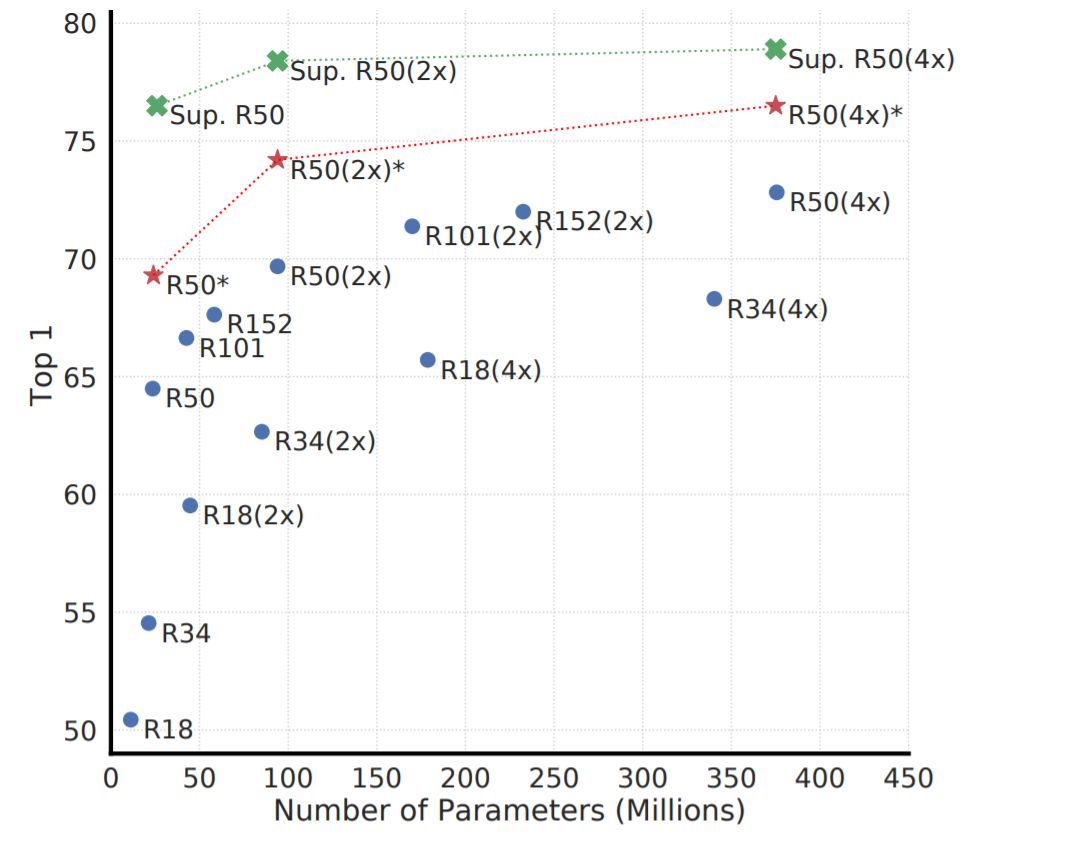

图7: 不同深度和宽度模型的线性评估。蓝点上的模型我们训练了100个epochs,红星上的模型我们训练了1000个epochs,绿十字上的模型我们训练了90个epochs

图7显示,增加深度和宽度都可以提高性能,这也许并不奇怪。虽然类似的发现也适用于监督学习(He et al., 2016),但我们发现,随着模型尺寸的增大,监督模型和在非监督模型上训练的线性分类器之间的差距缩小了,这表明非监督学习从更大的模型中获益更多。

3. Loss Functions and Batch Size

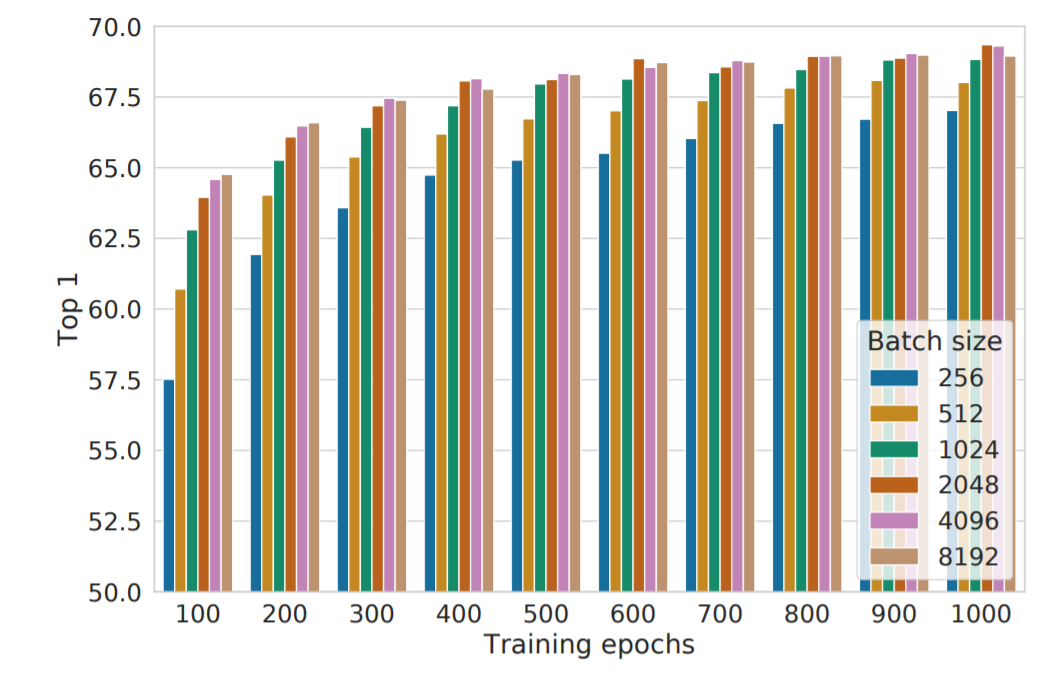

图9: 不同批大小和epoch训练的线性评估模型(ResNet-50)。每个bar都是从零开始的单个运行。

4. SOTA对比结果 Comparison with State-of-the-art

在本小节中,类似于Kolesnikov et al. (2019); He et al. (2019a)将ResNet-50用于3种不同的隐含层宽度(1×、2×和4×的宽度乘法器)。为了更好的收敛,我们这里的模型经过了1000个epochs的训练。

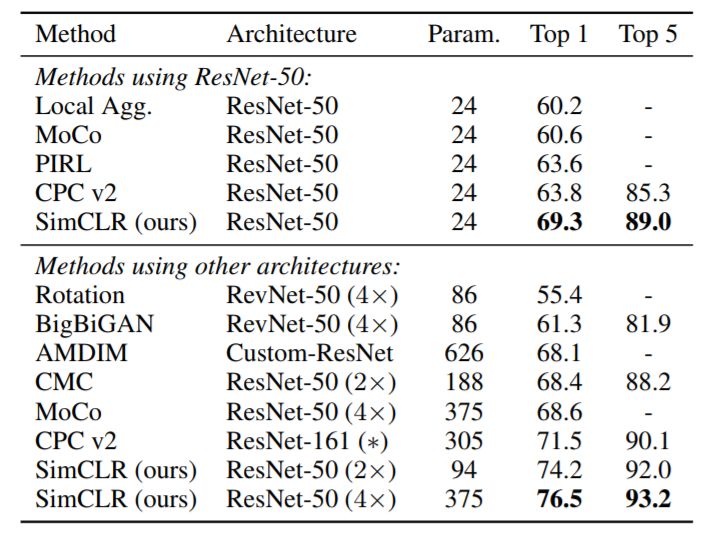

线性评估。表6 给出了在不同设置下我们的方法与以前的方法的比较结果(Zhuang et al., 2019; He et al., 2019a; Misra & van der Maaten, 2019; Hénaff et al., 2019; Kolesnikov et al., 2019; Donahue & Simonyan, 2019; Bachman et al., 2019; Tian et al., 2019)。表1 给出了更多不同方法的数值比较。我们能够使用标准的网络来获得比以前需要专门设计的架构的方法更好的结果。我们的ResNet-50(4×)获得的最佳结果可以与监督预训练的ResNet-50相匹配。

表1:无监督ResNet-50使用线性评价和监督ResNet-50的Top-1准确度。

表6: 基于不同自监督方法学习表示的线性分类器的ImageNet准确度。

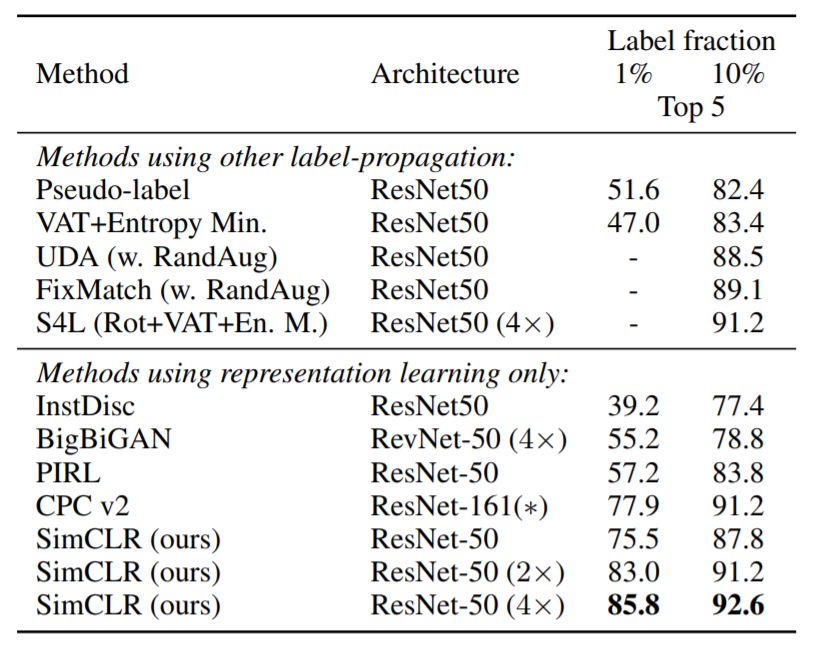

Semi-supervised学习。我们遵循Zhai et al. (2019)的方法,以类平衡的方式进行采样1%或10%的ILSVRC-12训练数据集(每个类分别约12.8和128张图像)。我们只是根据标记的数据对整个基础网络进行微调,而不进行正则化(参见附录B.5)。表7显示了我们的结果与最近方法的比较 (Zhai et al., 2019; Xie et al., 2019; Sohn et al., 2020; Wu et al., 2018; Donahue & Simonyan, 2019; Misra & van der Maaten, 2019; Hénaff et al., 2019)。同样,我们的方法在1%和10%的标签的基础上有了显著的改进。

表7: 少标签训练模型的ImageNet准确度。

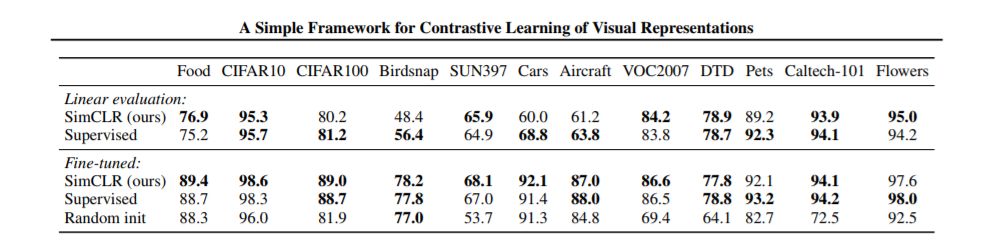

迁移学习。我们评估了12个自然图像数据集的线性评估(固定特征提取器)和微调设置下的迁移学习性能。在Kornblith et al. (2019)之后,我们对每个模型-数据集组合执行超参数调优,并在验证集上选择最佳超参数。表8 显示了ResNet-50(4×)模型的结果。当进行微调时,我们的自监督模型在5个数据集上显著优于监督基线,而监督学习仅在2个数据集(即宠物和鲜花)获胜。在剩下的5个数据集上,模型在统计上是恒定的。附录B.6提供了标准ResNet-50体系结构的完整实验细节和结果。

我们注意到,我们的框架相对于以前的工作的优越性不是由任何单一的设计选择来解释的,而是由它们的组成来解释的。我们提供了一个全面的比较,我们的设计选择与那些以前的工作在附录C。

表8: 在ImageNet上预训练的ResNet-50(4×)模型中,我们的自监督方法与12个自然图像分类数据集上的监督基线的转移学习性能比较。

结论

在本工作中,我们提出了一个用于对比视觉表示学习简单的框架及其实例。我们仔细研究了它的组件,并展示了不同设计选择的影响。通过结合我们的发现,我们在很大程度上改进了以前的自监督、半监督和迁移学习的方法。

我们的研究结果表明,以往的一些自监督学习方法的复杂性并不是获得良好学习效果的必要条件。我们的方法不同于ImageNet上的标准监督学习,只是在选择数据增强,在网络的末端使用一个非线性头,和损失函数。这一简单框架的强大之处在于,尽管近来人们对自监督学习的兴趣激增,但它的价值仍然被低估了。

更多方法细节请下载论文查看,专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“LCR” 就可以获取《视觉表示对比学习简单框架》论文专知下载链接