【AAAI2020论文】用于视觉对话中深度视觉理解的自适应双向编码模型—DualVD, 中科院信工所于静等

代码链接:https://github.com/JXZe/DualVD

论文链接:https://arxiv.org/abs/1911.07251

https://www.zhuanzhi.ai/paper/7cc3f5370a3c66f24e557fdf412c4f79

动机

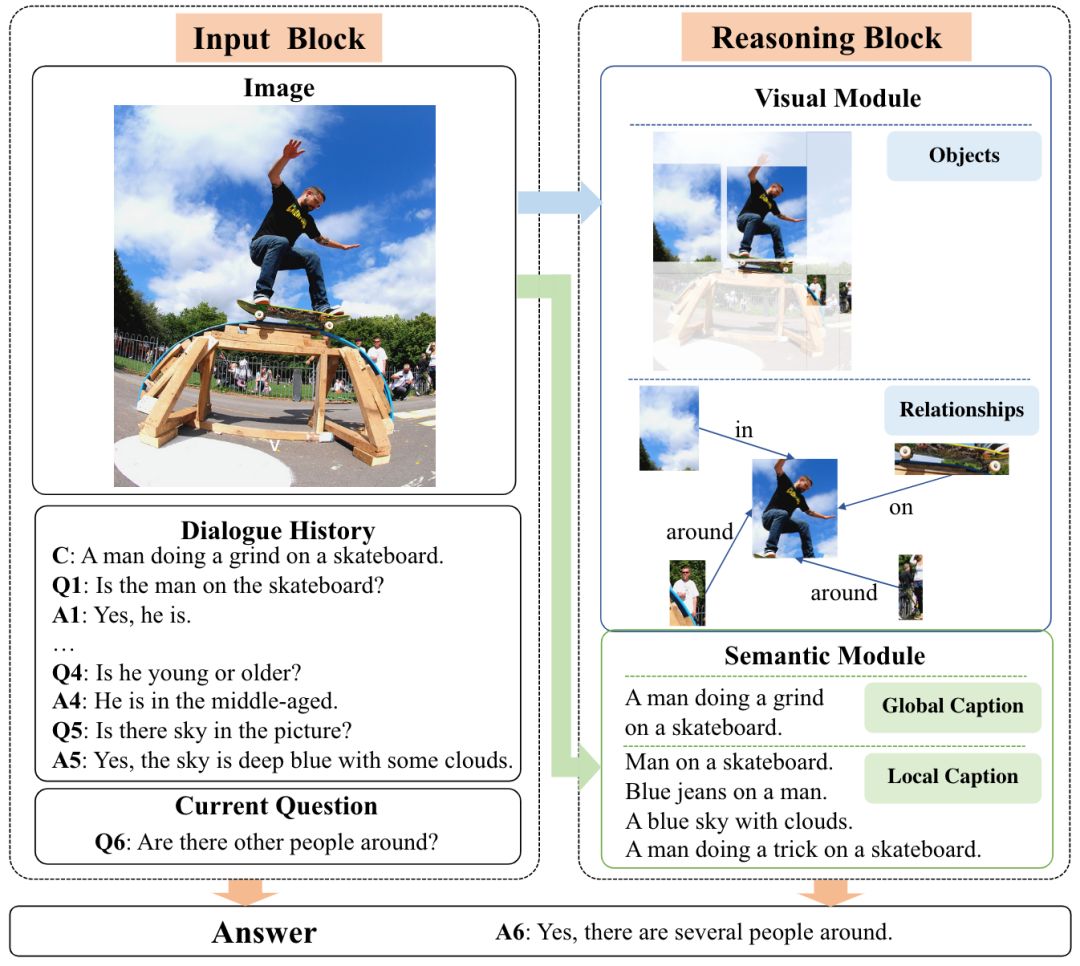

综合分析语言和视觉等不同模态数据,对现实世界中的知识实现更加泛化的分析和推理,对推动人工智能的发展具有重要意义。近年来,跨媒体分析取得了显著进展,包括跨媒体检索、视觉问答、指代理解、图像描述生成、视觉对话等。其中,视觉对话任务要求模型根据图像、图像描述、对话历史回答当前问题。相比其他视觉-语言任务中主要关注特定的视觉目标或区域,视觉对话需要模型根据对话的推进,不断调整视角,关注问题涉及的多样的视觉信息。比如回答图1中的问题“Q1: Is the man on the skateboard?”,需要模型关注“the man”、“the skateboard”等前景信息,而问题“Q5: Is there sky in the picture?”又将视角转移到背景信息“sky”。除了Q1和Q5这类涉及表象层面(appearance-level)的问题,问题“Q4: Is he young or older?”又需要推理视觉内容得到高层语义信息。因此,如何在对话过程中自适应地捕获回答问题所需的视觉线索是视觉对话中的重要挑战之一。

核心思想

认知学中双向编码理论(Dual-Coding Theory)认为:人类大脑编码信息包括两种方式,即视觉表象和关联文本. 当被问到某个概念时,大脑会检索相关的视觉信息、语言信息或综合考虑上述两种信息。这种双向编码方式能够增强大脑的记忆和理解能力。作者受该理论启发,首先提出了一种从视觉和语义两方面刻画图像信息的新框架:视觉模块刻画图像中的主体目标和目标间的视觉关系,语义模块刻画图像中抽象的局部和全局高层语义信息。基于上述框架,作者提出了一种自适应视觉信息选择模型DualVD (Dual Encoding Visual Dialogue):(1)模态内信息选择:由问题驱动,分别在视觉模块和语义模块中获得独立线索;(2)模态间信息选择:由问题驱动,获得视觉-语义的联合线索。

提出一种刻画图像信息的新框架,涵盖视觉对话中广泛的视觉内容;

提出一种自适应视觉信息选择模型,并支持显示地解释信息选择过程;

多个数据集上的实验结果显示,该模型优于大部分现有工作。

模型设计

视觉对话任务定义:给定图像I,图像描述C和t-1轮的对话历史Ht={C,(Q1,A1),...,(Qt-1,At-1)}, 以及当前轮问题Q,该任务要求从100个候选答案A=(A1,A2,...,A100) 中选择最佳答案。

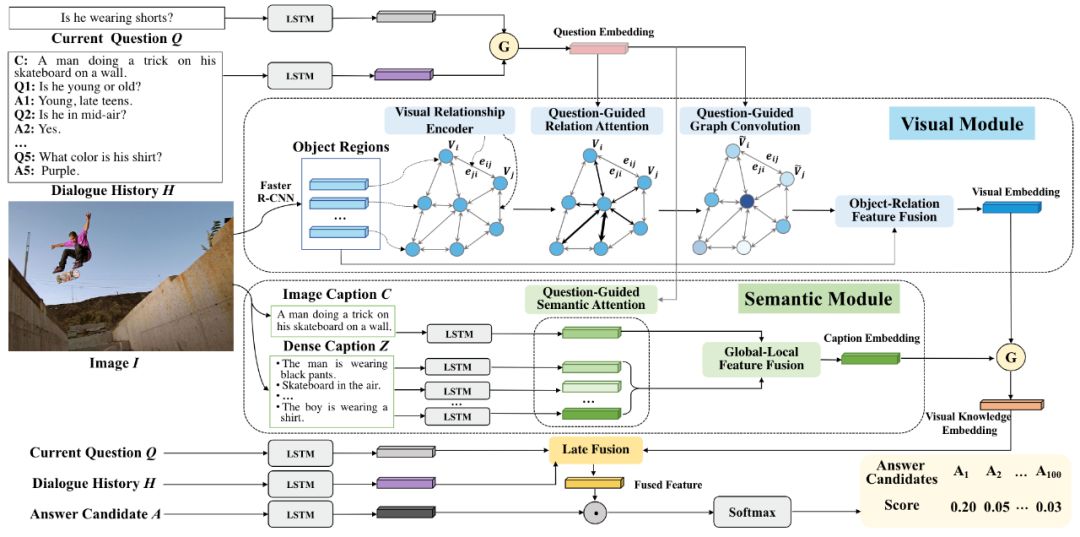

DualVD模型结构如图2所示,模型核心结构分为两部分:Visual-Semantic Dual Encoding和Adaptive Visual-Semantic Knowledge Selection。

图2 DualVD模型结构图

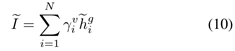

Scene Graph Construction:将每幅图像表示为一个场景图,同时刻画图像的目标和视觉关系信息。采用Faster-RCNN提取图像中N个目标区域,构成场景图上的结点,结点i的特征定义为hi;采用Zhang等提出的视觉关系编码器在GQA数据集上预训练,将给定图像中任何两个目标区域间的视觉关系编码为关系向量,构成场景图上的边,结点i和结点j间的关系向量定义为rij。相比现有方法采用关系类别表示场景图的边,作者考虑了视觉关系的多样性、歧义性,采用关系的嵌入表示能够更准确表达目标间的视觉关系。

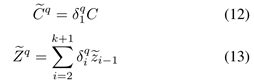

Multi-level Image Captions:将每幅图像表示为多层面的语义描述,同时刻画图像的局部和全局语义信息。相比视觉特征,语言描述的优势在于能够更直接的为问题提供线索,避免了不同模态数据间的“异构鸿沟”。作者采用数据集提供的图像描述作为图像的全局语义信息;采用Feifei Li等提出的DenseCap提取描述细节的k条dense captions作为图像的局部语义信息。对全局和局部信息分别采用不同的LSTM提取特征,分别表示为C~和Z~={z1,z2,...,zk}。

Visual Module

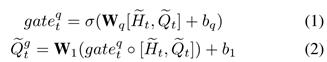

(1) uestion-guided relation attention: 基于问题引导,捕获和问题最相关的视觉关系。首先,通过门控机制从对话历史中选择问题相关的信息更新问题表示:

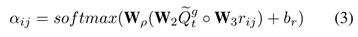

基于问题新表示Qtg的引导,计算场景图中每个关系的注意力:

基于注意力aij,更新场景图中每个关系的嵌入表示:

(2) Question-guided graph convolution: 模块首先采用基于关系的图注意力网络(Relation-based GAT)获得感知视觉关系的目标表示。首先,对于场景图中的结点,计算该借点对邻居结点j在关系rij条件下的注意力:

基于注意力βij更新场景图中每个结点的特征表示:

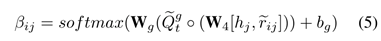

(3) Object-relation Information fusion: 采用门控机制融合感知关系的结点表示和原始结点表示:

Semantic Module

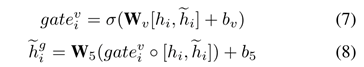

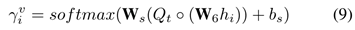

(1) Question-guided semantic attention: 基于问题引导,对全局和局部语义描述mi∈{C,z1,z2,...,zk}计算注意力分布:

基于注意力δiq分别更新全局和局部语义表示:

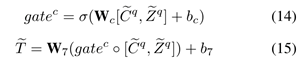

(2) Global-local information fusion: 采用门控机制融合全局语义表示和局 部语义表示:

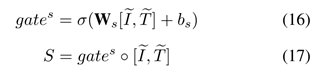

(3) Selective Visual-Semantic Fusion: 当被提问时,模型能够检索相关的视觉信息、语言信息或综合考虑上述两种信息。作者采用门控机制控制两种信息源对于回答问题的贡献,并获得最终的图像表示:

实现结果

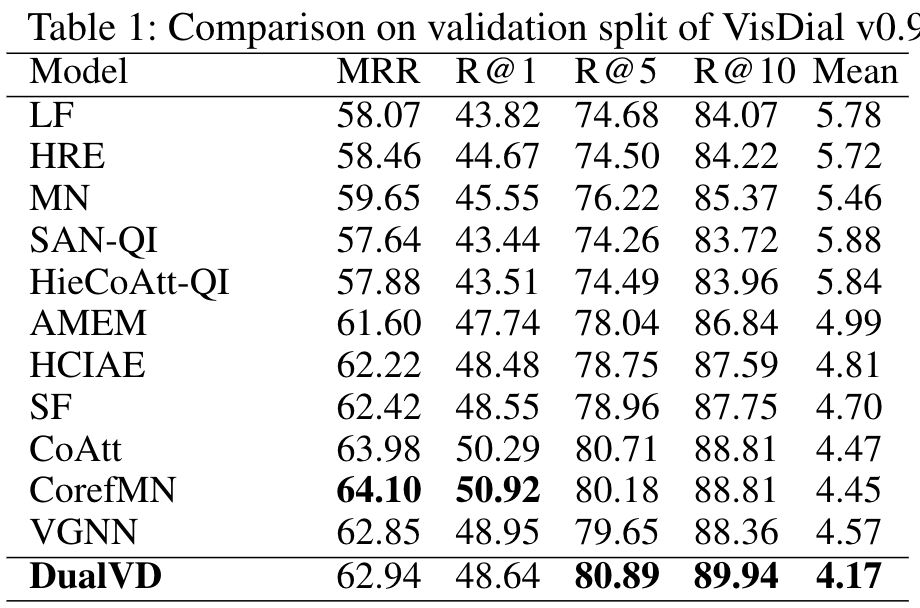

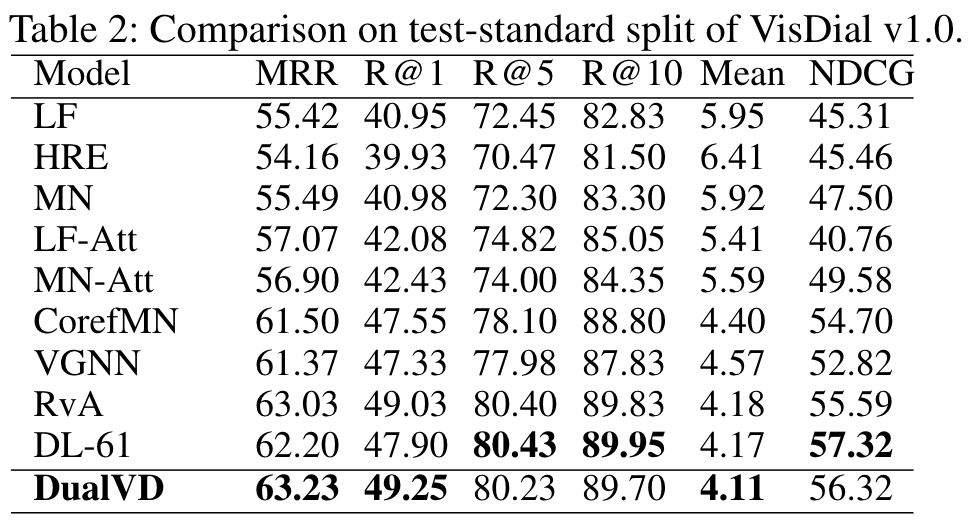

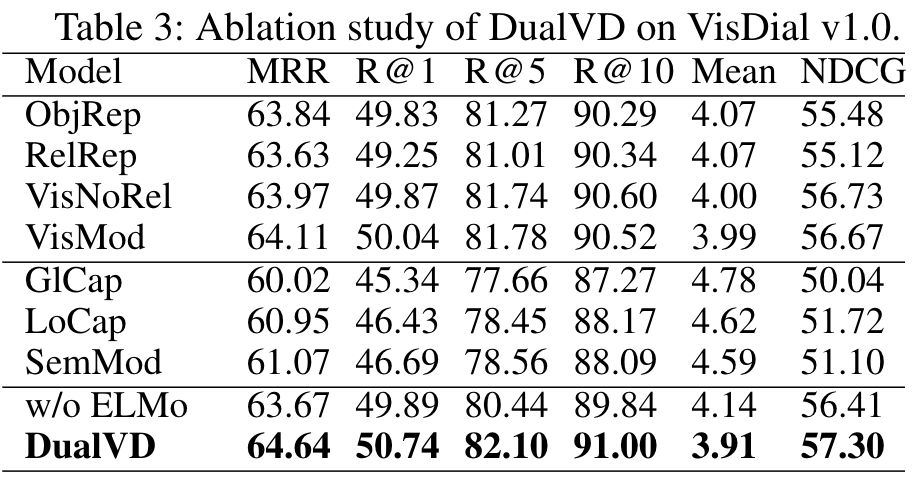

作者在VisDial v0.9和VisDial v1.0上对模型的效果进行了验证。

State-of-the-art comparison

Ablation Study

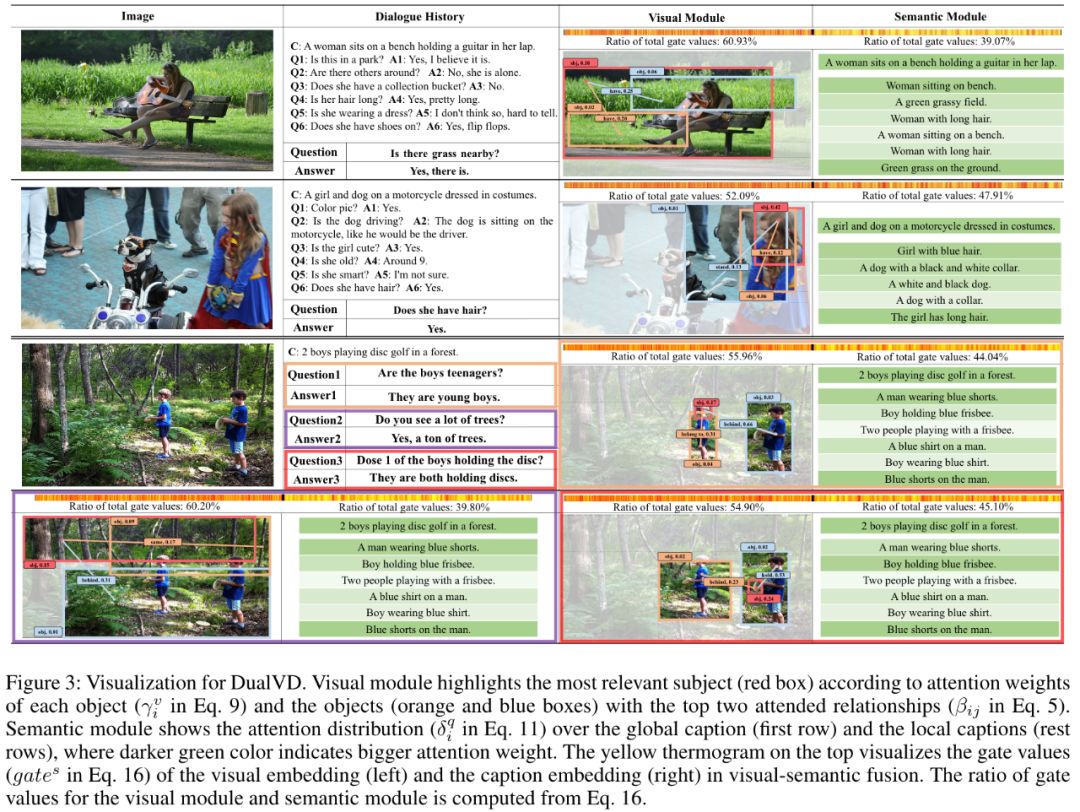

Interpretability

该模型的一个优势是具有较强的可解释性,通过对attention weight、gate value的可视化,能够显示分析模型特征选择的过程。部分可视化结果如图3所示,。作者通过大量可视化结果分析得出以下观察:

视觉信息和语义信息对于回答问题的贡献取决于问题的复杂性和信息源的相关性。涉及到目标表象信息的问题,模型会从视觉信息获得更多线索,例如图3中第一个个例子;当问题涉及到更加复杂的关系推理,或者语义信息包含了直接线索时,模型会倾向于从依赖语义信息中寻求答案,例如图3中的第二个例子。

视觉信息将为回答问题提供更重要的依据。作者观察了所有测试数据后发现,来自视觉模块的累积gate value总是高于来自语义模块的累积gate value,表明在视觉对话任务中图像信息仍是回答问题的关键,对图像信息更准确、更全面的理解对于提升模型的对话能力十分重要。

模型能够根据问题的变化,自适应调整关注的信息。在多轮对话中,如图3中的第三个例子,随着对话的推进,问题涉及前景、背景、语义关系等广泛的视觉内容,DualVD都能够有效捕捉到关键线索。

原文链接:

https://arxiv.org/pdf/1911.07251.pdf

代码链接:

https://github.com/JXZe/DualVD

更多AAAI2020论文请关注登录专知网站www.zhuanzhi.ai, 实时更新关注:

https://www.zhuanzhi.ai/topic/2001676361262408/vip