Keras作者推荐开源项目transformers,包含BERT等多种NLP架构及预训练模型,Github获1.6万+星

【导读】Keras作者François Chollet喜欢在Twitter上推荐一些精致且实用的项目。这次他推荐了Hugging Face的开源项目transformers,面向TF2.0和PyTorch,可以用3行代码训练顶尖NLP模型。

Keras作者François Chollet在Twitter上推荐了Hugging Face的transformers项目:

该项目的Github地址为:

https://github.com/huggingface/transformers

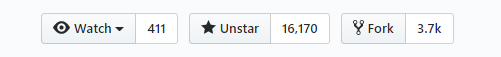

目前该项目已获1.6万+stars:

项目特性如下:

总体

和pytorch-transformers一样简单

和Keras一样强大和精简

在NLU和NLG任务上具有很高的性能

对教育者和练习者没有负担

每个人都能构建顶尖模型

深度学习研究者

上手的练习者

AI/ML/NLP的老师和教育者

低计算消耗,更少的排放量

研究者可以分享训练的模型,而不是总是重新训练

参与者可以减少计算时间和产品消耗

10种架构,30多种预训练模型,有些包含了100种语言支持

为模型生命周期的每个部分选择正确的框架

用3行代码训练顶尖模型

TensorFlow 2.0和PyTorch模型之间的深度互用性

将简单模型在TF2.0和PyTroch之间互换

在训练、评价和生产阶段无缝地选择正确的框架

更多信息可以参考项目Github链接。

参考链接:

https://github.com/huggingface/transformers

https://medium.com/tensorflow/using-tensorflow-2-for-state-of-the-art-natural-language-processing-102445cda54a

展开全文