【Science最新论文】XAI—可解释人工智能简述,机遇与挑战

【导读】最新的一期《Science》机器人杂志刊登了关于XAI—Explainable artificial intelligence专刊,涵盖可解释人工智能的简述论文,论述了XAI对于改善用户理解、信任与管理AI系统的重要性。并包括5篇专刊论文,值得一看。

可解释性对于用户有效地理解、信任和管理强大的人工智能应用程序是至关重要的。

https://robotics.sciencemag.org/content/4/37/eaay7120

最近在机器学习(ML)方面的成功引发了人工智能(AI)应用的新浪潮,为各种领域提供了广泛的益处。然而,许多这些系统中不能向人类用户解释它们的自主决策和行为。对某些人工智能应用来说,解释可能不是必要的,一些人工智能研究人员认为,强调解释是错误的,太难实现,而且可能是不必要的。然而,对于国防、医学、金融和法律的许多关键应用,解释对于用户理解、信任和有效地管理这些新的人工智能合作伙伴是必不可少的(参见最近的评论(1-3))。

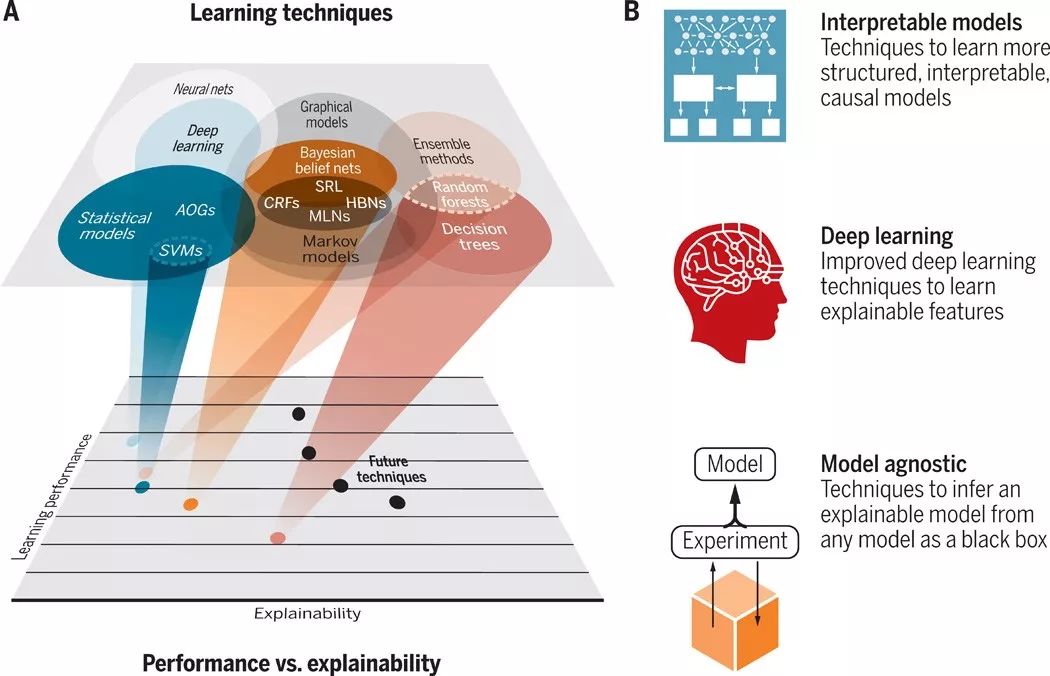

最近人工智能的成功很大程度上归功于在其内部表示中构造模型的新ML技术。其中包括支持向量机(SVMs)、随机森林、概率图形模型、强化学习(RL)和深度学习(DL)神经网络。尽管这些模型表现出了高性能,但它们在可解释性方面是不透明的。ML性能(例如,预测准确性)和可解释性之间可能存在固有的冲突。通常,性能最好的方法(如DL)是最不可解释的,而最可解释的方法(如决策树)是最不准确的。图1用一些ML技术的性能可解释性权衡的概念图说明了这一点。

图1 ML技术的性能与可解释性权衡。

(A)学习技巧和解释能力。(B)可解释模型:学习更结构化、可解释或因果模型的ML技术。早期的例子包括贝叶斯规则列表、贝叶斯程序学习、因果关系的学习模型,以及使用随机语法学习更多可解释的结构。深度学习:一些设计选择可能产生更多可解释的表示(例如,训练数据选择、架构层、损失函数、正则化、优化技术和训练序列)。模型不可知论者:对任意给定的ML模型(如黑箱)进行试验以推断出一个近似可解释的模型的技术。

什么是XAI?

一个可解释的人工智能(XAI)系统的目的是通过提供解释使其行为更容易被人类理解。有一些通用原则可以帮助创建有效的、更人性化的人工智能系统:XAI系统应该能够解释它的能力和理解;解释它已经做了什么,现在正在做什么,接下来会发生什么; 披露其所依据的重要信息(4)。

然而,每一个解释都是根据AI系统用户的任务、能力和期望而设置的。因此,可解释性和可解释性的定义是与域相关的,并且可能不是与域独立定义的。解释可以是全面的,也可以是片面的。完全可解释的模型给出了完整和完全透明的解释。部分可解释的模型揭示了其推理过程的重要部分。可解释模型服从根据域定义的“可解释性约束”(例如,某些变量和相关变量的单调性服从特定关系),而黑箱或无约束模型不一定服从这些约束。部分解释可能包括变量重要性度量、局部模型(在特定点近似全局模型)和显著性图。

来自用户的期望

XAI假设向最终用户提供一个解释,该用户依赖于AI系统所产生的决策、建议或操作,然而可能有许多不同类型的用户,通常在系统开发和使用的不同时间点(5)。例如,一种类型的用户可能是智能分析师、法官或操作员。但是,需要对系统进行解释的其他用户可能是开发人员或测试操作员,他们需要了解哪里可能有改进的地方。然而,另一个用户可能是政策制定者,他们试图评估系统的公平性。每个用户组可能有一个首选的解释类型,能够以最有效的方式交流信息。有效的解释将考虑到系统的目标用户组,他们的背景知识可能不同,需要解释什么。

可操作性——评估和测量

一些方法提出了一些评价和衡量解释有效性的方法;然而,目前还没有通用的方法来衡量XAI系统是否比非XAI系统更容易被用户理解。其中一些度量是用户角度的主观度量,例如用户满意度,可以通过对解释的清晰度和实用性的主观评级来度量。解释有效性的更客观的衡量标准可能是任务绩效; 即,这样的解释是否提高了用户的决策能力?可靠和一致的测量解释的影响仍然是一个开放的研究问题。XAI系统的评价和测量包括评价框架、共同点[不同的思维和相互理解(6)]、常识和论证[为什么(7)]。

XAI -问题和挑战

在ML和解释的交集处仍然存在许多活跃的问题和挑战。

1) 从电脑开始还是从人开始(8). XAI系统应该针对特定的用户进行解释吗?他们应该考虑用户缺乏的知识吗?我们如何利用解释来帮助交互式和人在循环的学习,包括让用户与解释交互以提供反馈和指导学习?

2) 准确性与可解释性。XAI解释研究的一条主线是探索解释的技术和局限性。可解释性需要考虑准确性和保真度之间的权衡,并在准确性、可解释性和可处理性之间取得平衡。

3) 使用抽象来简化解释。高级模式是在大步骤中描述大计划的基础。对抽象的自动发现一直是一个挑战,而理解学习和解释中抽象的发现和共享是当前XAI研究的前沿。

4) 解释能力与解释决策。有资格的专家精通的一个标志是他们能够对新情况进行反思。有必要帮助终端用户了解人工智能系统的能力,包括一个特定的人工智能系统有哪些能力,如何衡量这些能力,以及人工智能系统是否存在盲点;也就是说,有没有一类解是永远找不到的?

从以人为本的研究视角来看,对能力和知识的研究可以使XAI超越解释特定XAI系统和帮助用户确定适当信任的角色。未来,XAIs可能最终会扮演重要的社会角色。这些角色不仅包括向个人学习和解释,而且还包括与其他代理进行协调以连接知识、发展跨学科见解和共同点、合作教授人员和其他代理,以及利用以前发现的知识来加速知识的进一步发现和应用。从这样一个知识理解和生成的社会视角来看,XAI的未来才刚刚开始。

本期刊论文

Explainable robotics in science fiction

我们会相信机器人吗?科幻小说说没有,但可解释的机器人可能会找到方法。

A tale of two explanations: Enhancing human trust by explaining robot behavior

最适合促进信任的解释方法不一定对应于那些有助于最佳任务性能的组件。

A formal methods approach to interpretable reinforcement learning for robotic planning

形式化的强化学习方法能从形式化的语言中获得回报,并保证了安全性。

An autonomous untethered fast soft robotic insect driven by low-voltage dielectric elastomer actuators

参考文献:

1. W. Samek, G. Montavon, A. Vedaldi, L. K. Hansen, K. R. Muller, Explainable AI: Interpreting, Explaining and Visualizing Deep Learning (Springer Nature, 2019).

Google Scholar

2. H. J. Escalante, S. Escalera, I. Guyon, X. Baró, Y. Güçlütürk, U. Güçlü, M. van Gerven, Explainable and Interpretable Models in Computer Vision and Machine Learning (Springer, 2018).

3. O. Biran, C. Cotton, Explanation and justification in machine learning: A survey, paper presented at the IJCAI-17 Workshop on Explainable AI (XAI), Melbourne, Australia, 20 August 2017.

4. Intelligibility and accountability: Human considerations in context-aware systems.Hum. Comput. Interact. 16, 193–212 (2009).

5. T. Kulesza, M. Burnett, W. Wong, S. Stumpf, Principles of explanatory debugging to personalize interactive machine learning, in Proceedings of the 20th International Conference on Intelligent User Interfaces (ACM, 2015), pp. 126–137.

6. H. H. Clark, S. E. Brennan, Grounding in communication, in Perspectives on Socially Shared Cognition, L. B. Resnick, J. M. Levine, S. D. Teasley, Eds. (American Psychological Association, 1991), pp. 127–149.

7. D. Wang, Q. Yang, A. Abdul, B. Y. Lim, Designing theory-driven user-centric explainable AI, in Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems (ACM, 2019), paper no. 601.

↵

8. Explanation in artificial intelligence: Insights from the social sciences. Artif. Intell. 267, 1–38(2018).

9. D. Gunning, Explainable artificial intelligence (XAI), DARPA/I2O;www.cc.gatech.edu/~alanwags/DLAI2016/(Gunning)%20IJCAI-16%20DLAI%20WS.pdf.

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“XAIS” 就可以获取《可解释人工智能论文》论文下载链接索引~