【NIPS2017】Google大脑负责人 Jeff dean 演讲机器学习与硬件系统的相互促进

点击上方“专知”关注获取专业AI知识!

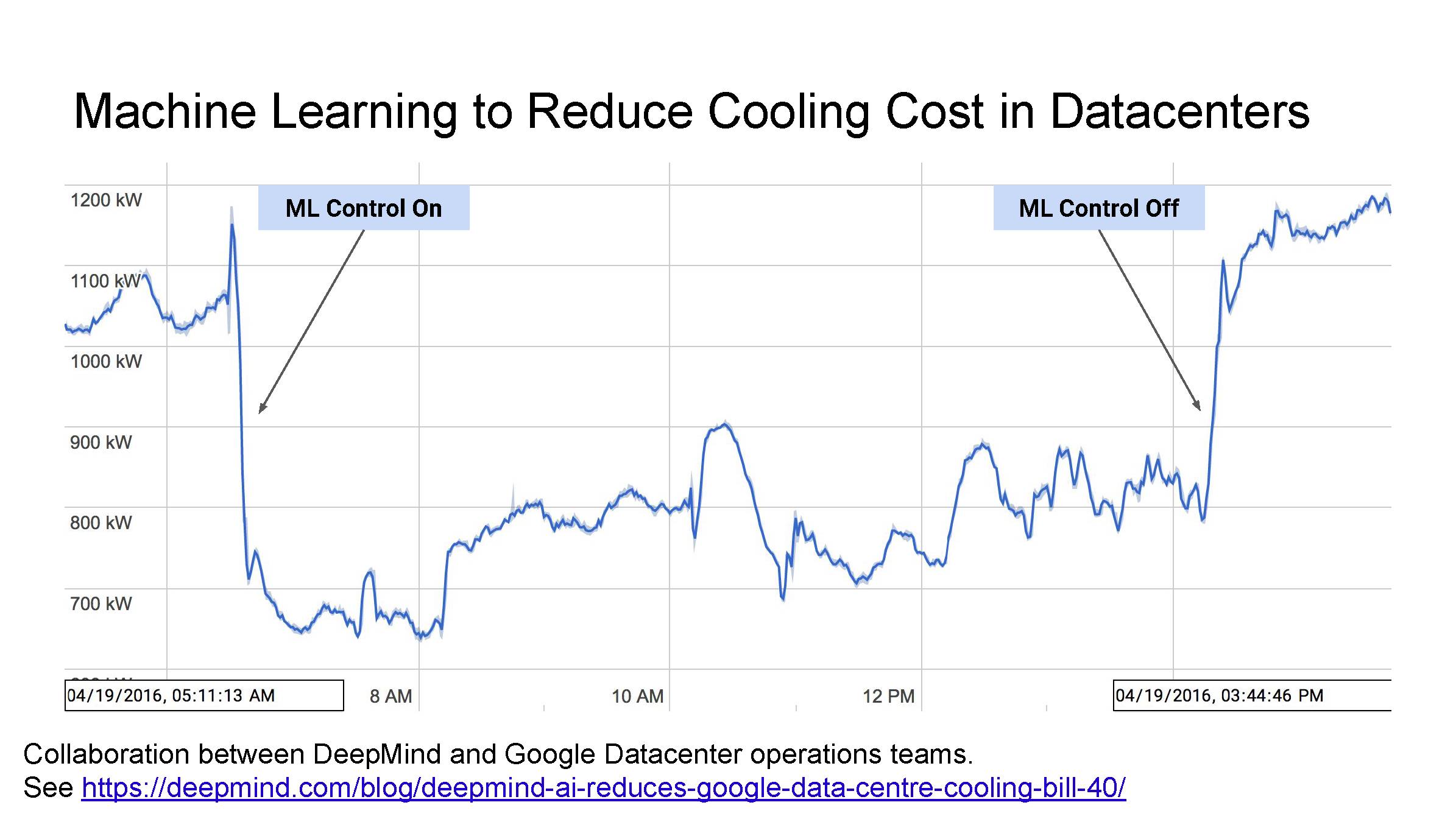

【导读】在今年的NIPS2017大会期间,Google大脑负责人Jeff Dean详细介绍了Google在AI芯片方面的最新研究进展。让我们来看一下Jeff Dean带来的讲座《Machine Learning for Systems and Systems for Machine Learning》。

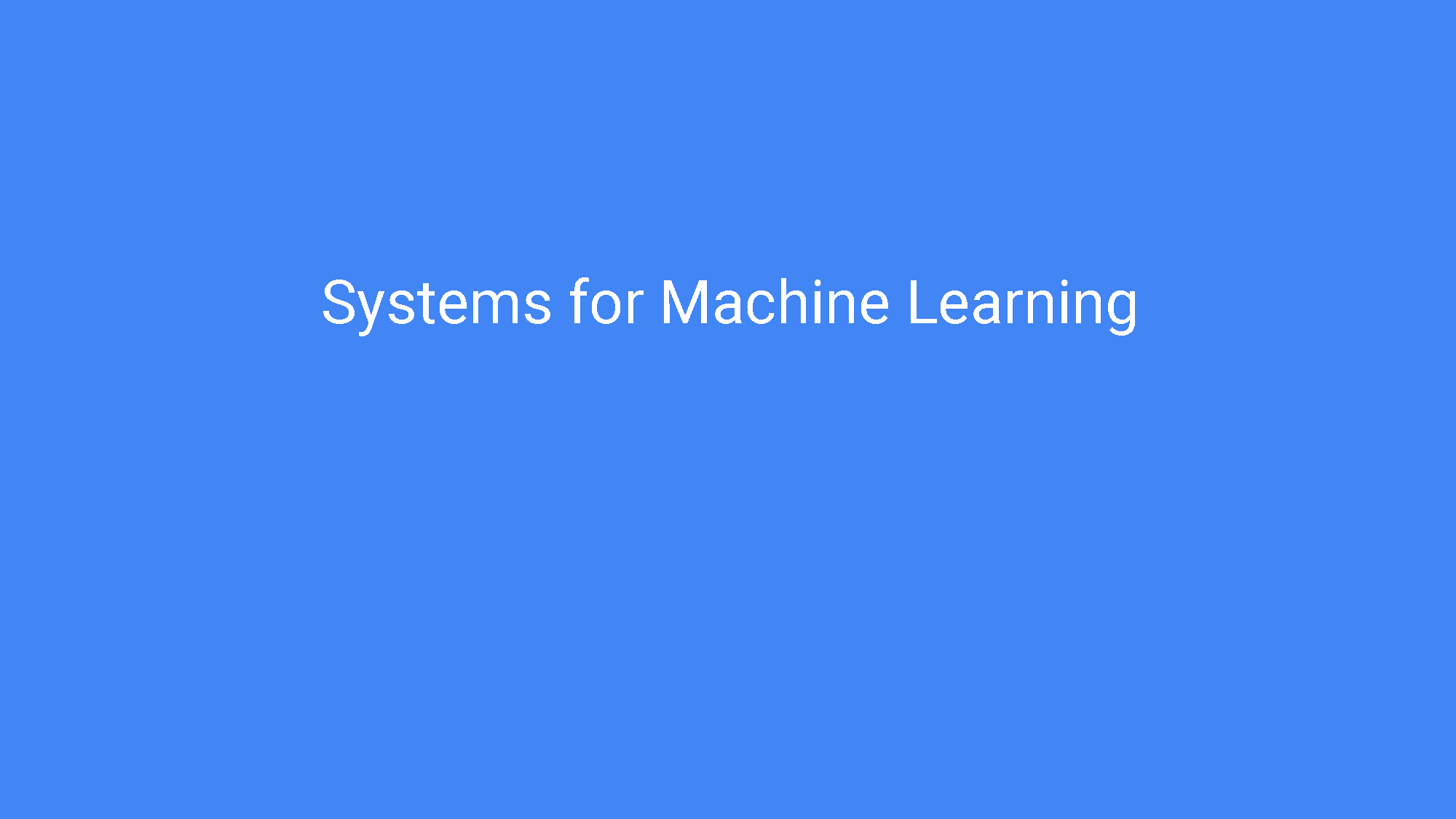

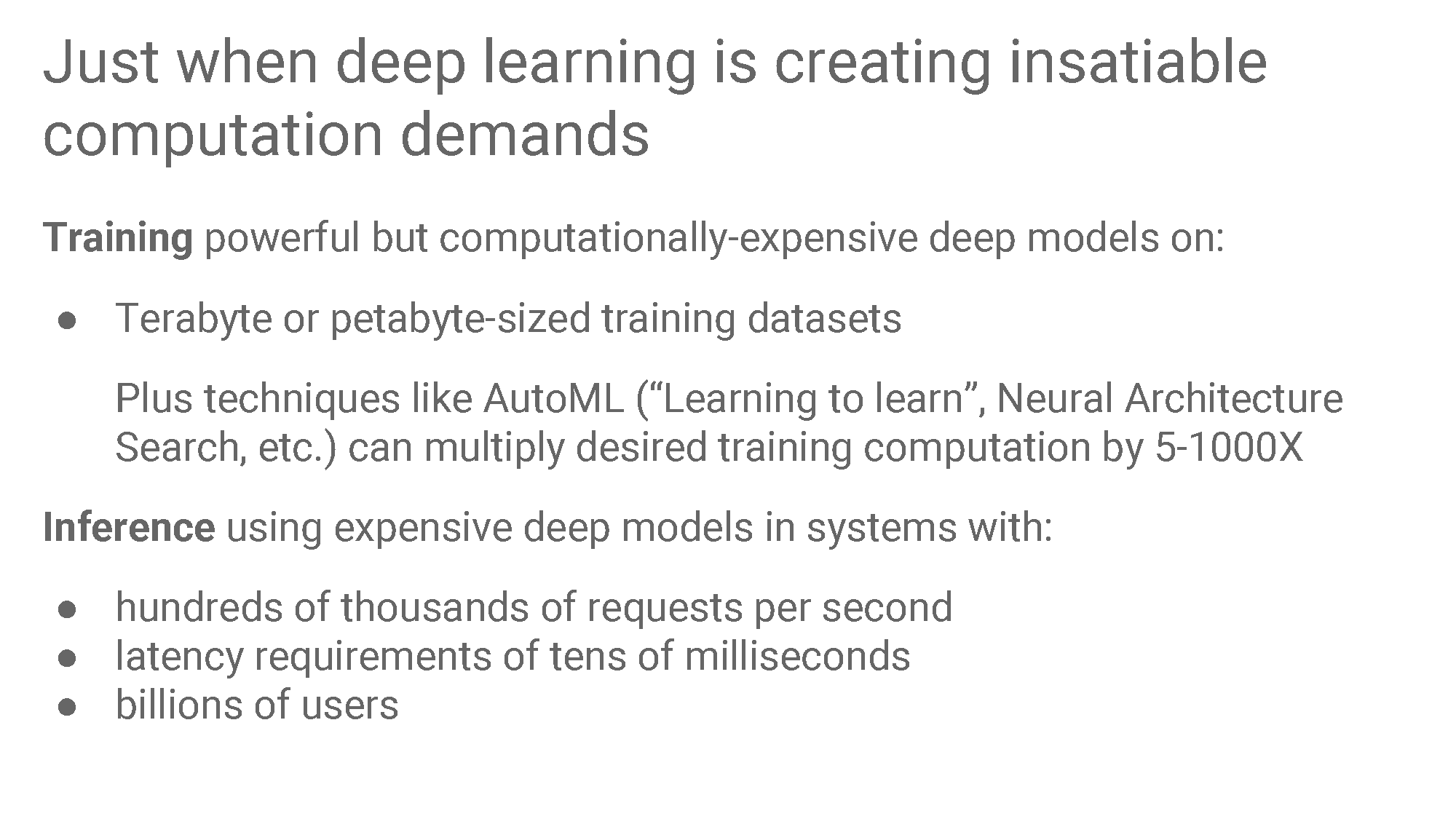

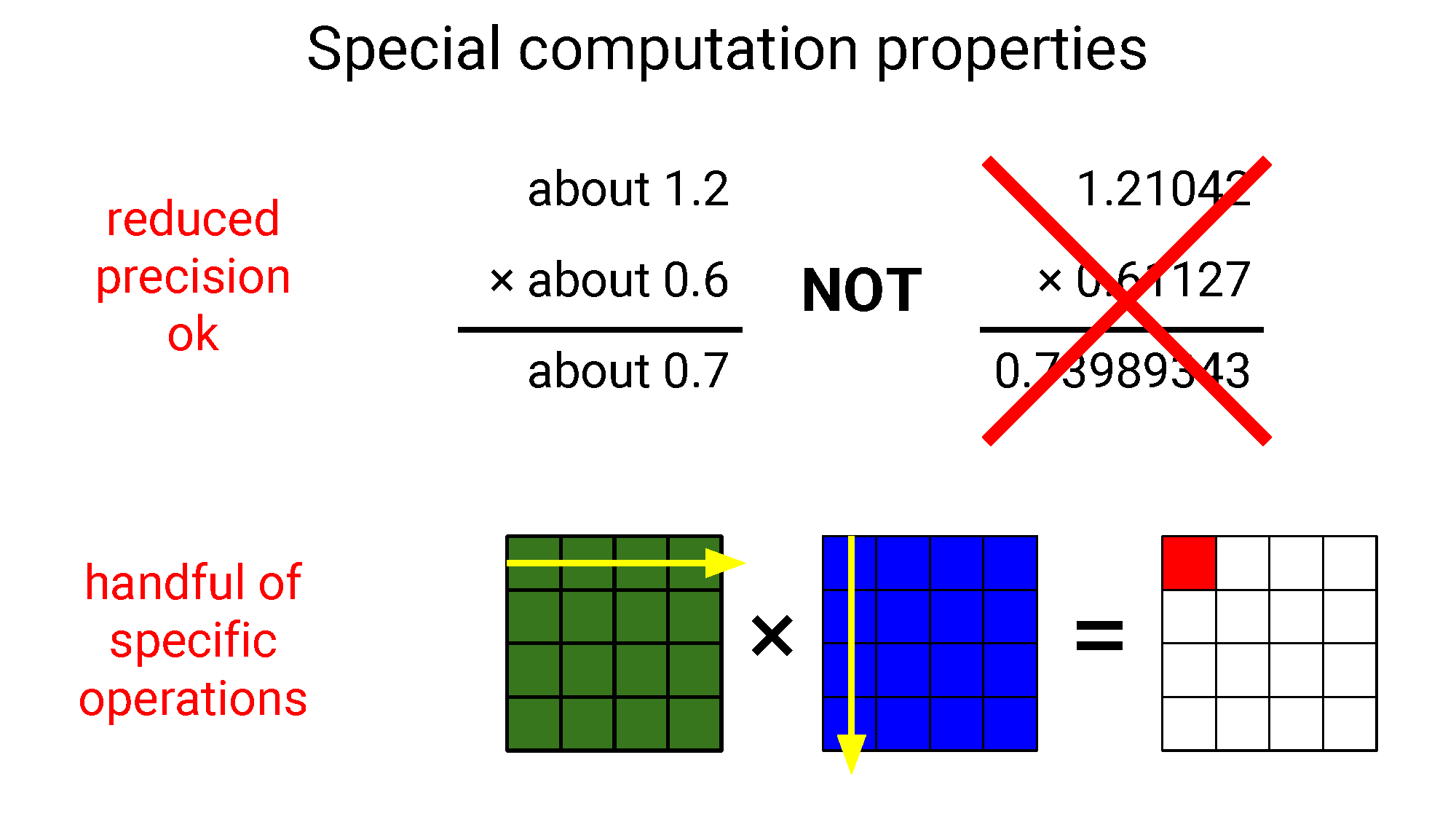

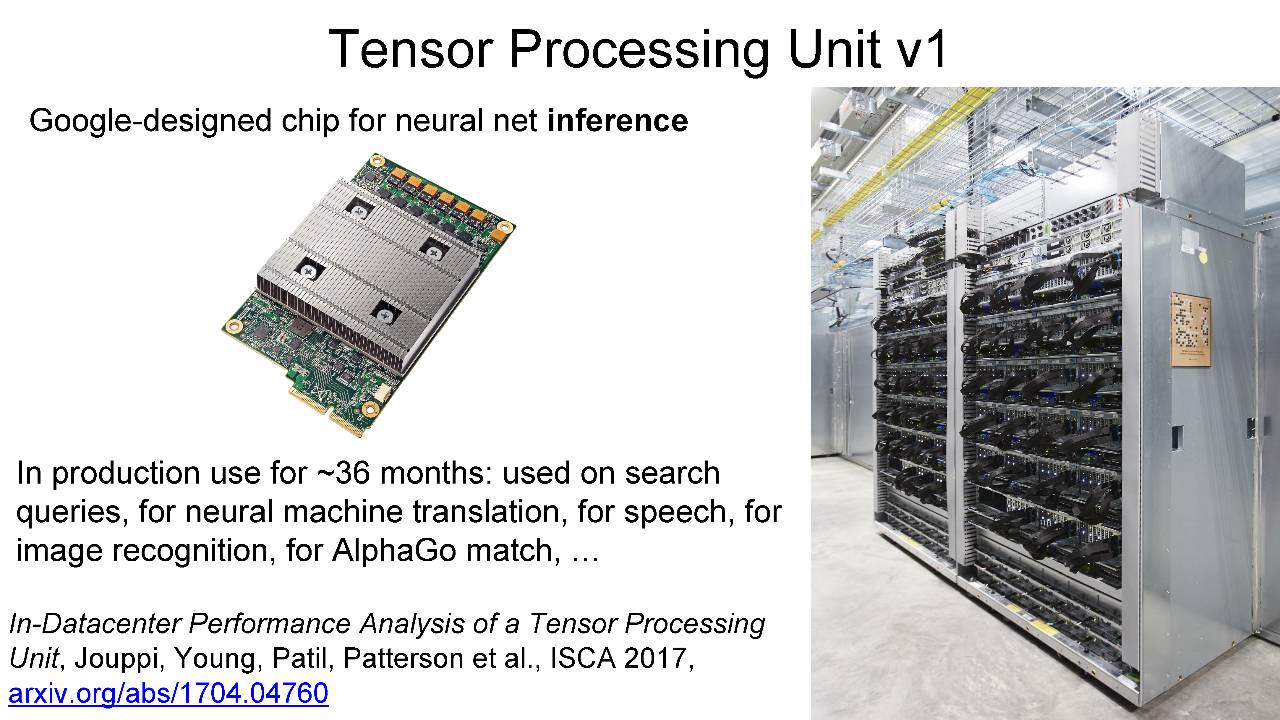

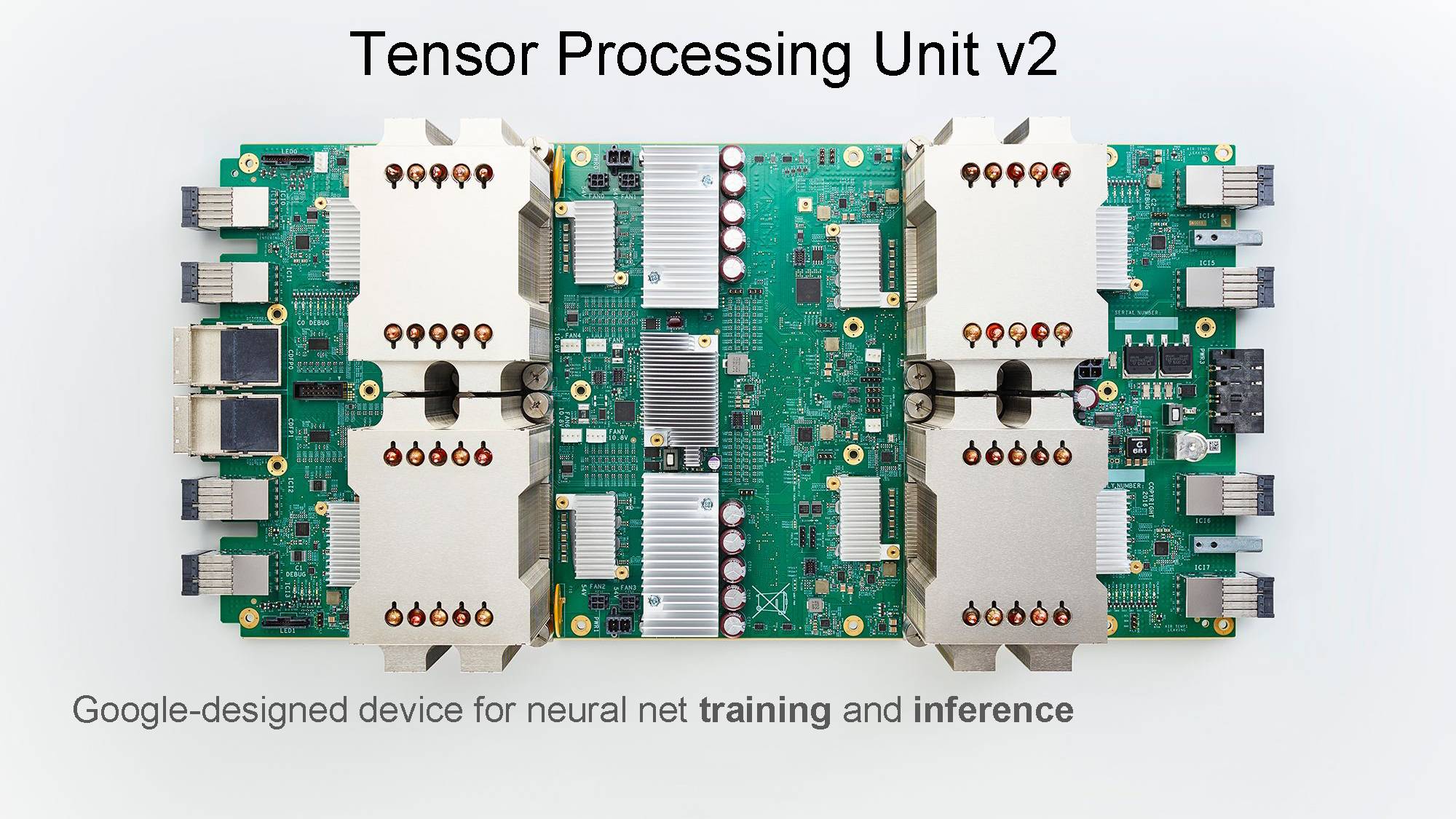

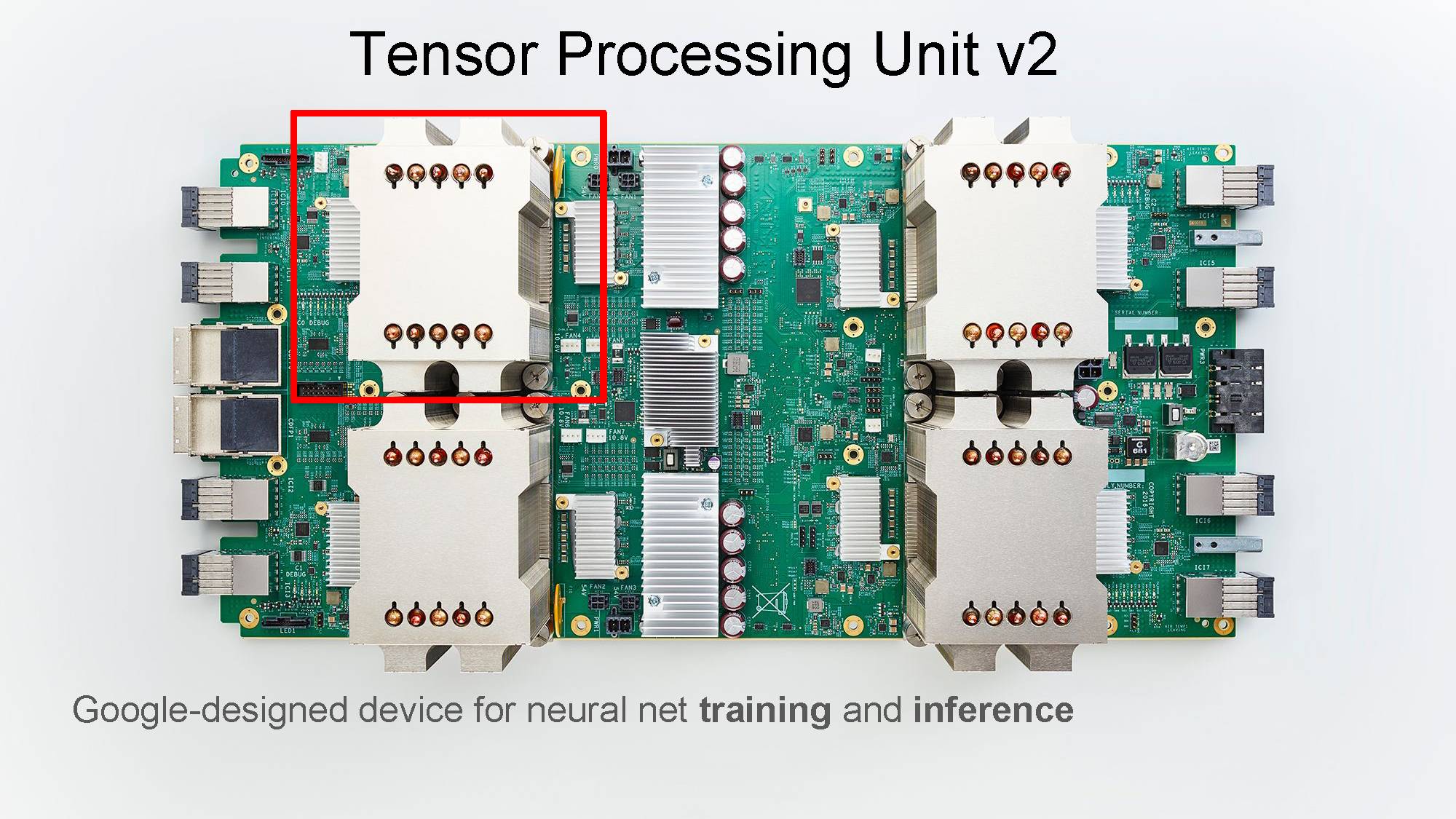

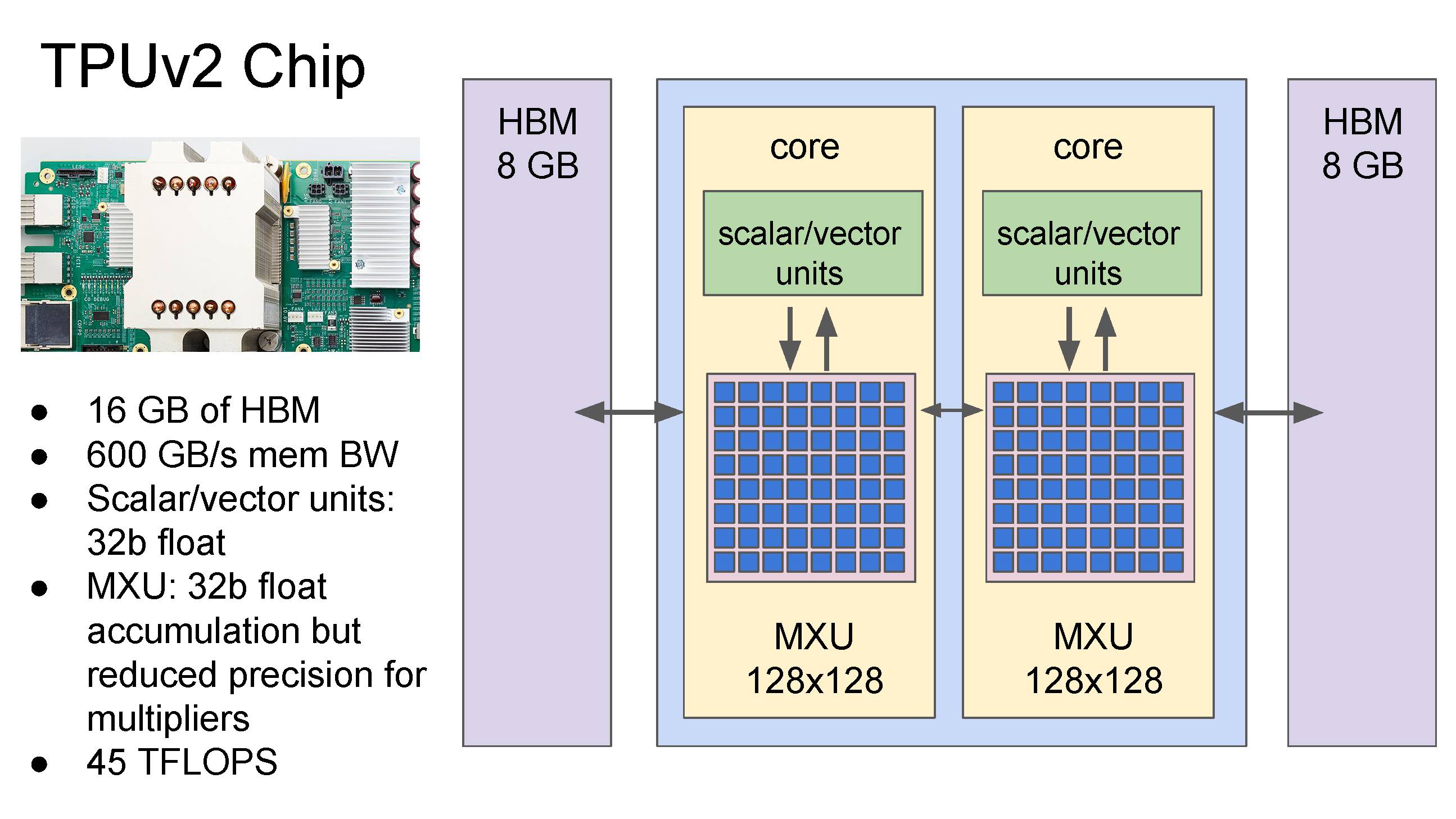

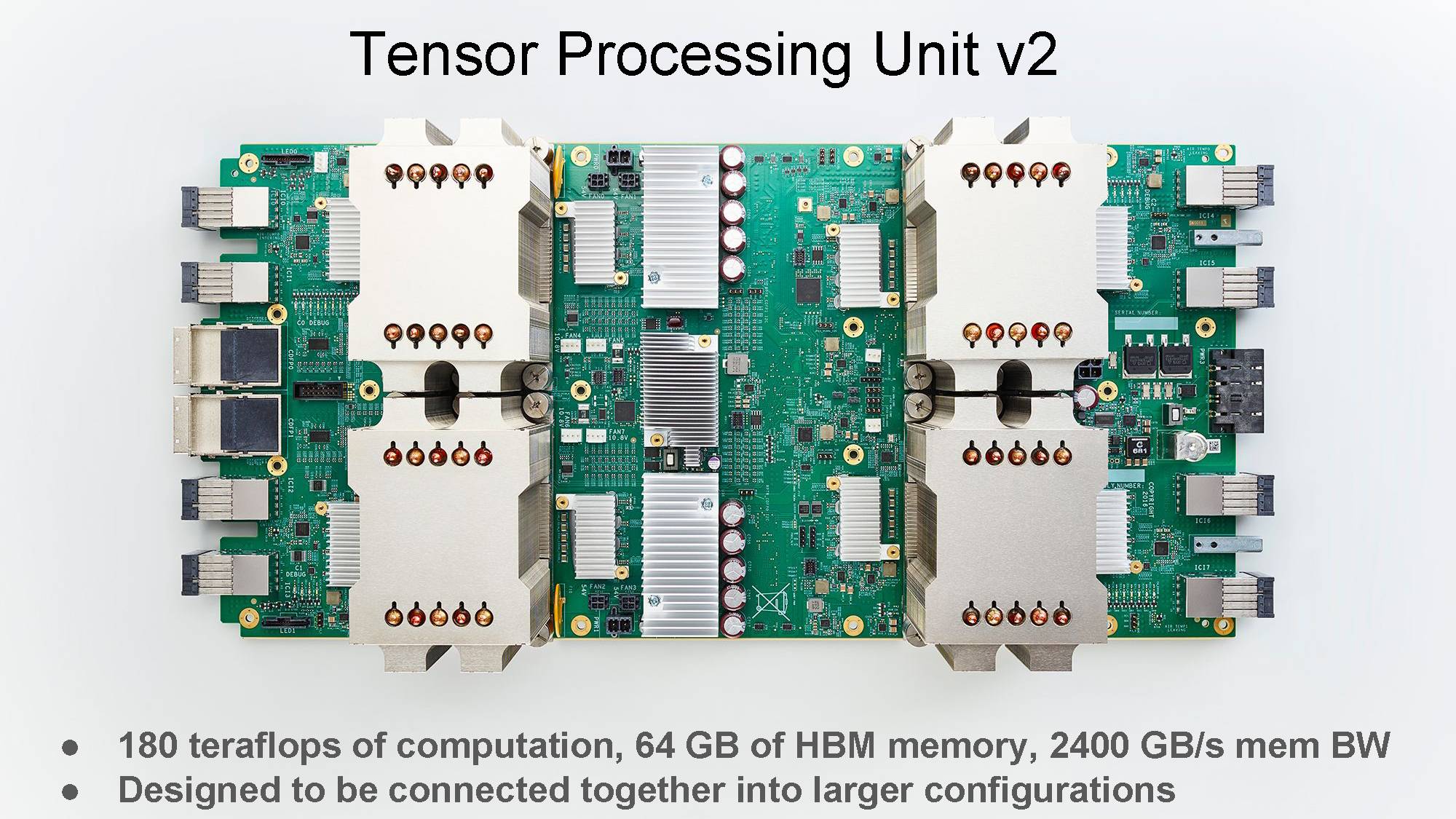

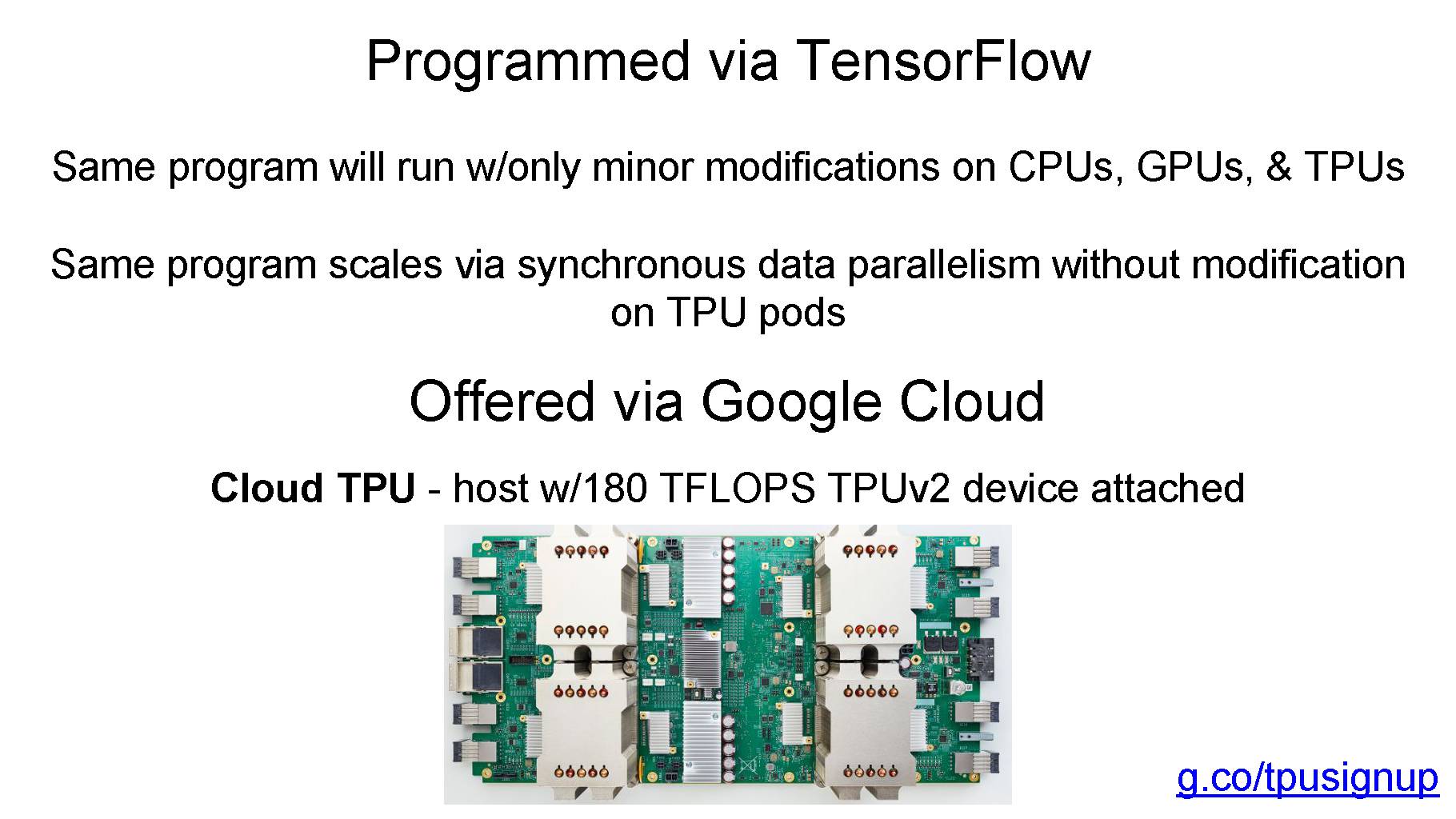

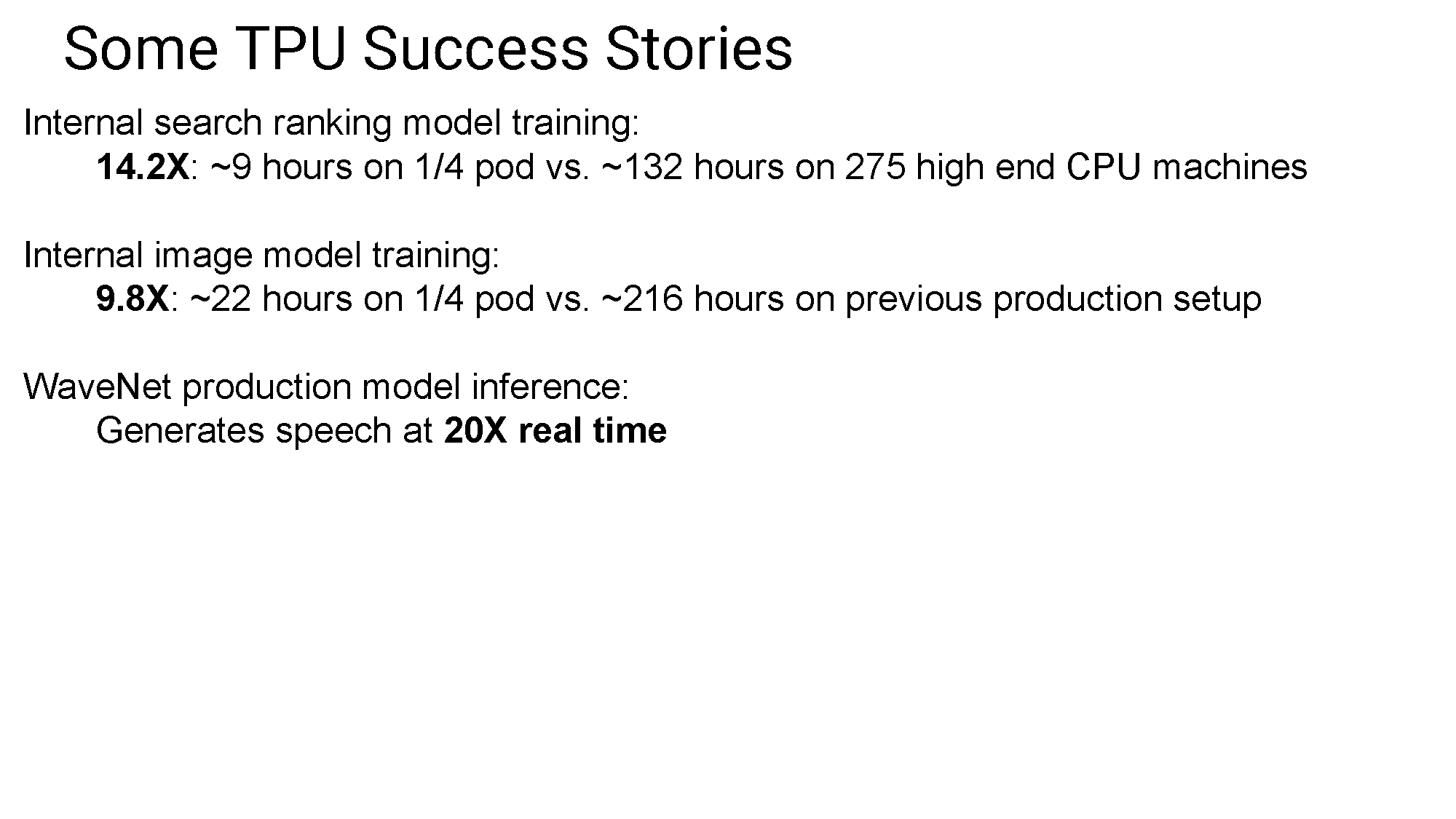

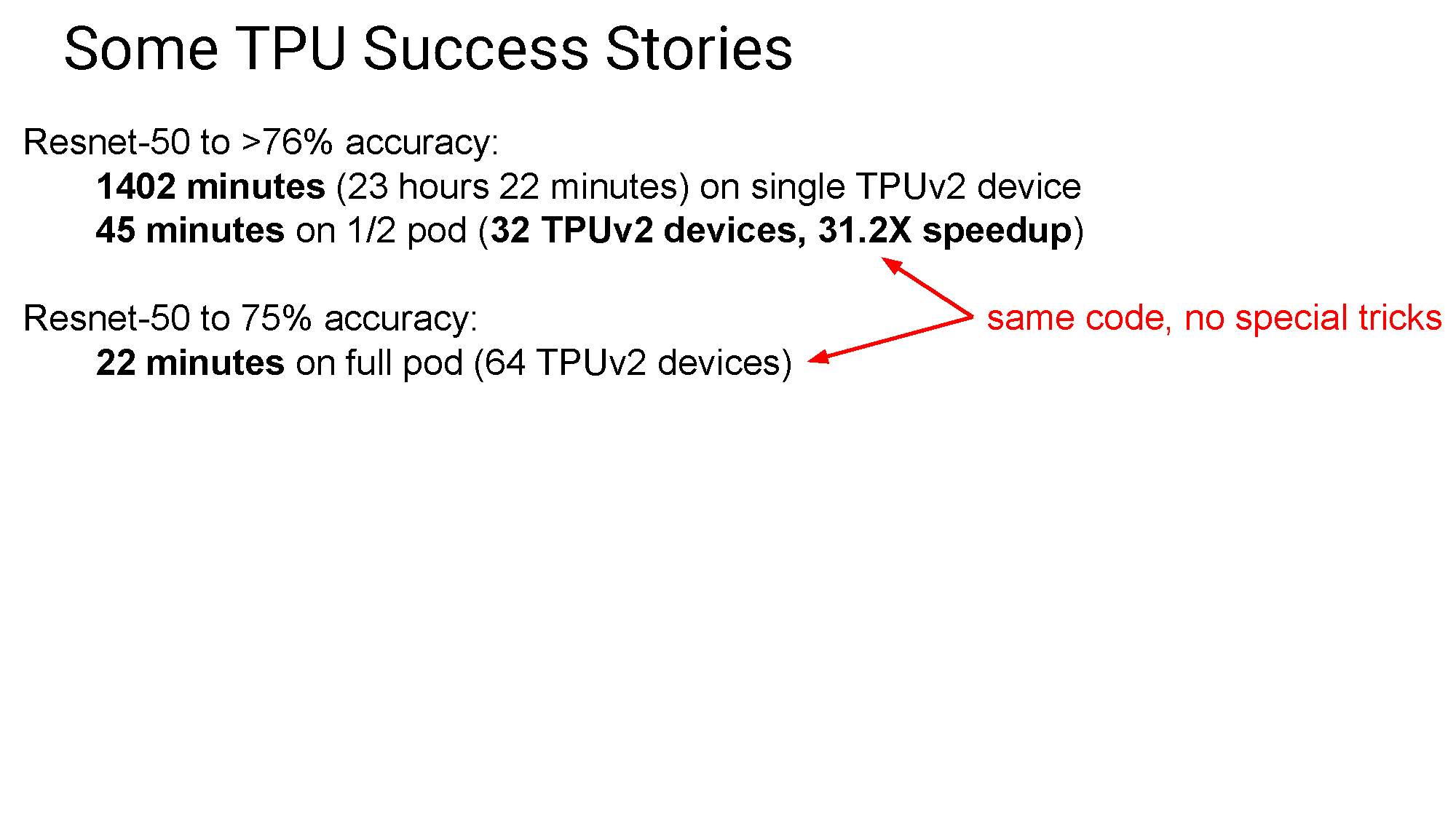

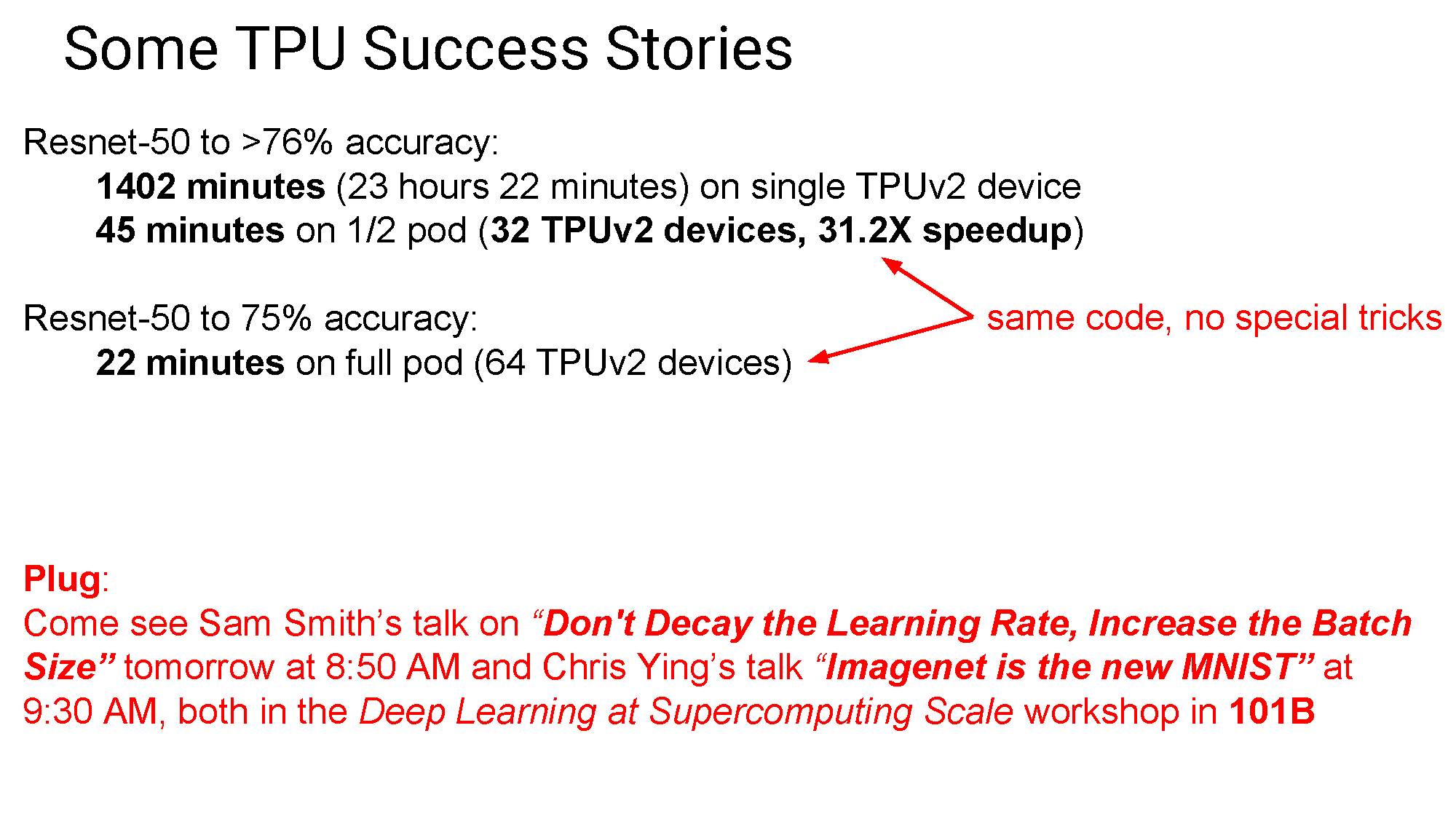

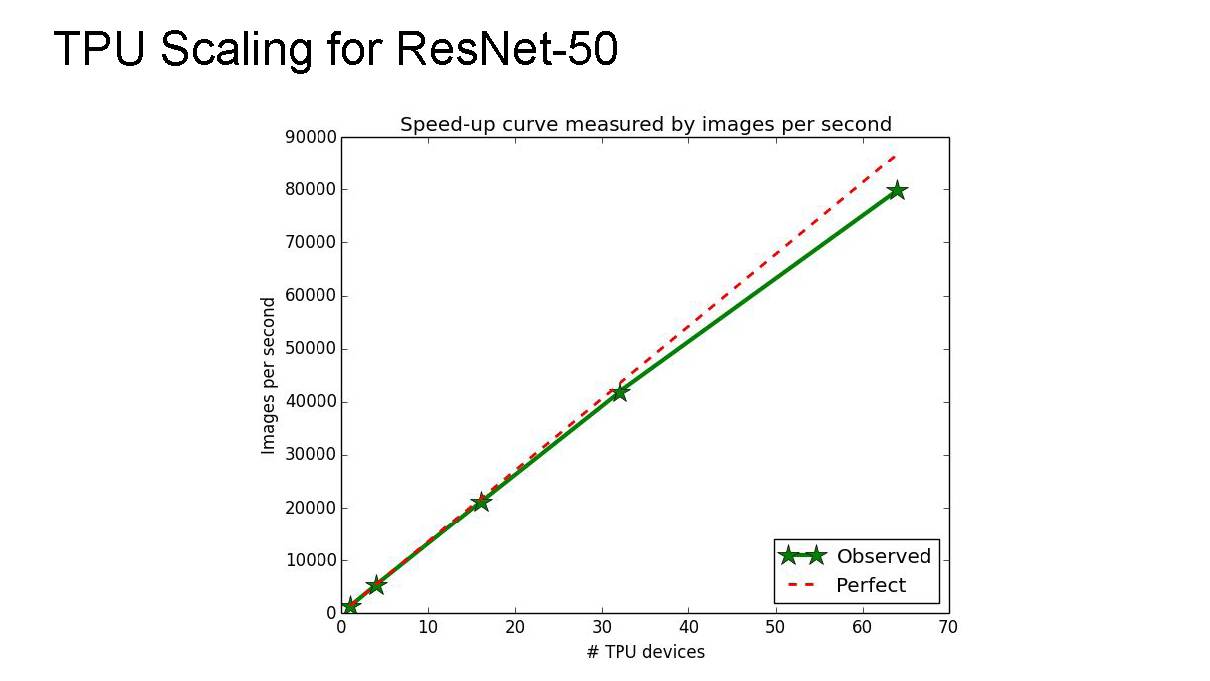

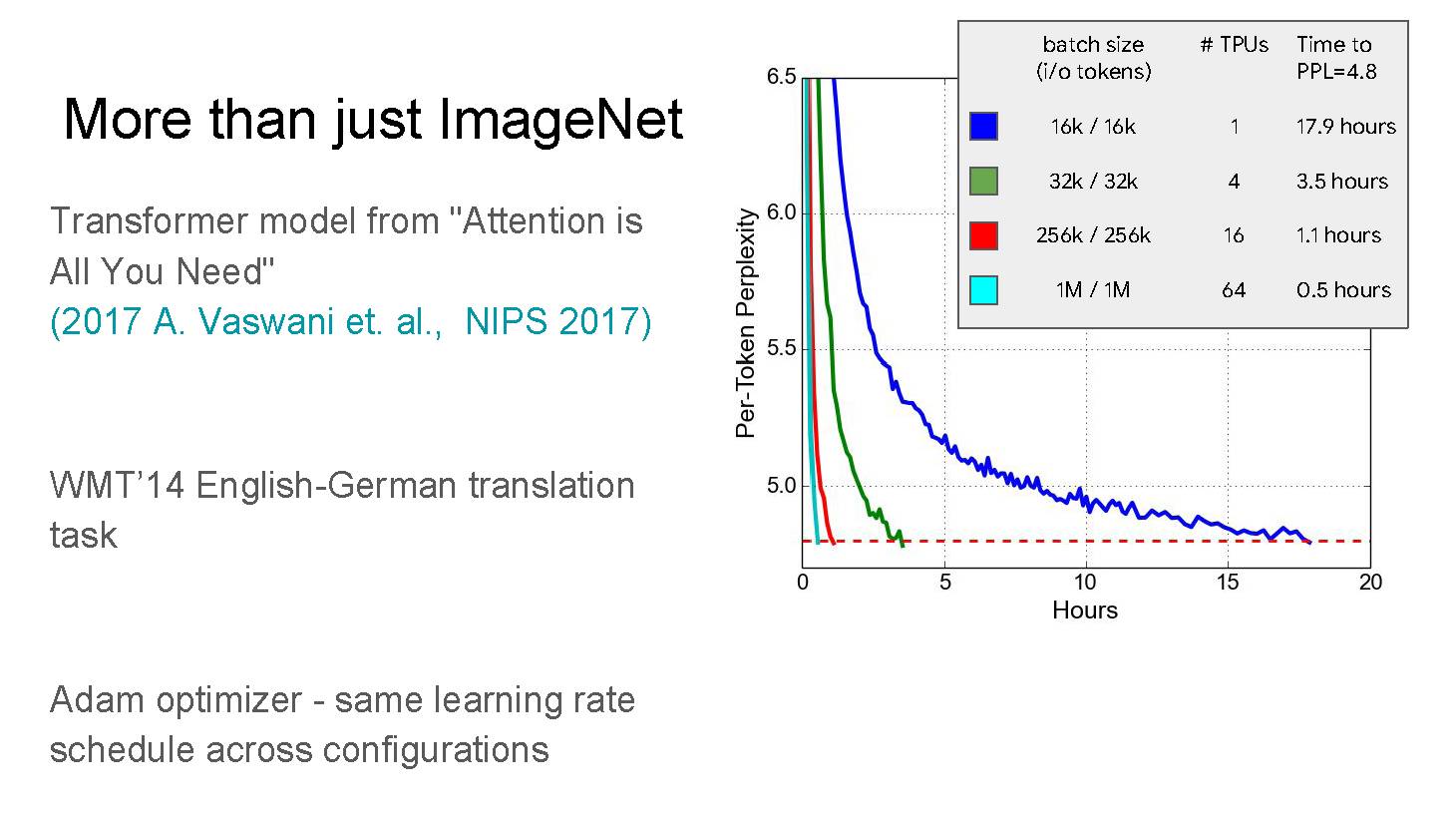

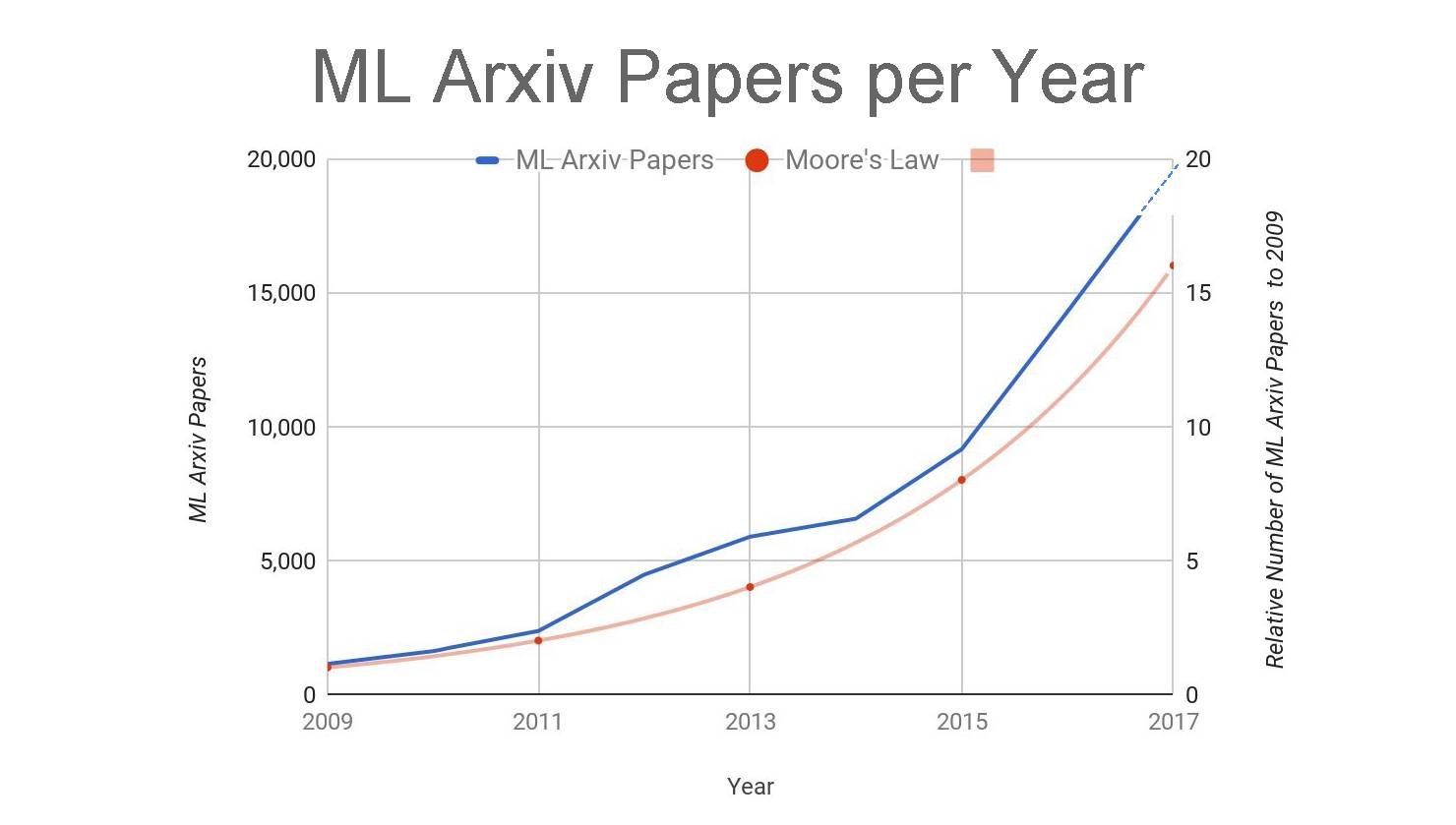

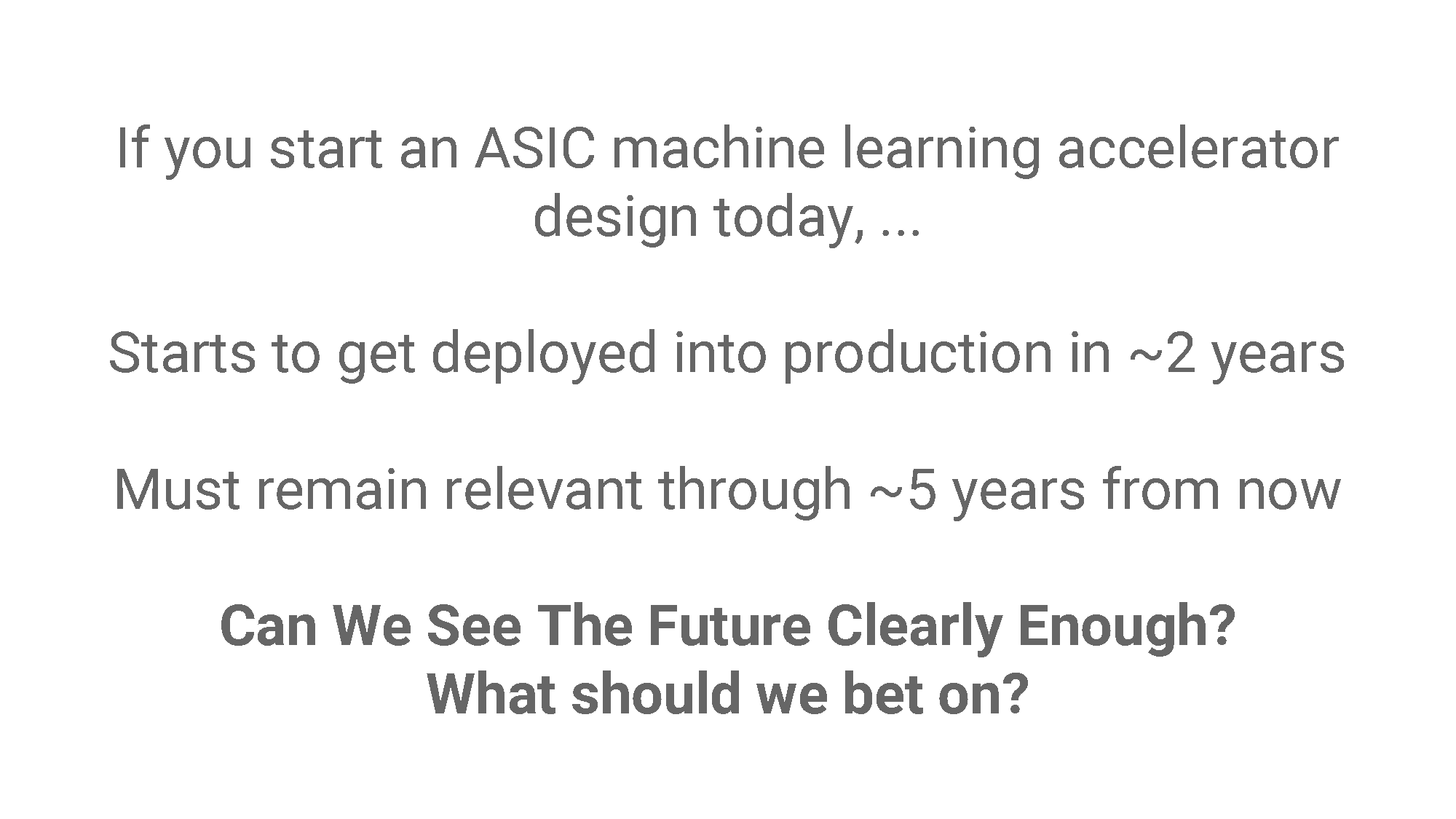

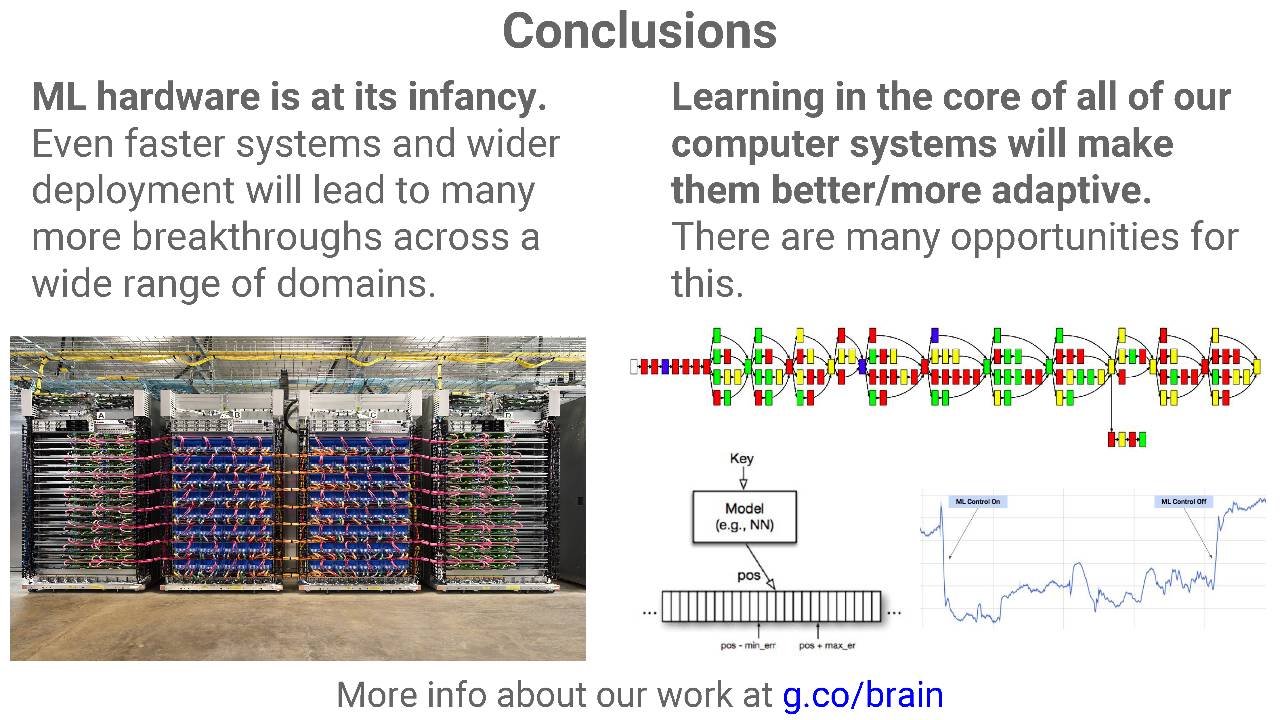

大约在四年前,谷歌开始注意到深度神经网络在各种服务中的真正潜力,由此产生的计算力需求——硬件需求,也就十分清晰。具体说,CPU 和 GPU 把模型训练好,谷歌需要另外的芯片加速推理(inference),经过这一步,神经网络才能用于产品和服务。此后就有了谷歌TPU的出现,这款芯片在去年谷歌 I/O 大会上首次公开亮相,在这今年召开的体系结构顶会ISCA 2017 上面,描述 TPU 的论文被评为最佳论文。

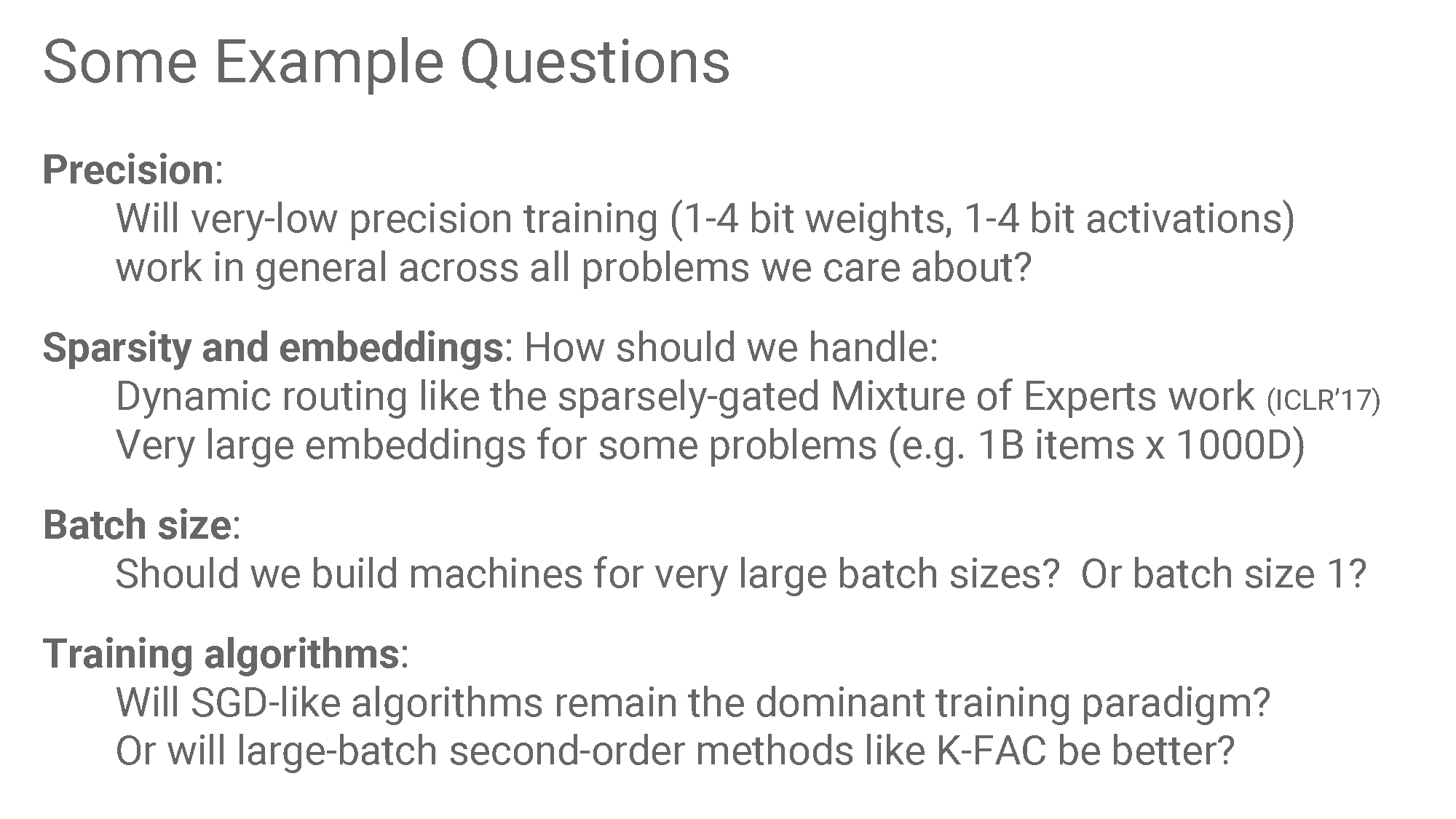

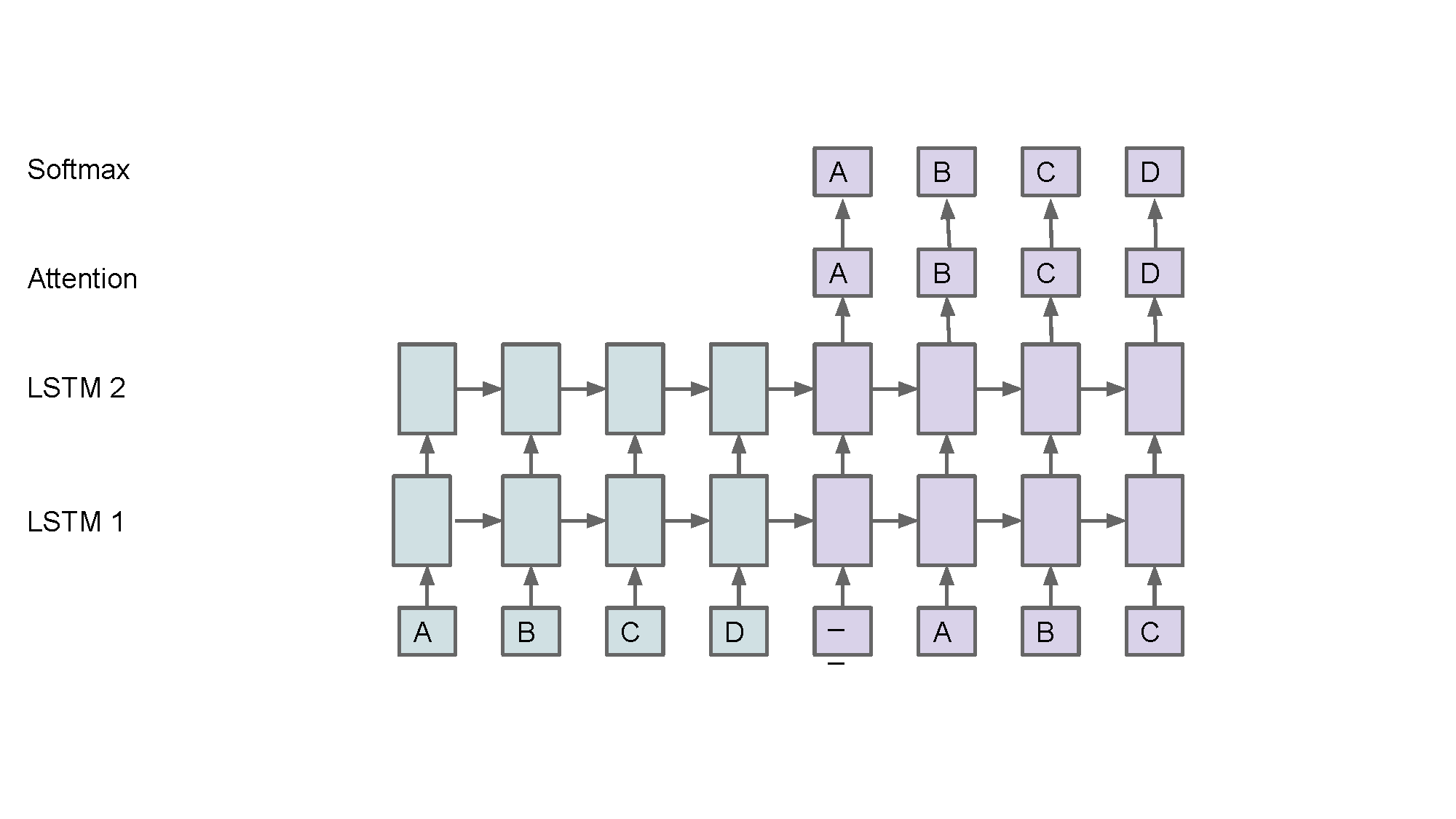

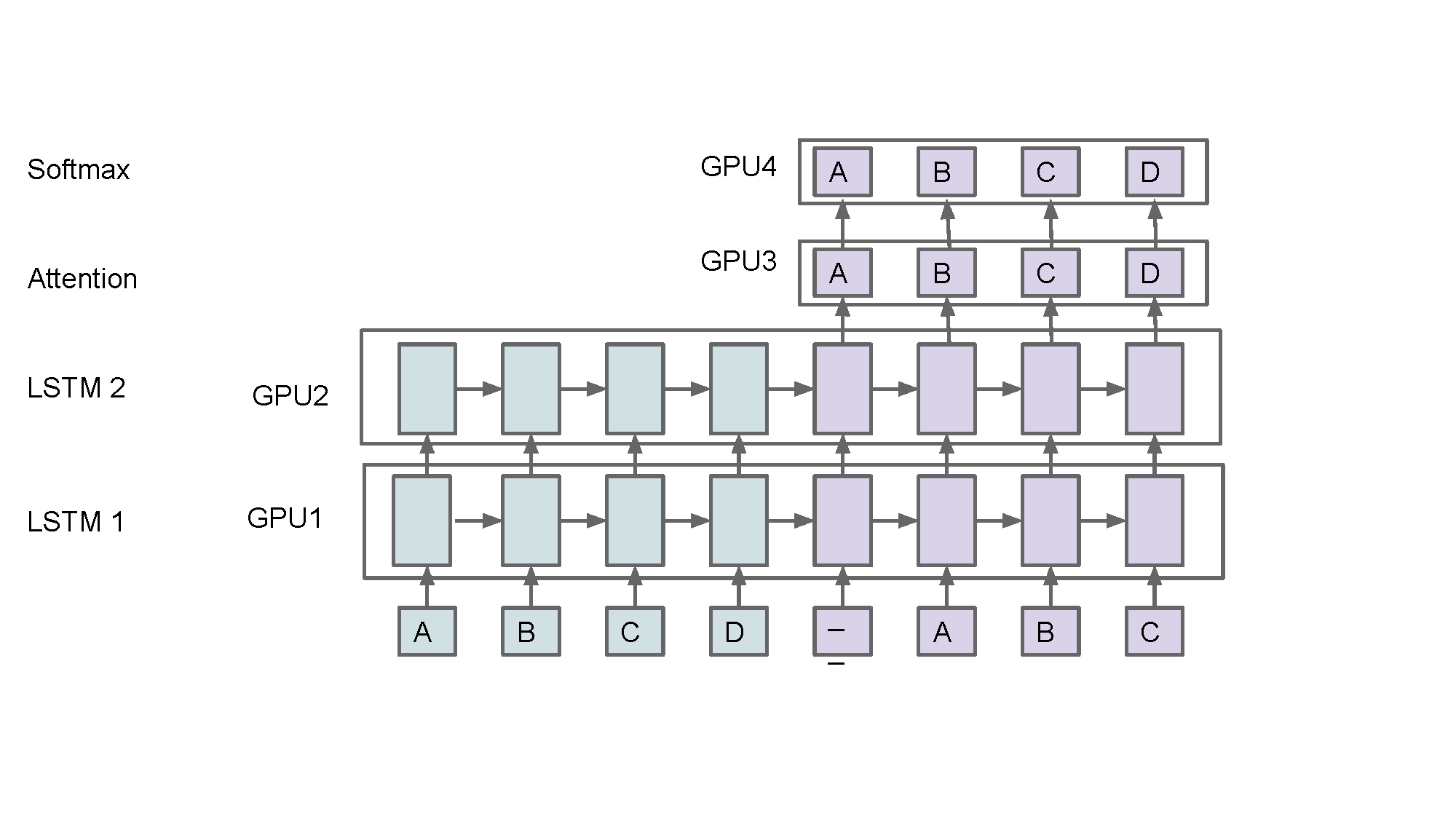

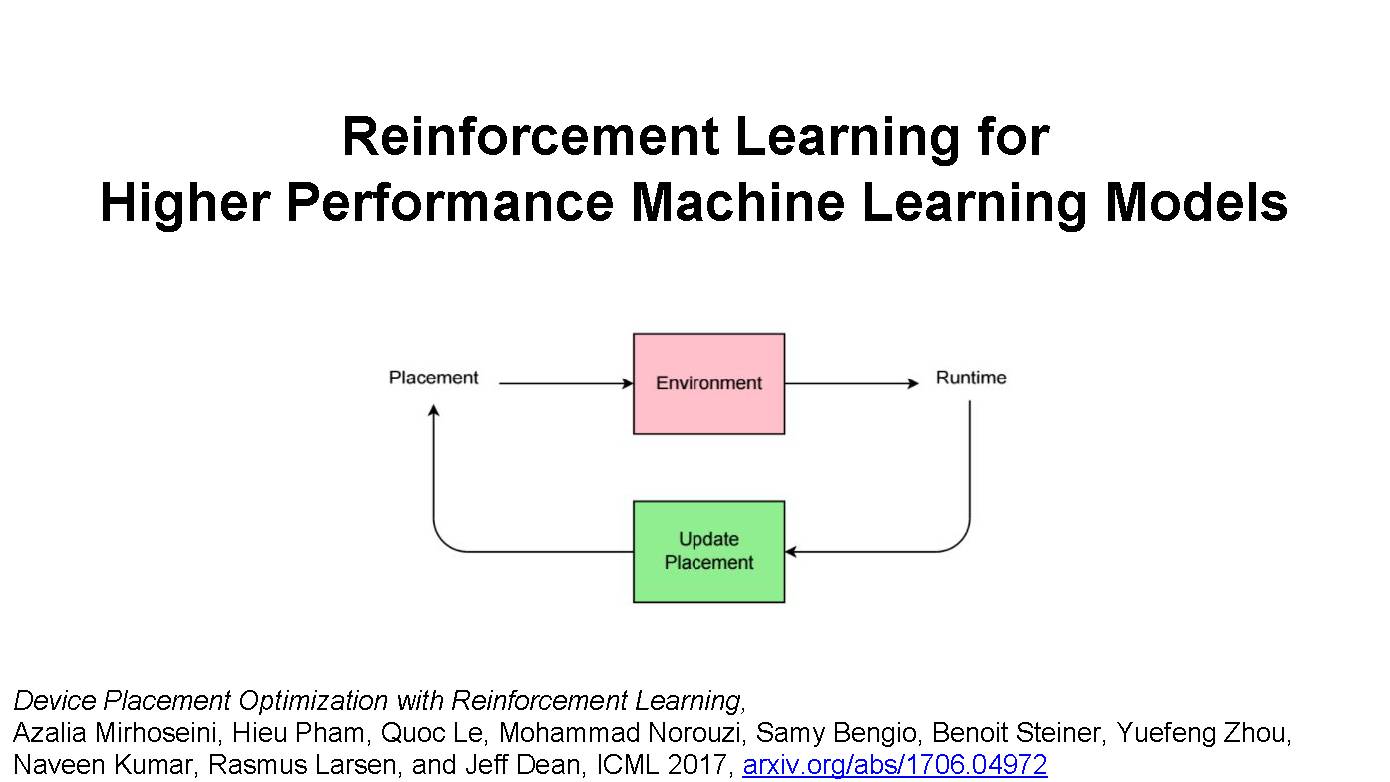

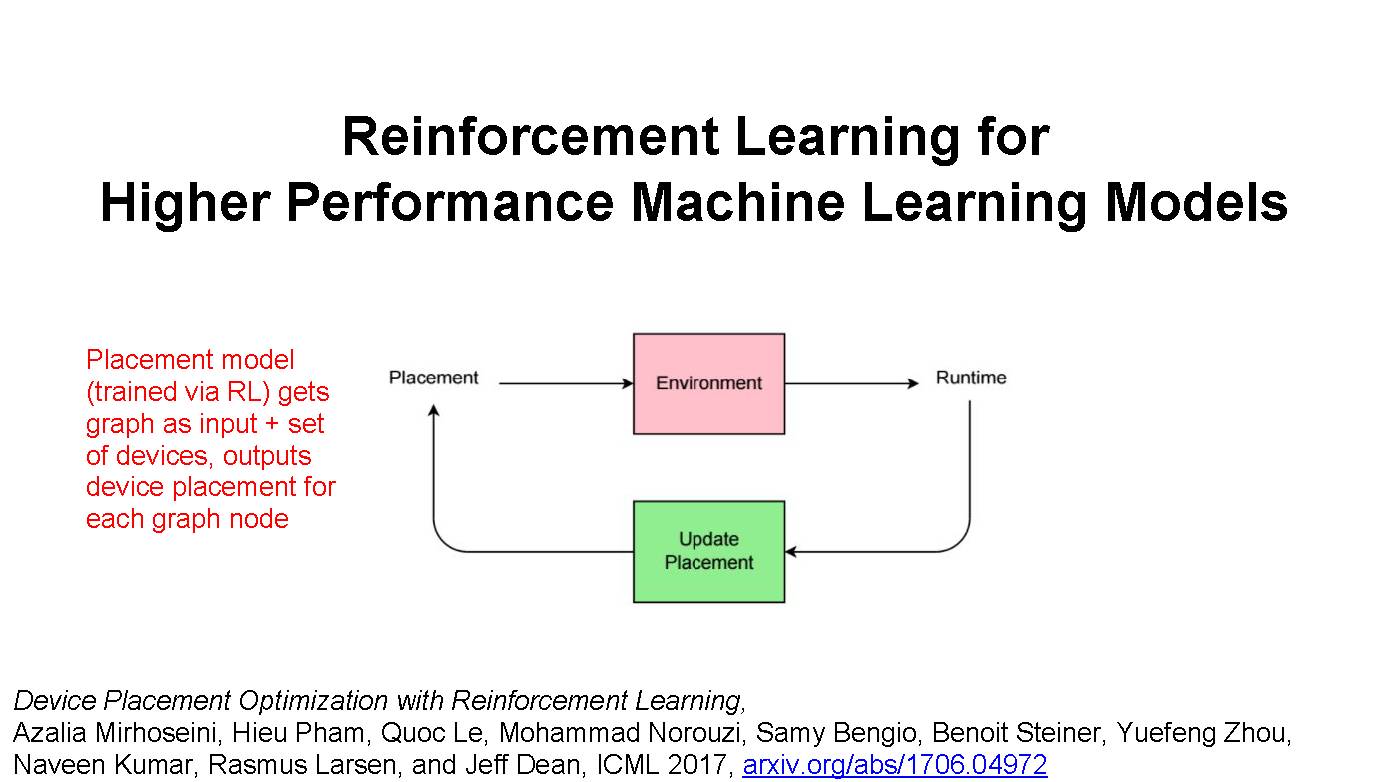

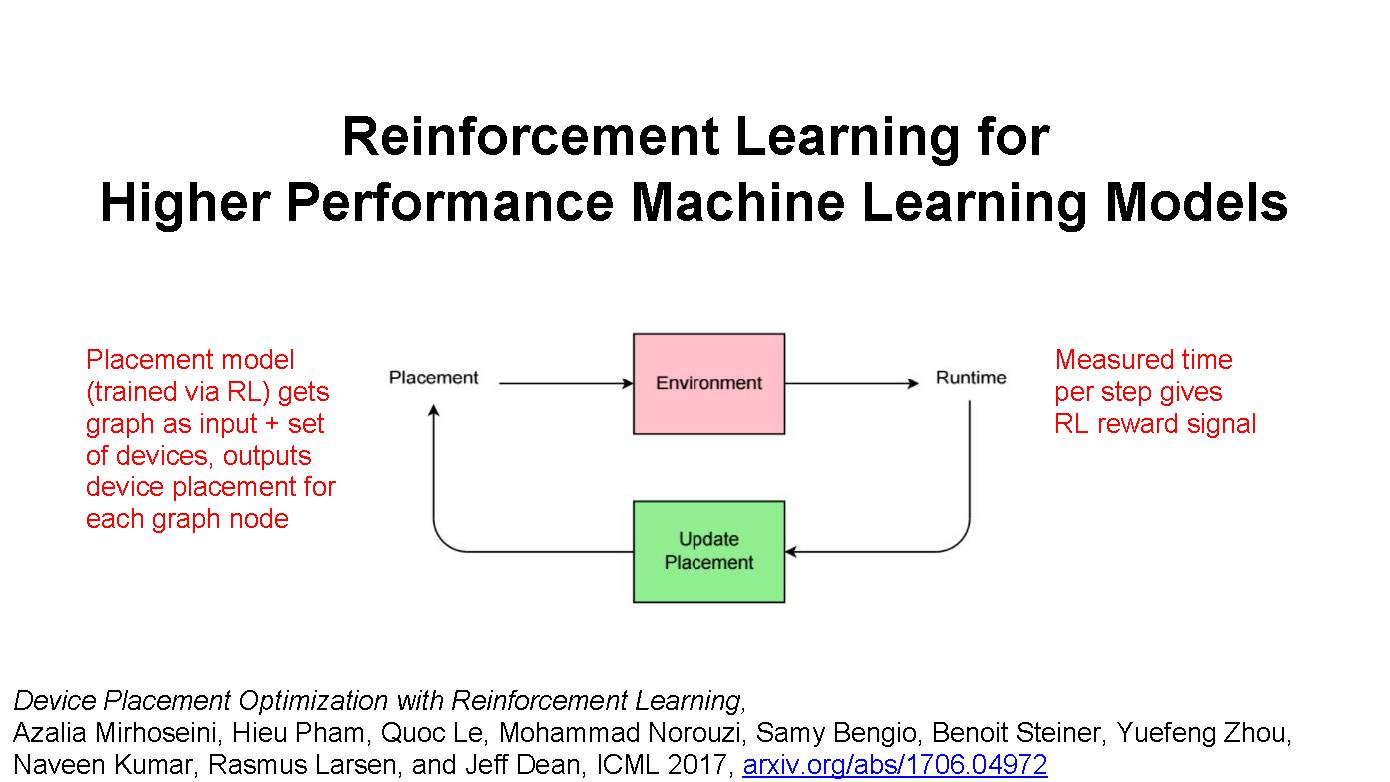

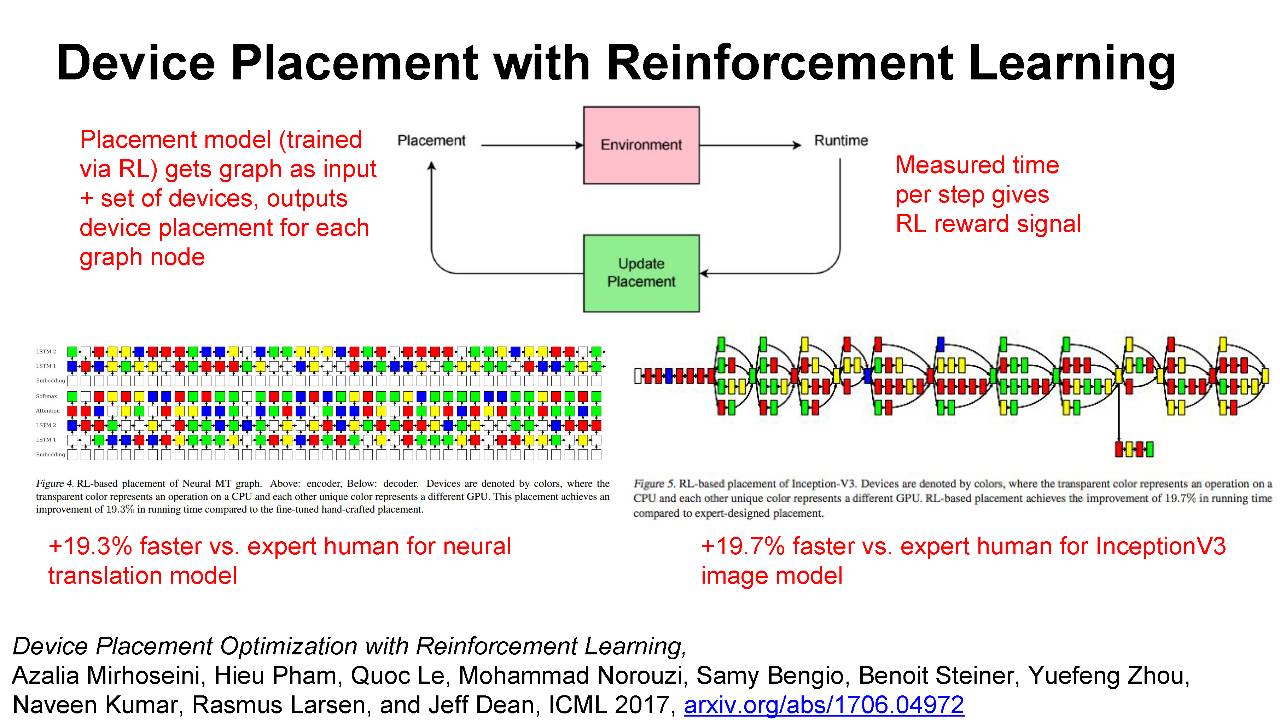

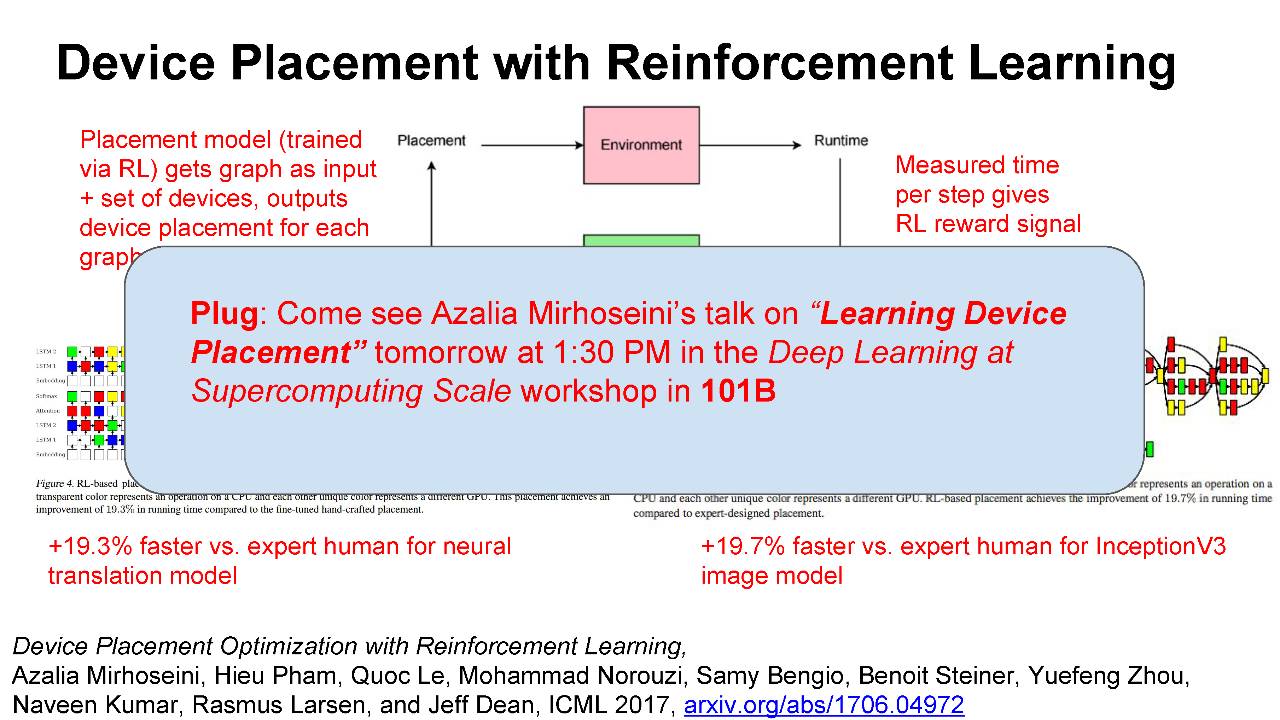

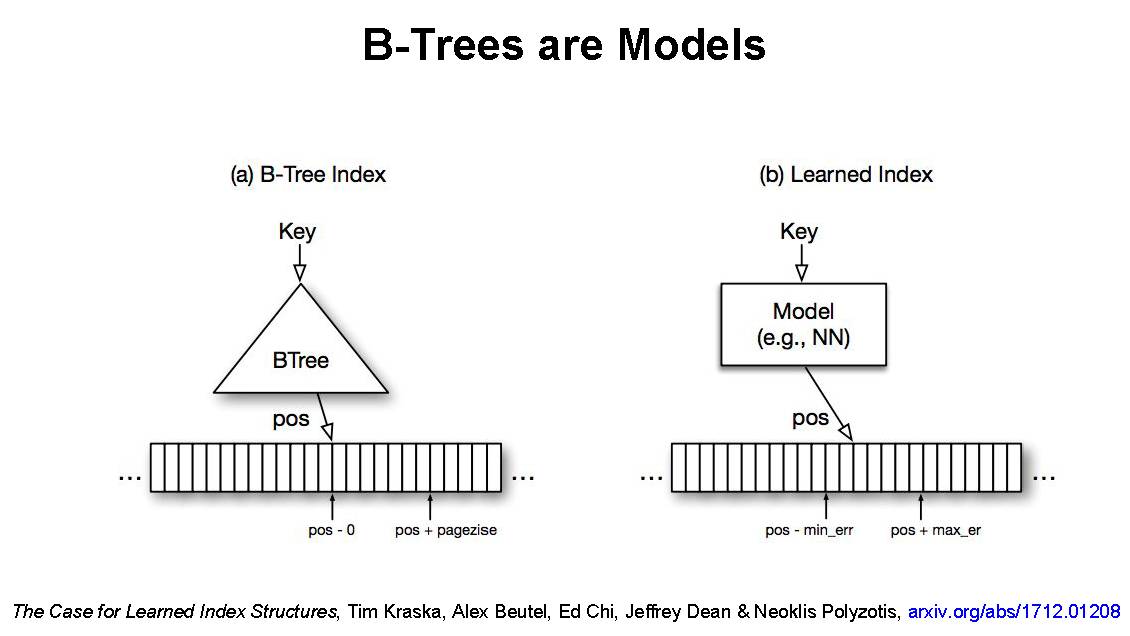

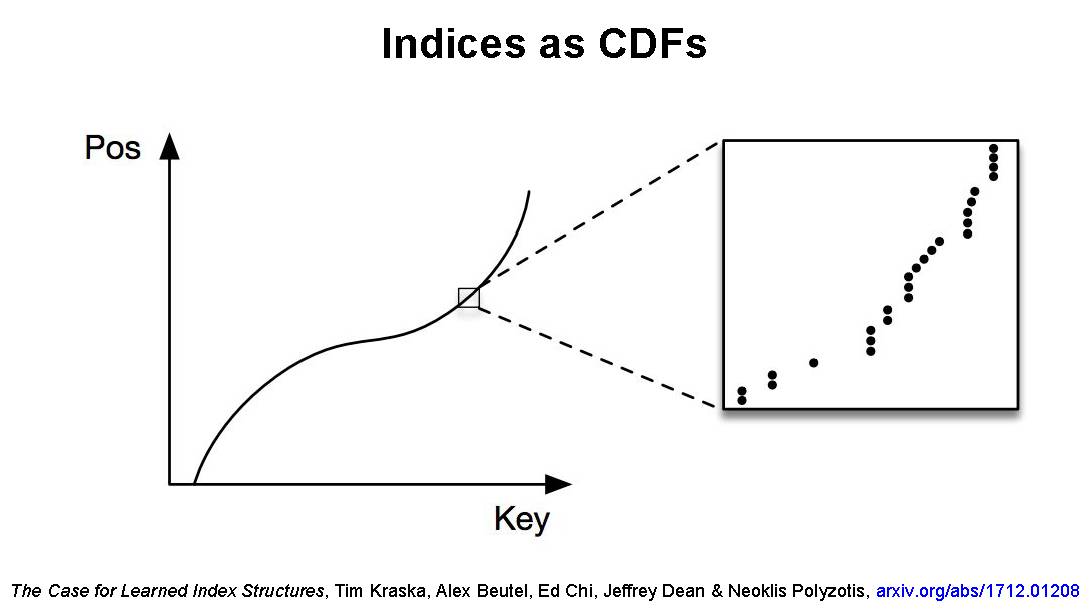

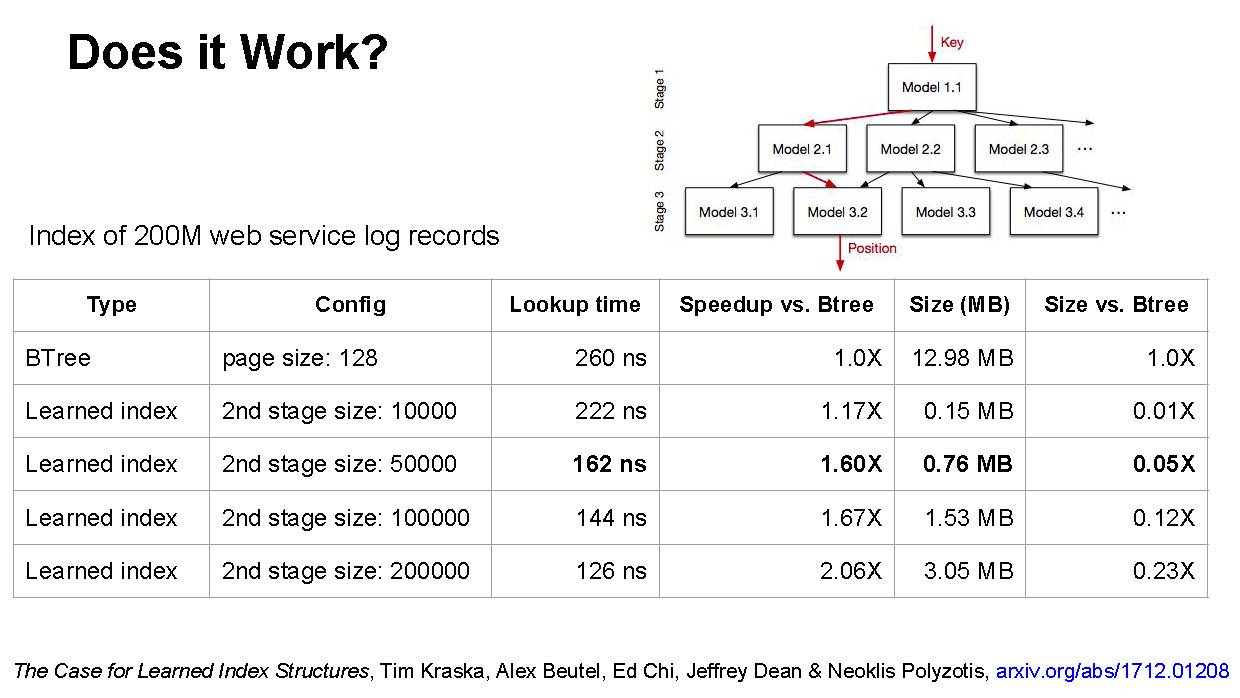

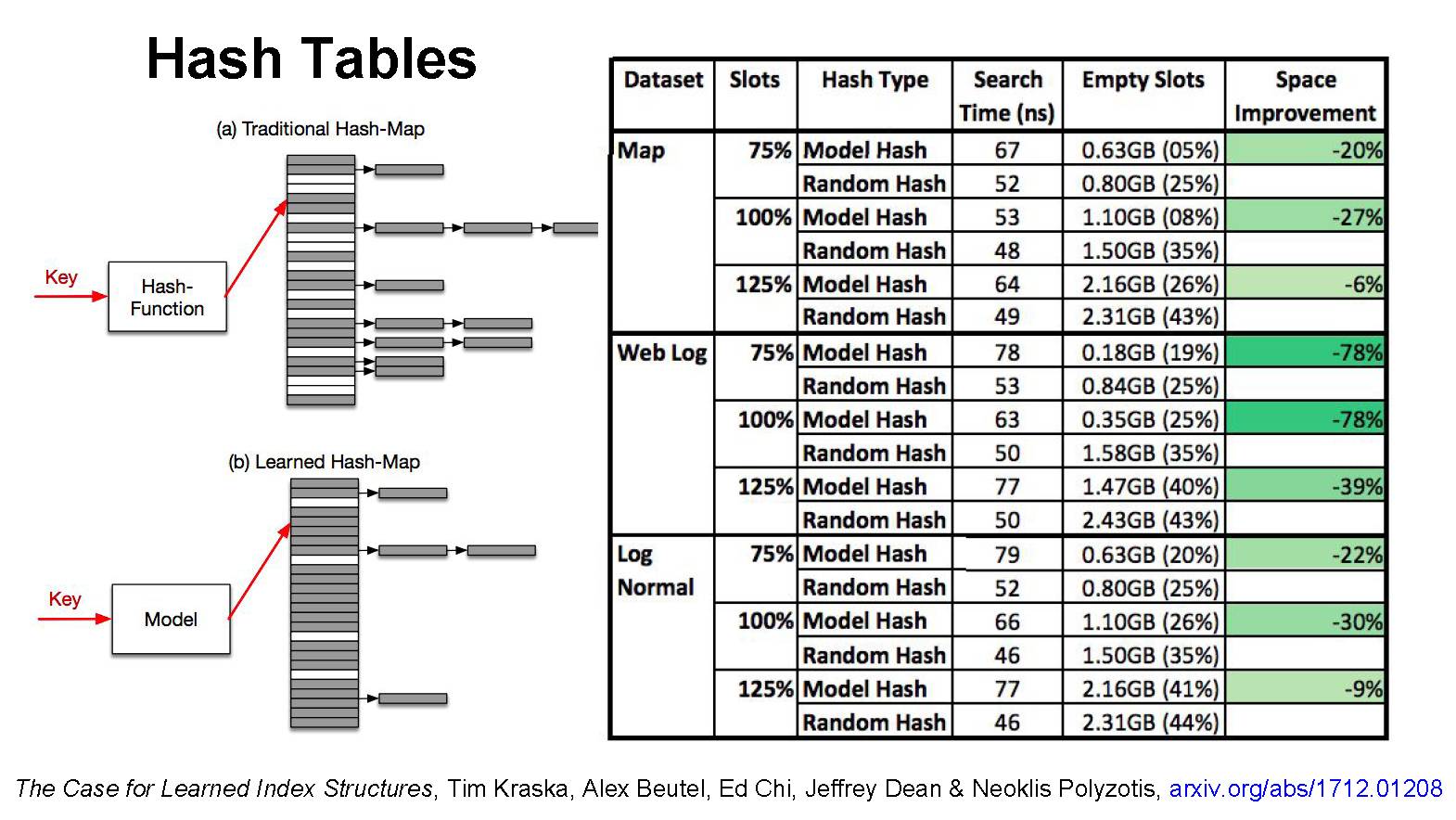

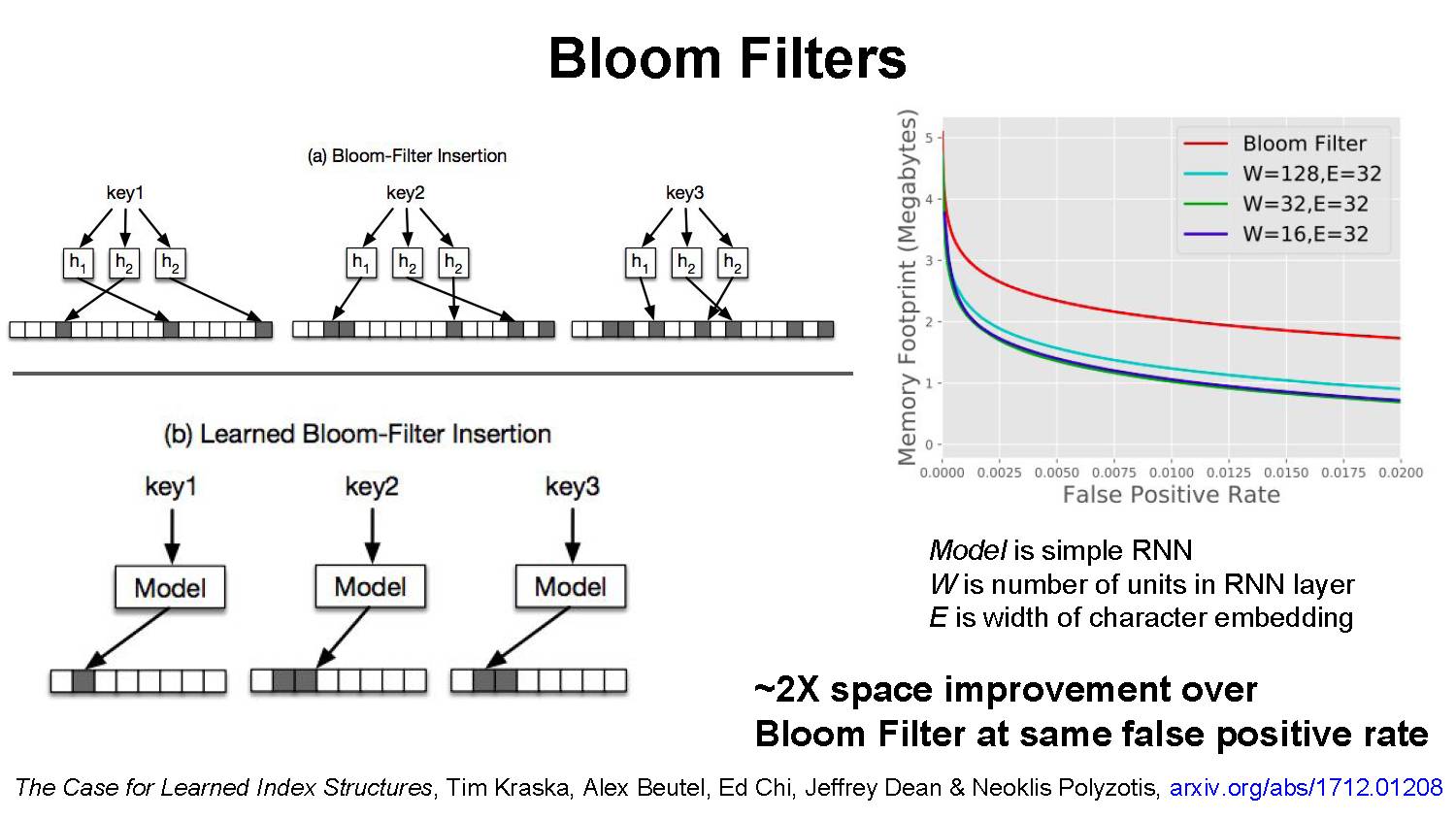

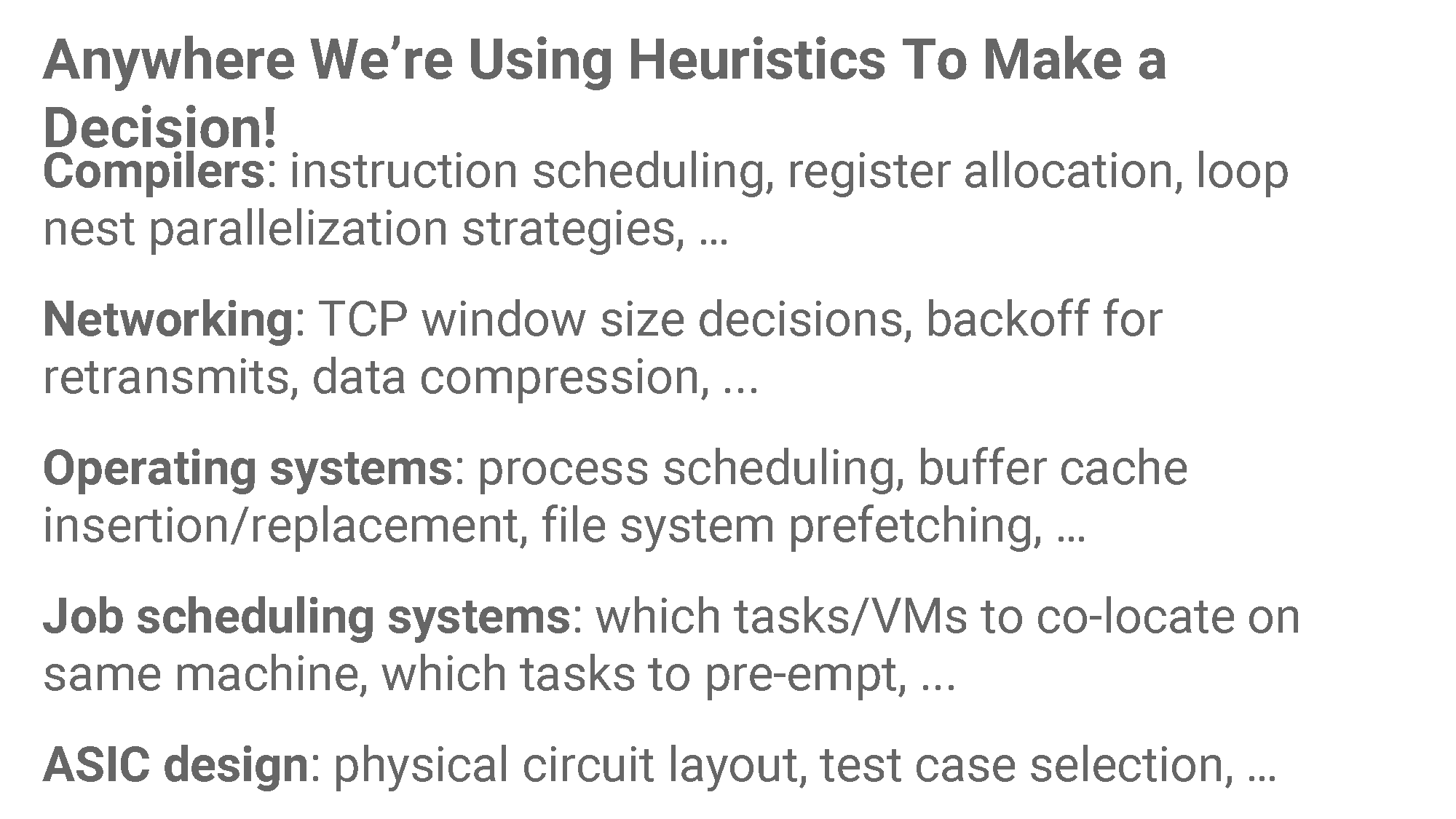

与此同时随着硬件系统性能的提升,机器学习方法如何更好的利用这些硬件资源也成了一个很重要的问题。比如在针对一个大型模型,如何基于多计算设备来实现并行化。还有如何利用机器学习来提升数据库系统的使用效率。

▌PPT详细内容

这是Jeff Dean报告的详细内容

参考链接:

http://learningsys.org/nips17/assets/slides/dean-nips17.pdf

▌特别提示-

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“MLS” 就可以获取PPT下载~

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域25个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

同时欢迎各位用户进行专知投稿,详情请点击:

【诚邀】专知诚挚邀请各位专业者加入AI创作者计划!了解使用专知!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!

点击“阅读原文”,使用专知!