【CMU博士论文2019】建立知识感知的自然语言理解系统,附118页论文全文下载

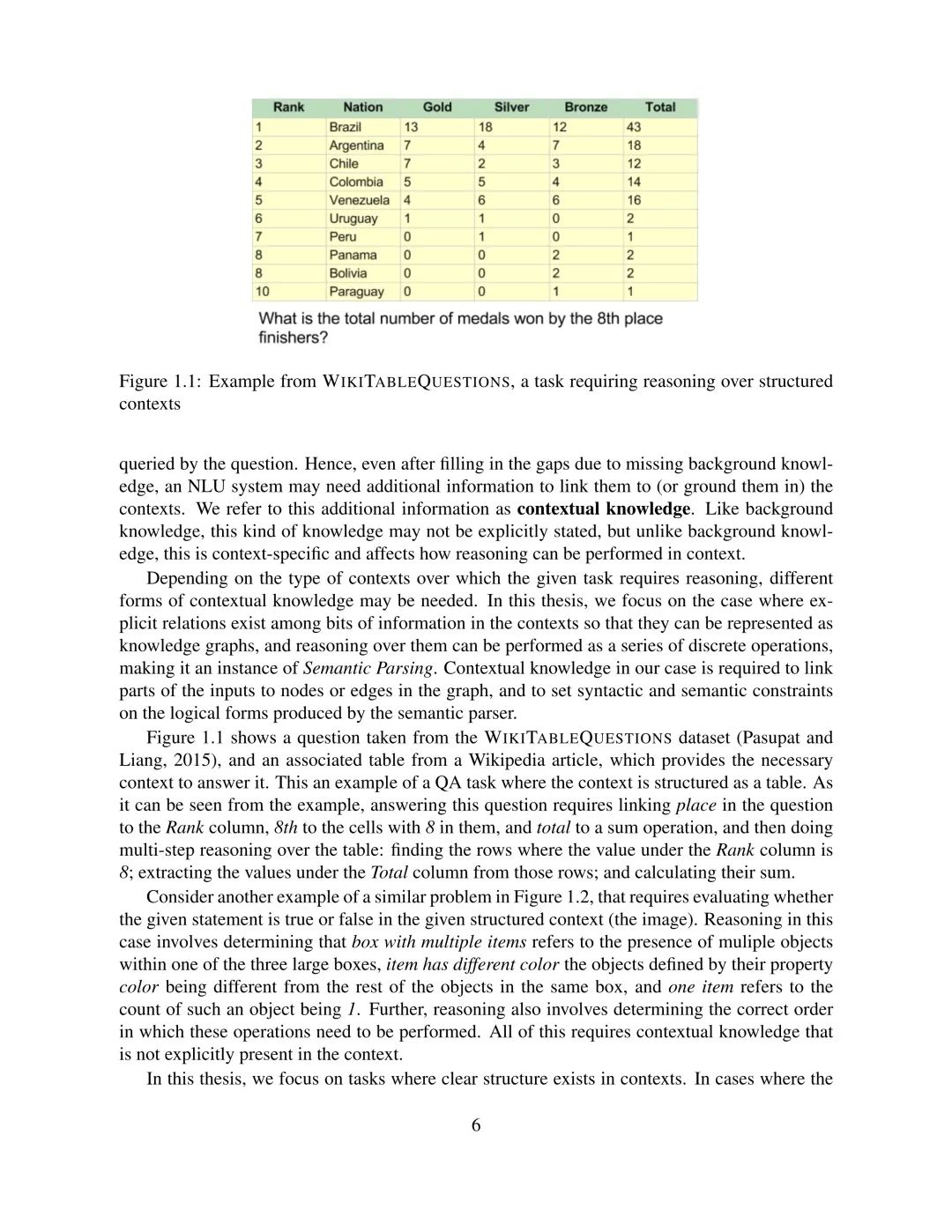

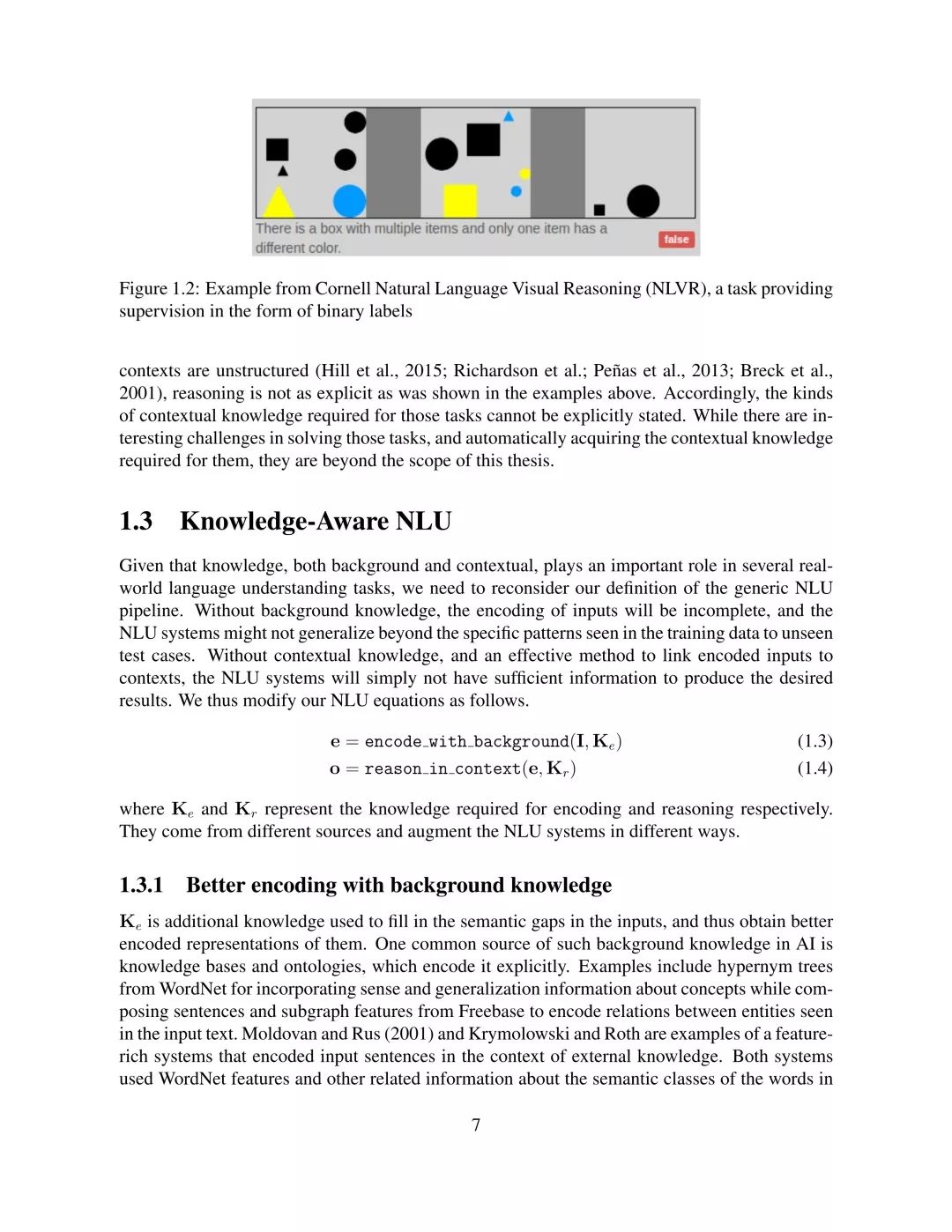

【导读】自然语言理解(NLU)系统需要把人类产生的文本进行编码,然后在深层次的语义层面上进行推理。NLU系统通常都会包括到两个部分:第一个是编码器(encoder),它将语言中的单词组合在一起作为输入,编码产生一个新的表示,然后将这些表示作为第二部分--预测器(predictor)中的特征,然后在这些编码过的输入信息上进行推理并生成所需的输出。本文的研究目标是构建一个端到端的NLU系统,能够结合相关的背景知识对输入信息进行编码,然后在上下文的语境中对其进行推理。

个人主页:

http://www.cs.cmu.edu/~pdasigi/

论文地址:

http://www.cs.cmu.edu/~pdasigi/assets/pdf/pdasigi_thesis.pdf

介绍

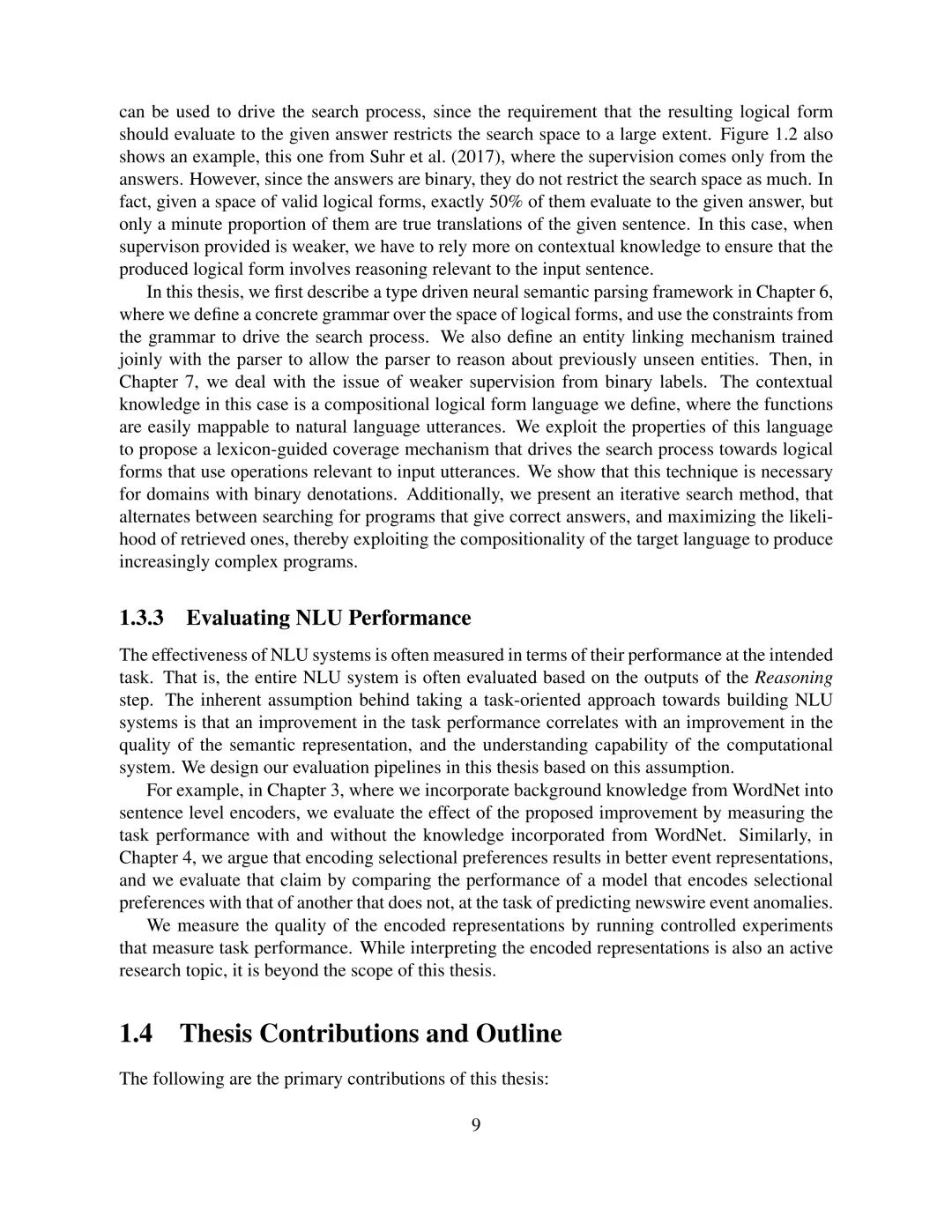

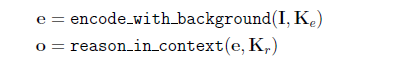

鉴于背景知识和上下文知识在一些真实的语言理解任务中扮演着重要的角色,我们需要重新考虑我们对通用NLU管道的定义。如果没有背景知识,对输入信息的编码将会是不完整的,对于那些未接触过的测试数据,NLU系统单单依靠有限的训练集很可能不能学习到泛化能力强的模型。如果没有上下文知识,没有一种有效的方法将编码过的输入信息和上下文结合起来,NLU系统将得不到足够的信息来产生我们期望的结果。因此,本文修改NLU的定义公式如下:

Ke和Kr分别表示编码和推理需要的知识。他们来源不同,以不同的方式增强了NLU系统。

论文目录

Part I 背景知识编码

1.相关工作:学习编码

2.用本体论的背景知识来编码句子

3.将选择偏好作为编码事件的背景知识

Part II 用上下文知识进行推理

1.相关工作:学习推理

2.用于语义分析的解码约束

3.使用迭代覆盖引导搜索来训练语义分析器

作者介绍

Pradeep Dasigi毕业于CMU(美国卡耐基梅隆大学),目前是Allen人工智能研究所的研究员。他的研究方向主要是构建知识注意力的自然语言理解系统(knowledge-aware Natural Language Understanding systems ),该系统能够充分利用知识库和其他来源的背景信息,也能够对结构化或者无结构化的上下文进行推理。

请关注专知公众号(点击上方蓝色专知关注)

后台回复“CMUKANLU” 就可以获取《knowledge-aware Natural Language Understanding (NLU) 》的下载链接~

部分论文预览