中科院信工所发布《深度学习系统的隐私与安全》综述论文,187篇文献总结

【导读】在过去的几年里,深度学习取得了巨大的成功,无论是从政策支持还是科研和工业应用,都是一片欣欣向荣。然而,近期的许多研究发现,深度学习拥有许多固有的弱点,这些弱点甚至可以危害深度学习系统的拥有者和使用者的安全和隐私。深度学习的广泛使用进一步放大了这一切所造成的后果。为了揭示深度学习的一些安全弱点,协助建立健全深度学习系统,来自中科院信息工程所和中国科学院大学网络安全学院的研究人员,全面的调查了针对深度学习的攻击方式,并对这些手段进行了多角度的研究。

内容简介:

深度学习取得了巨大的成功,成为人工智能最重要的驱动力。它支持多个领域,包括图像分类、语音识别、自然语言处理和恶意软件检测。由于计算能力的巨大进步和数据量的急剧增加,与传统技术相比,深度学习在这些场景中显示出了更大的潜力。深度学习擅长特征学习,加深对一个对象的理解,具有无与伦比的预测能力。在图像识别中,卷积神经网络(convolutional neural networks, CNNs)可以为我们对不同的未知图像进行分类,有些甚至比人类的分类性能更好。在自然语言处理中,递归神经网络(RNNs)或长短时记忆网络(LSTMs)可以帮助我们翻译和总结文本信息。自动驾驶、语音识别、恶意软件检测等领域都广泛应用了深度学习。近年来,物联网和智能家居系统也应运而生。因此,我们正步入智能时代。

然而,我们周围的基于深度学习的智能系统正面临着许多安全问题。机器学习模型可以通过api来窃取[160]。智能语音系统可以执行意想不到的命令[182]。3d打印对象可以骗过现实世界的图像分类器[20]。此外,为了确保安全,自动驾驶等技术在广泛应用之前需要大量的安全测试[157][185]。在过去的几年里,深度学习的安全性引起了许多相关研究者和实践者的关注。他们正在探索和研究针对深度学习系统的潜在攻击以及相应的防御技术。Szegedy等人[154]探索了神经网络的稳定性,揭示了神经网络在难以察觉的扰动面前的脆弱特性。从那以后,对抗性攻击迅速发展成为人工智能和安全领域的一个热门术语。许多努力都致力于披露漏洞在不同深度学习模型(例如,CNN [129] [114] [113], LSTM[54][39][131],强化学习(RL)[74],生成对抗网络(GAN)[91][138]),同时测试深度学习系统的安全性和健壮性[90][106][124][153][62][177]。另一方面,深度学习系统的广泛商业部署引起了对专有资产保护的兴趣,如训练数据[117][134][186][11]和模型参数[84][96][72][88]。它引发了一场战争,在这场战争中,隐私猎手利用商业间谍从竞争对手那里收集隐私,而相应的防御者则采取广泛的措施来抵御攻击。

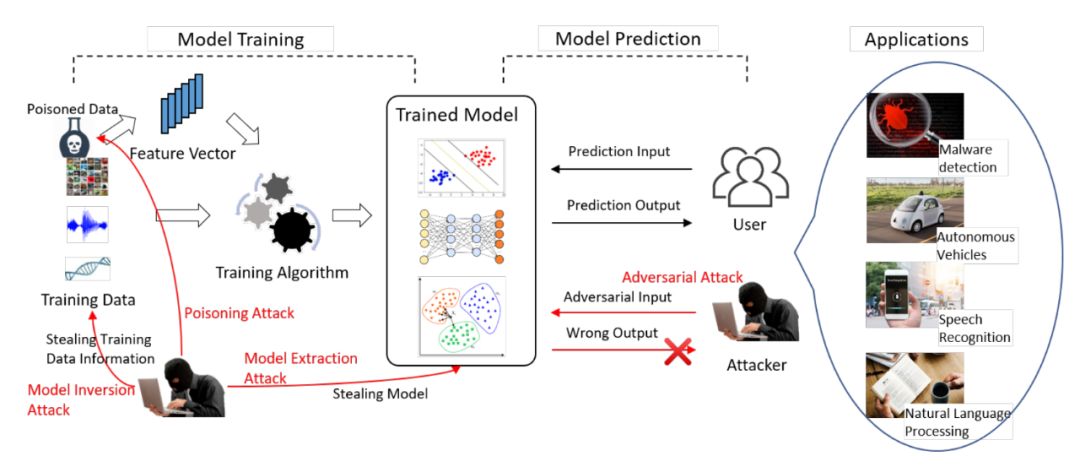

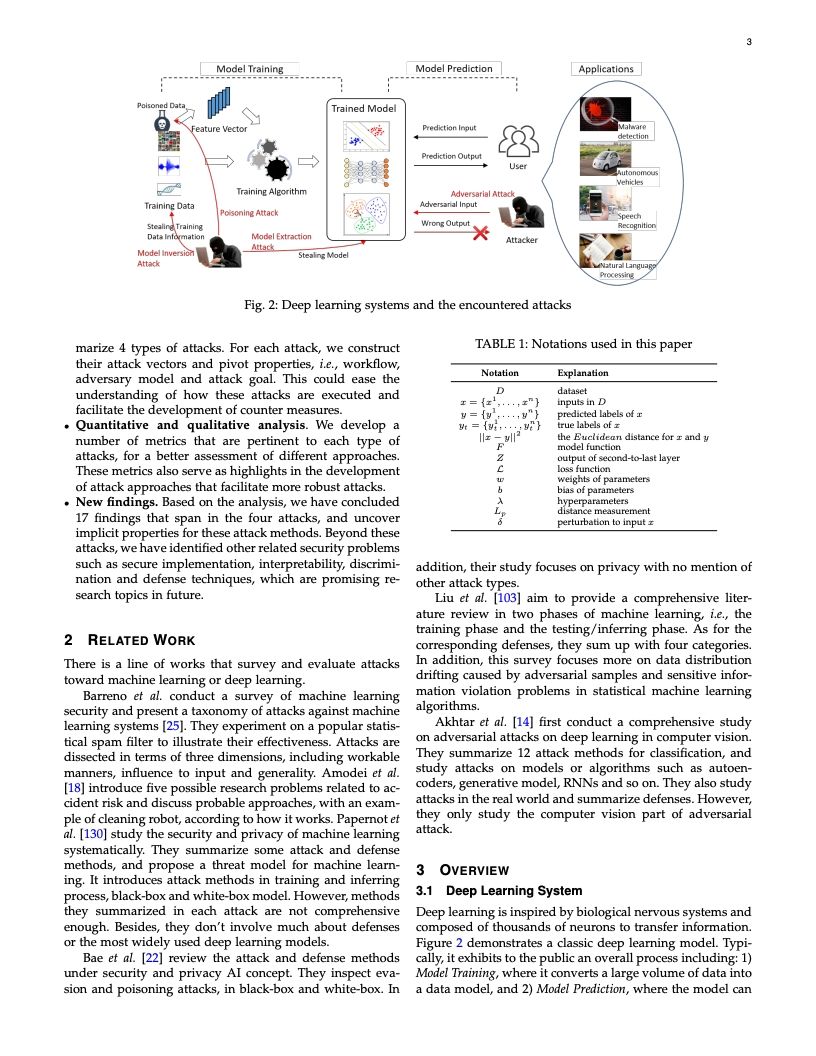

为了全面了解深度学习中的隐私和安全问题,我们对相关文献和系统进行了广泛的调查。总共有137种出版物被研究,它们跨越了四个主要领域:图像分类、语音识别、神经语言处理和恶意软件检测。由于全面调查几乎是不可能的,所以我们选择了过去五年里更具代表性的研究。总的来说,我们将这些攻击分为四类:模型提取攻击、模型反转攻击、数据中毒攻击和对抗性攻击。特别是,模型提取和反演攻击针对的是隐私(参看第4、5节),而数据毒害和对抗性攻击可以通过降低深度学习模型的形成或制造可以欺骗模型的难以察觉的扰动来影响预测结果(参看第6、7节)。

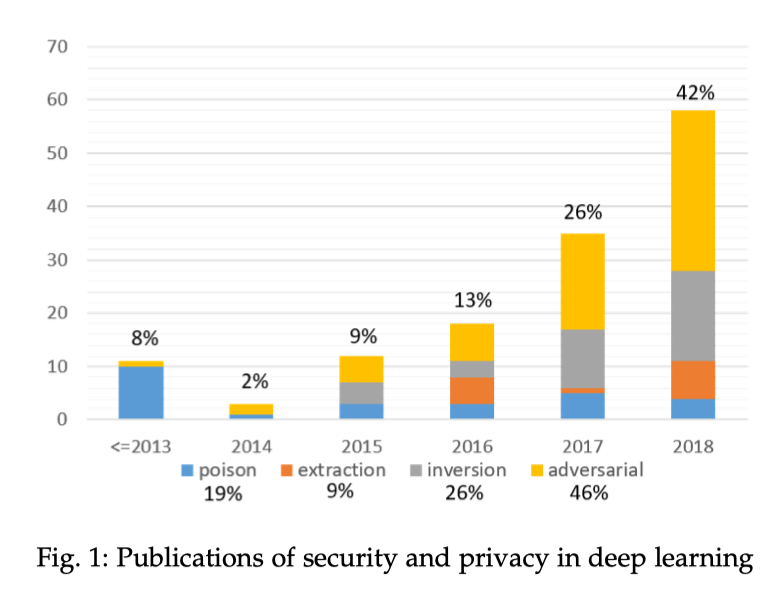

图1显示了过去5年关于这些攻击的出版物。相关出版物数量在过去5年大幅增长,2017年增长100%,2018年增长61.5%。对抗性攻击显然是最有趣的研究,占据了研究人员46%的注意力。值得一提的是,最近人们对模型反转攻击的兴趣越来越大,这主要归功于对训练数据的费力处理(更多的讨论可以在第8节中找到)。

在本研究中,我们首先介绍了深度学习的背景,并总结了相关风险以及面向公众部署的商用深度学习系统。针对每种类型的攻击,系统地研究其能力、工作流程和攻击目标。更具体地说,如果一个攻击者面对一个商业的深度学习系统,它可以采取什么行动来达到目的。在所研究的方法中,系统是如何一步步被破坏的,以及什么会对用户和系统所有者产生影响。此外,我们还开发了一些度量标准来评估这些方法,如减少查询策略、恢复训练数据的精度和使用扰动图像的距离。在定量和定性分析的基础上,我们得出了许多见解,包括具体攻击技术的流行程度、这些方法的优缺点、未来的发展趋势等。

部分文章:

论文地址:

https://arxiv.org/abs/1911.12562v1

https://www.zhuanzhi.ai/paper/fc7f1fe96e61491594fe5c30bbfa98d5

后台回复“TPSD” 就可以获取综述全文的下载链接索引~