近期必读的9篇 NeurIPS 2019【图神经网络(GNN)】相关论文

【导读】NeurIPS 是全球最受瞩目的AI、机器学习顶级学术会议之一,每年全球的人工智能爱好者和科学家都会在这里聚集,发布最新研究。NeurIPS 2019大会将在12月8日-14日在加拿大温哥华举行。据官方统计消息,NeurIPS今年共收到投稿6743篇,其中接收论文1428篇,接收率21.1%,再次打破了历年来的接收记录。近期,随着会议的临近,NeurIPS官网也公布了所有接受论文列表,小编发现搜索graph,标题大概有八十多篇相关paper,可见今年的graph相关的论文依然火爆。

为此,专知小编提前整理了NeurIPS 2019图神经网络(GNN)比较有意思的的论文—HyperGCN、视觉常识推理、GRAN、HGCN、GNNExplniner

CIKM2019GNN、ICLR2020GNN、EMNLP2019GNN、ICCV2019GNN_Part2、ICCV2019GNN_Part1、NIPS2019GNN、IJCAI2019GNN_Part1、IJCAI2019GNN_Part2、 KDD2019GNN、ACL2019GNN、CVPR2019GNN、ICML2019GNN

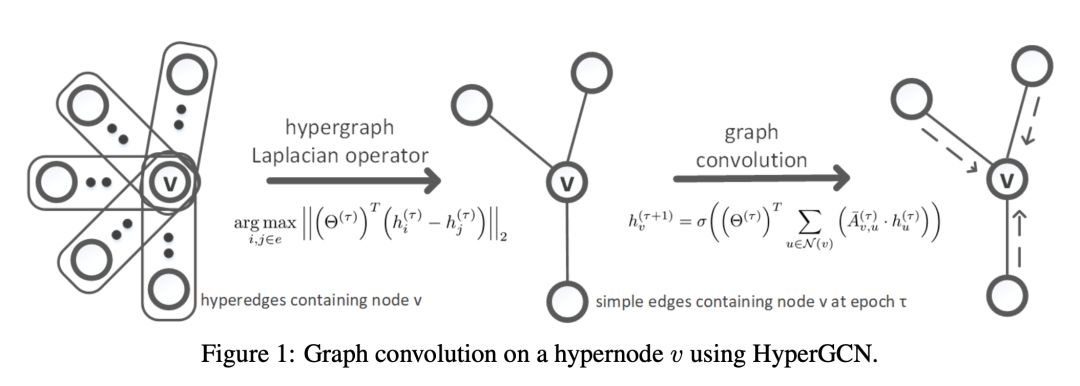

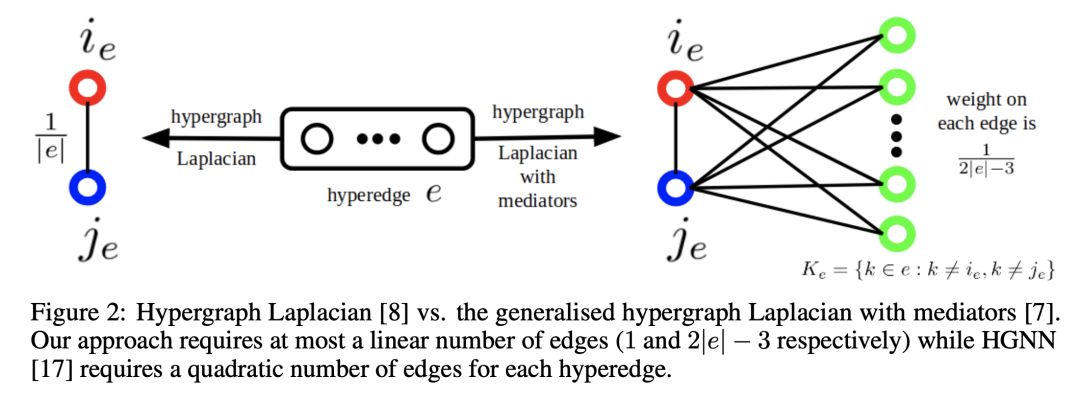

1. HyperGCN: A New Method of Training Graph Convolutional Networks on Hypergraphs

作者:Naganand Yadati, Madhav Nimishakavi, Prateek Yadav, Vikram Nitin, Anand Louis and Partha Talukdar

摘要:在许多诸如co-authorship网络,co-citation网络等现实世界的网络中,关系是复杂的并且超出了成对关联。超图(Hypergraph)提供了一种灵活而自然的建模工具来对这种复杂的关系进行建模。在许多真实的网络中,这种复杂关系普遍存在,因此激发了使用超图学习的问题。一种流行的学习方法是基于超图的半监督学习(SSL),其目标是对超图中未标记的顶点分配标签。受图卷积网络(GCN)对于图上的半监督学习十分有效的启发,我们提出了HyperGCN,这是一种基于超图的谱论(sepctral theory)来训练用于超图上半监督学习的GCN的新方法。我们通过在真实世界的超图上进行SSL和组合优化的详细实验来证明HyperGCN的有效性,并分析它何时会比最新基准更有效。我们已经提供了源代码。

网址:

https://papers.nips.cc/paper/8430-hypergcn-a-new-method-for-training-graph-convolutional-networks-on-hypergraphs

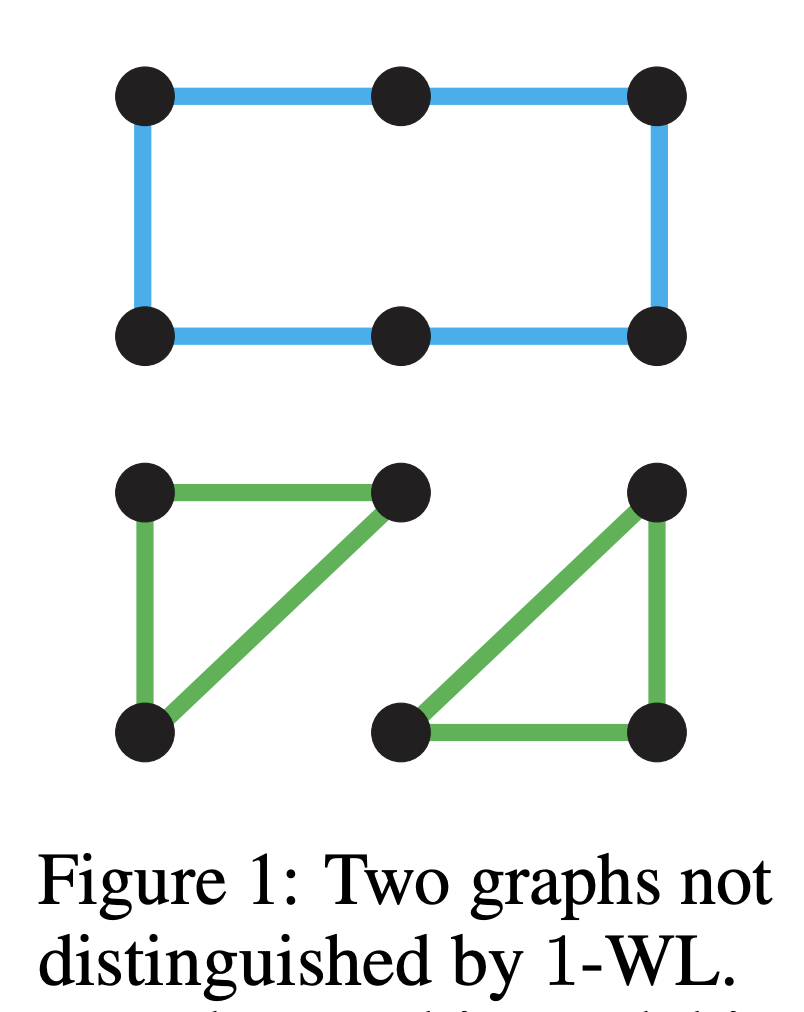

2. Provably Powerful Graph Networks

作者:Haggai Maron, Heli Ben-Hamu, Hadar Serviansky and Yaron Lipman

摘要:近来,Weisfeiler-Lehman (WL)图同构测试被用来衡量图神经网络(GNN)的表达能力,结果表明,流行的信息传递GNN方法不能区分1-WL测试无法区分的图。然而,许多简单的图都无法通过1-WL测试。

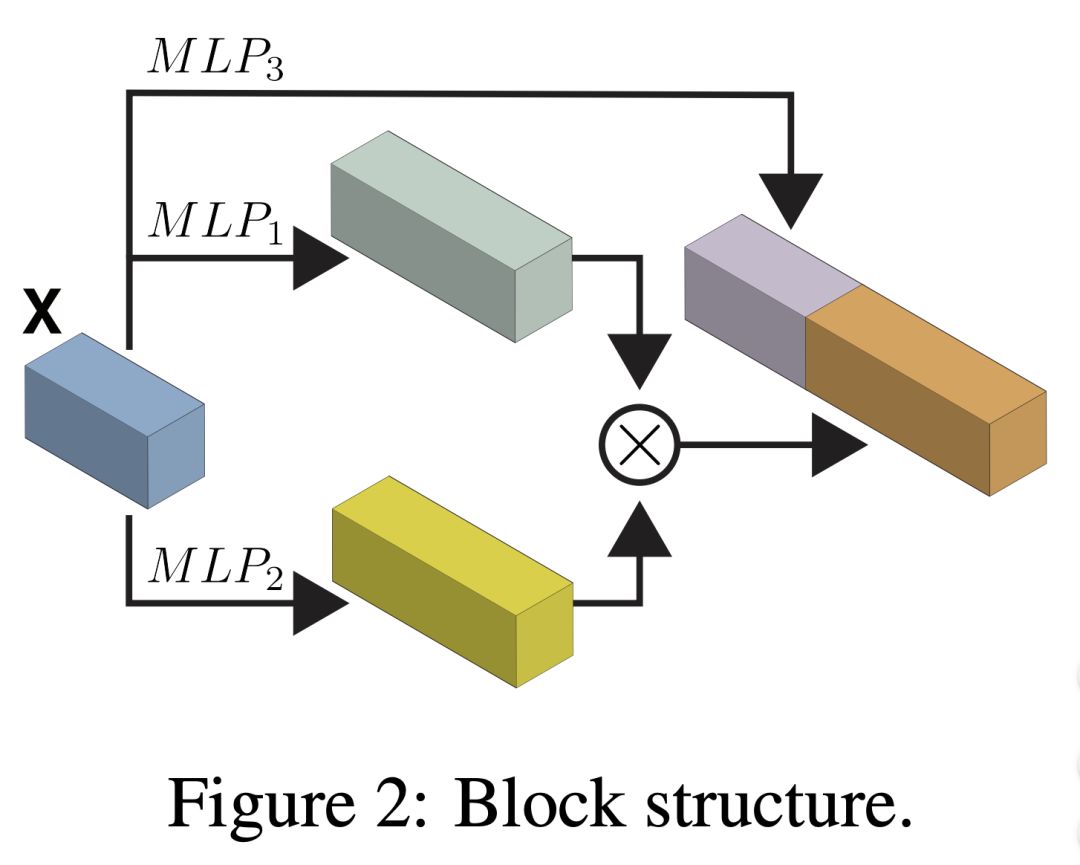

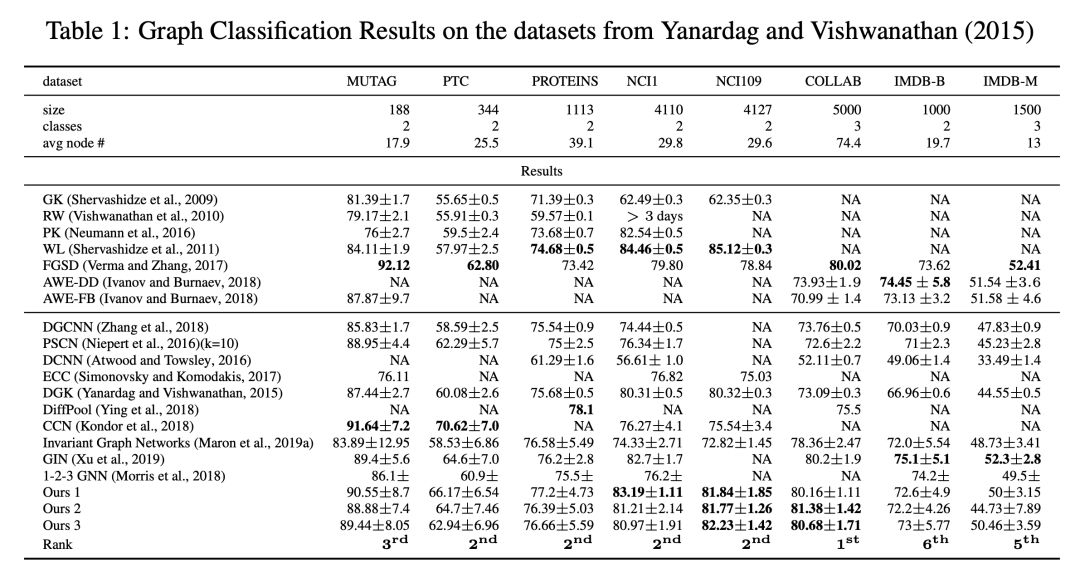

为了寻找更具表现力的图学习模型,我们基于最近的k阶不变和等变图神经网络,得出了如下两个结果:首先,我们证明了这种k阶网络可以同k-WL测试一样很好的区分非同构图,k> 2=时k-WL测试比1-WL测试更强大,这表明这些k阶网络模型比信息传递模型更强。但是,这些模型更高的表达能力伴随着处理高阶张量更高的计算成本。其次,我们将目标设定为建立可以证明的更强大,简单和可扩展的模型,并且证明仅包含比例恒等算子(scaled identity operator)的简化2阶网络,使用单个二次运算(矩阵乘法)增强,就具有可证明的3-WL的表达能力。换句话说,我们提出了一个简单的模型,该模型将标准多层感知机(MLP)的应用插入到特征维度和矩阵乘法中。我们通过在流行的图分类和回归任务上展示最新结果来验证该模型。据我们所知,这是第一个可证明的具有3-WL表达能力的实用不变/等变模型,比信息传递模型更强大。

网址:

https://papers.nips.cc/paper/8488-provably-powerful-graph-networks

3. Hyper-Graph-Network Decoders for Block Codes

作者:Eliya Nachmani and Lior Wolf

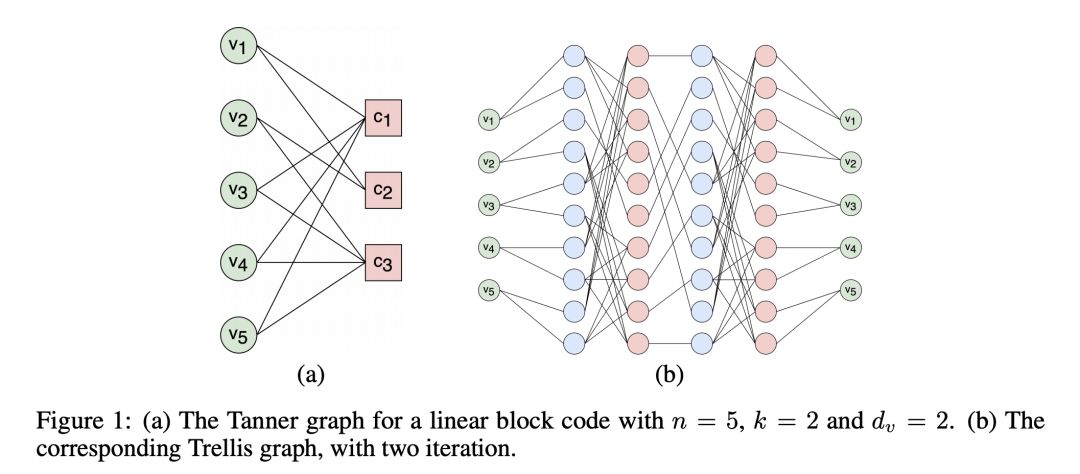

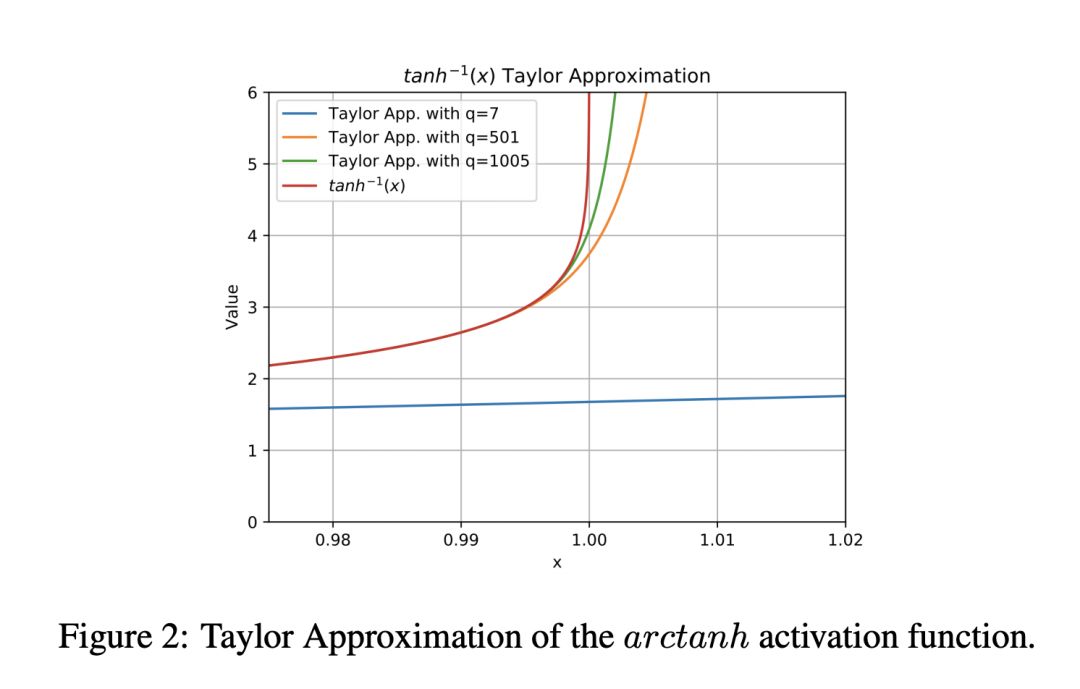

摘要:对于短BCH码,神经解码器的性能优于经典的信息传递技术。在本工作中,通过使用图神经网络进行信息传递,我们在更大的algebraic block codes族中使用神经解码器。Tanner图中每个变量节点处的子网络参数都是从超网(hypernetwork)获得的,该超网接收当前消息的绝对值作为输入。为了增加稳定性,我们使用了基于高阶泰勒近似的arctanh激活的简化版本。我们的结果表明,对于大量的来自不同代码族(BCH,LDPC,Polar)的algebraic block codes,使用我们的方法获得的解码性能优于 vanilla belief 传播方法以及文献中的其他学习技术。

网址:

https://papers.nips.cc/paper/8504-hyper-graph-network-decoders-for-block-codes

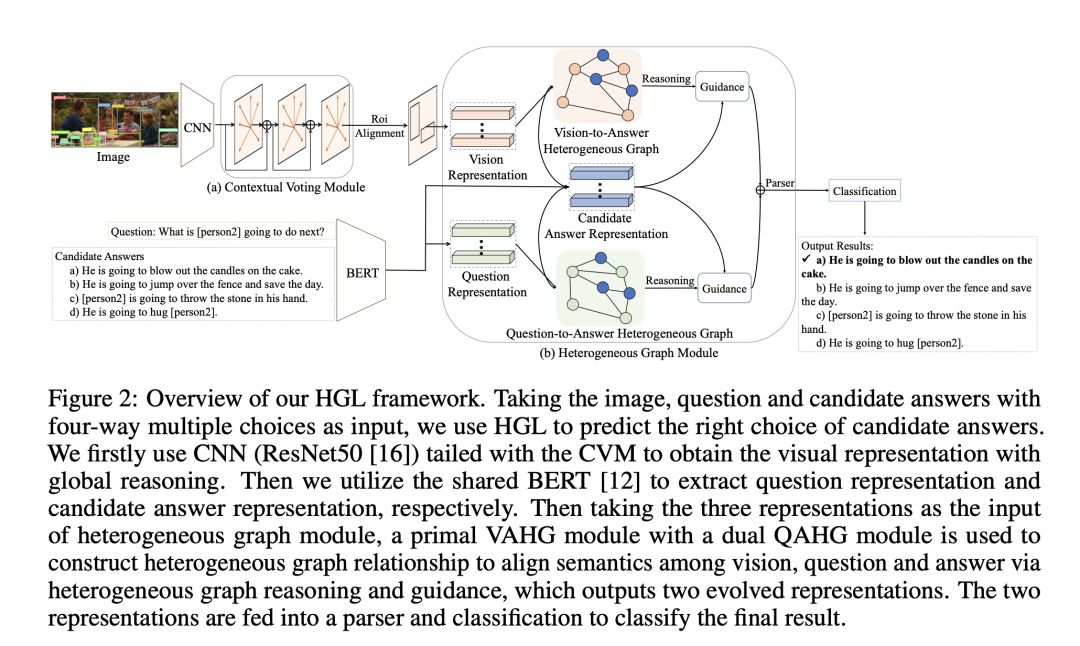

4. Heterogeneous Graph Learning for Visual Commonsense Reasoning

作者:Weijiang Yu, Jingwen Zhou, Weihao Yu, Xiaodan Liang and Nong Xiao

摘要:视觉常识推理任务旨在引导研究领域去处理具有预测正确答案的能力的认知级推理,同时提供令人信服的推理路径,从而产生了三个子任务,即:Q→A,QA→R和Q→AR. 。在视觉和语言领域以及知识推理之间产生恰当的语义一致性以产生有说服力的推理路径方面,存在巨大的挑战。现有的工作要么采用强大的端到端网络,该网络无法产生可解释的推理路径,要么仅探索视觉对象(同质图)的内部关系,而忽略视觉概念和语言单词之间的跨域语义一致性。在本文中,我们提出了一个新的异构图学习(Heterogeneous Graph Learning, HGL)框架,该框架可无缝集成图内和图间推理,以连接视觉和语言领域。我们的HGL包含一个主要的视觉-答案异构图(VAHG)模块和一个双重的问题-答案异构图(QAHG)模块,以交互方式完善语义协同的推理路径。此外,我们的HGL集成了上下文voting模块,可利用长距离视觉上下文进行更好的全局推理。在大型视觉常识推理基准上进行的实验证明了我们提出的模块在三个任务上的优越性能(准确率在Q→A上提高了5%,在QA→R上提高了3.5%,在Q→AR上提高了5.8%).

网址:

https://papers.nips.cc/paper/8544-heterogeneous-graph-learning-for-visual-commonsense-reasoning

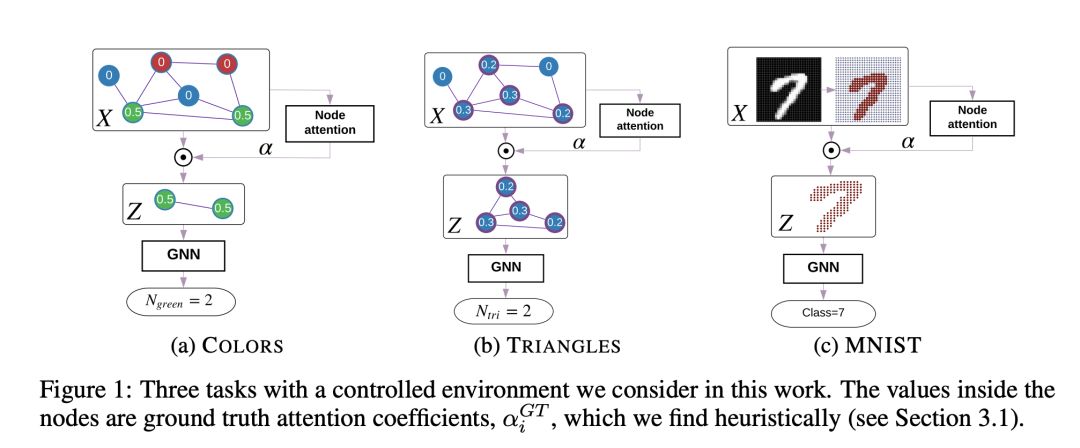

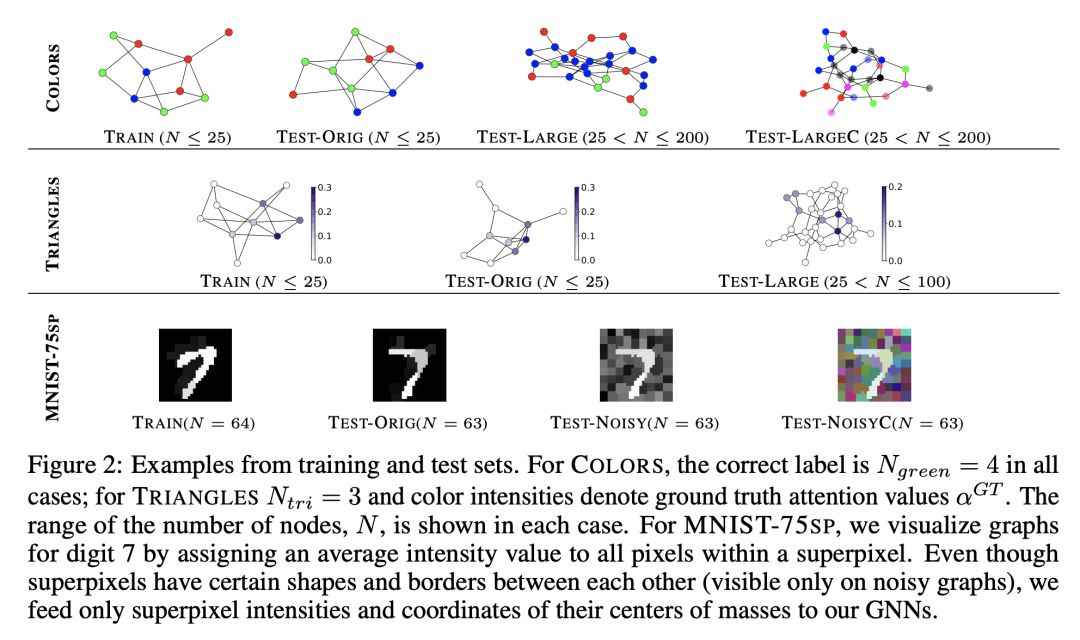

5. Understanding Attention and Generalization in Graph Neural Networks

作者:Boris Knyazev, Graham W. Taylor and Mohamed R. Amer

摘要:我们旨在更好地了解图神经网络(GNN)中节点的注意力机制,并确定影响其有效性的因素。我们特别关注attention GNNs推广到更大、更复杂或有噪声的图的能力。受图同构网络研究的启发,我们设计了简单的图推理任务,使我们能够在受控环境中研究注意力机制。我们发现,在典型条件下,注意力的影响可忽略不计甚至是有害的,但是在某些条件下,注意力在我们的某些分类任务中的表现获得了超过60%的出色提升。在实践中满足这些条件是具有挑战性的,并且通常需要最优的初始化或有监督的注意力训练。我们提出了一种替代方法,并以弱监督的方式训练attention,以接近监督模型的性能,并且与无监督模型相比,改进了在多个合成数据集和真实数据集上的结果。源代码和数据集:

https://github.com/bknyaz/graph_attention_pool.

网址:

https://papers.nips.cc/paper/8673-understanding-attention-and-generalization-in-graph-neural-networks

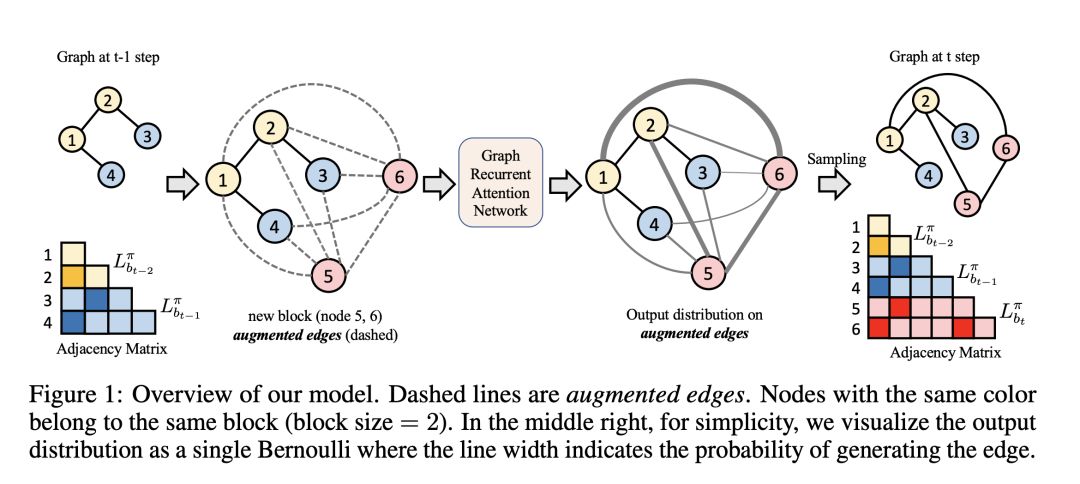

6. Efficient Graph Generation with Graph Recurrent Attention Networks

作者:Renjie Liao, Yujia Li, Yang Song, Shenlong Wang, William L. Hamilton, David Duvenaud, Raquel Urtasun and Richard Zemel

摘要:我们提出了一个新的图的高效表达的深层生成模型,称为图的递归注意力网络(Graph Recurrent Attention Networks,GRANs)。我们的模型一次生成一组节点和相关边的图。块的大小和采样步幅使我们可以权衡采样质量以提高效率。与以往的基于RNN的图生成模型相比,我们的框架使用图神经网络(GNN)更好地捕获了图的已生成部分和将要生成的部分之间的自回归条件。这不仅降低了对节点顺序的依赖性,而且避免了由RNNs的顺序性所带来的long-term瓶颈。此外,我们使用伯努利的混合参数化每个块的输出分布,它捕获块内生成的边之间的相关性。最后,我们通过边缘化一系列规范序来处理生成中的节点排序。与以前的模型相比,在标准基准上,我们实现了最先进的时间效率和样本质量。此外,我们证明了我们的模型能够生成高达5K节点的高质量大型图。我们的代码发布于:https://github.com/lrjconan/GRAN。

网址:

https://papers.nips.cc/paper/8678-efficient-graph-generation-with-graph-recurrent-attention-networks

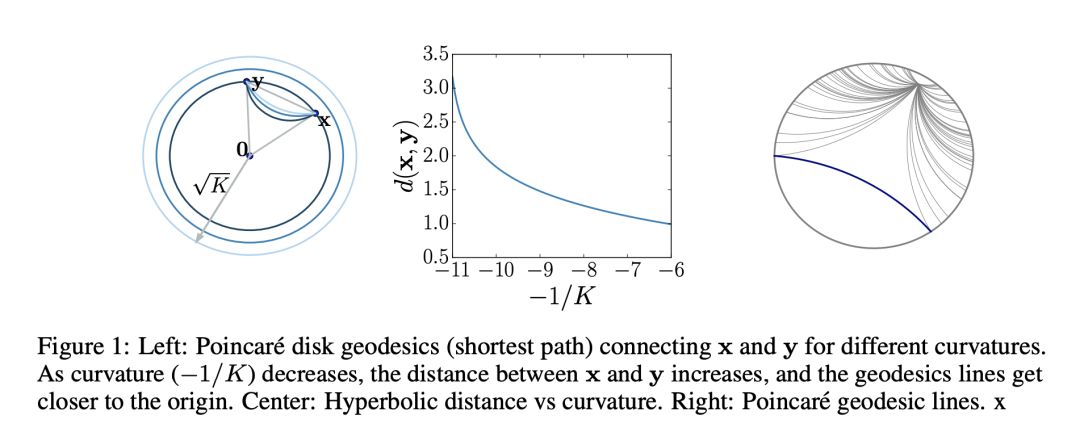

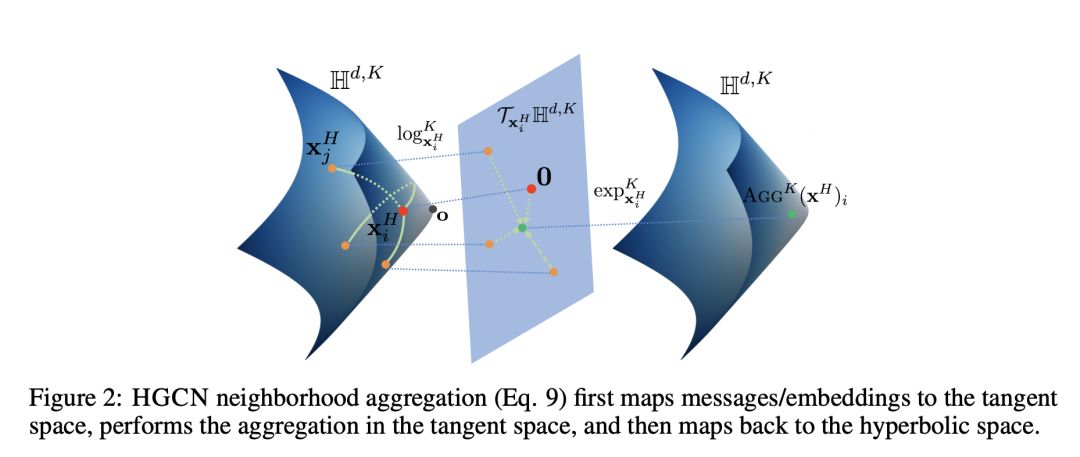

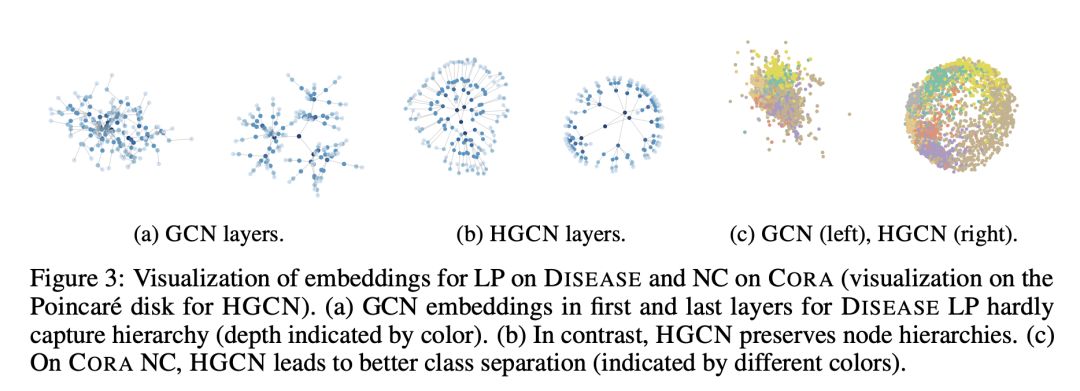

7. Hyperbolic Graph Convolutional Neural Networks

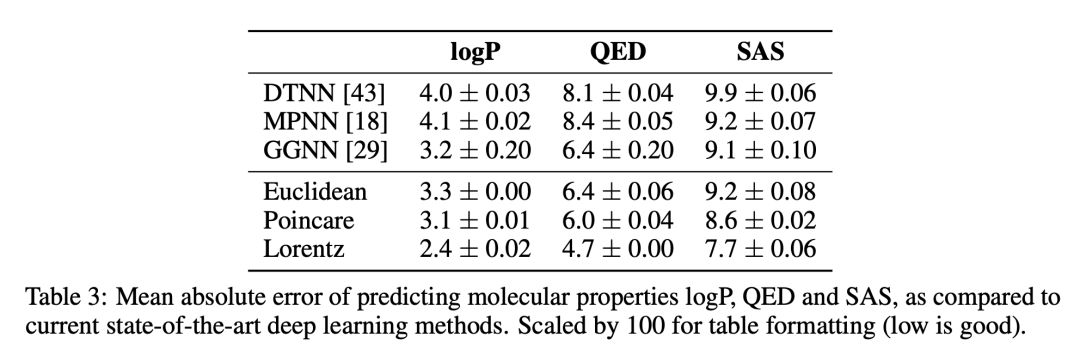

作者:Ines Chami, Rex Ying, Christopher Re´ and Jure Leskovec

摘要:图卷积神经网络(GCNs)将图中的节点嵌入到欧几里德空间中,事实证明,当将具有无标度或层次结构的真实世界图嵌入时,这会引起较大的失真。双曲几何提供了一个令人兴奋的替代方法,因为它使嵌入具有更小的失真。但是,将GCN扩展到双曲几何存在一些独特的挑战,因为尚不清楚如何在双曲空间中定义神经网络操作,例如特征转换和聚合。此外,由于输入特征通常是欧几里德的,因此如何将特征转换为具有适当曲率的双曲型嵌入尚不清楚。在这里,我们提出了双曲线图卷积神经网络(HGCN),这是第一个归纳式双曲GCN,它利用GCN的表达能力和双曲线几何来学习hierarchical和scale-free的图的归纳节点表示。我们在双曲空间的双曲面模型中导出GCNs运算,并将欧几里德输入特征映射到在每一层具有不同可训练曲率的双曲空间中的嵌入。实验表明,与欧几里德类比法相比,HGCN可以学习保持层次结构的嵌入,并提高性能,即使嵌入的维数非常低:与最先进的gcn相比,HGCN在ROC-AUC上实现了63.1%的链路预测误差,在F1上实现了47.5%的节点分类误差,提高了Pubmed数据集的技术水平。

网址:

https://papers.nips.cc/paper/8733-hyperbolic-graph-convolutional-neural-networks

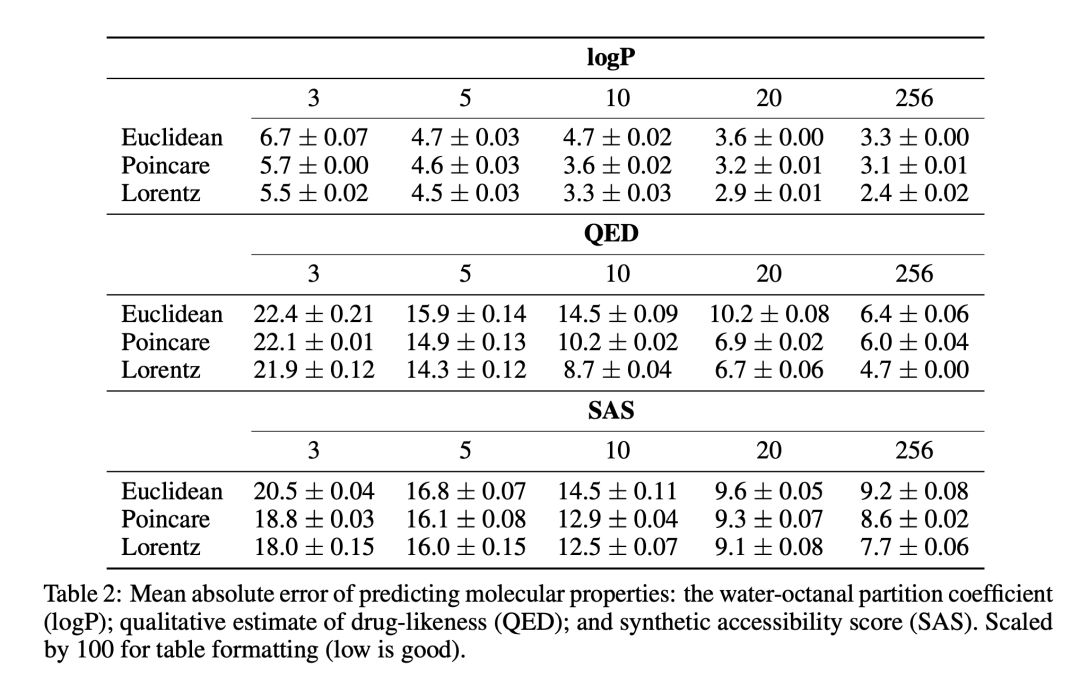

8. Hyperbolic Graph Neural Networks

作者:Qi Liu, Maximilian Nickel and Douwe Kiela

摘要:从图结构数据中学习是机器学习和人工智能的一项重要任务,而图神经网络(GNNs)在这方面也显示出了巨大的潜力。受几何表示学习最新进展的鼓舞,我们提出了一个新奇的GNN架构,该架构用可微的指数函数和对数映射在黎曼流形上学习表示。我们提出了一种可扩展的算法,与欧几里得几何和双曲线几何相比,该算法可以对图的结构特性进行建模。我们在实验中也证明了双曲图神经网络(GNNs)在各种基准数据集上的表现有实质性的提升。

网址:

https://papers.nips.cc/paper/9033-hyperbolic-graph-neural-networks

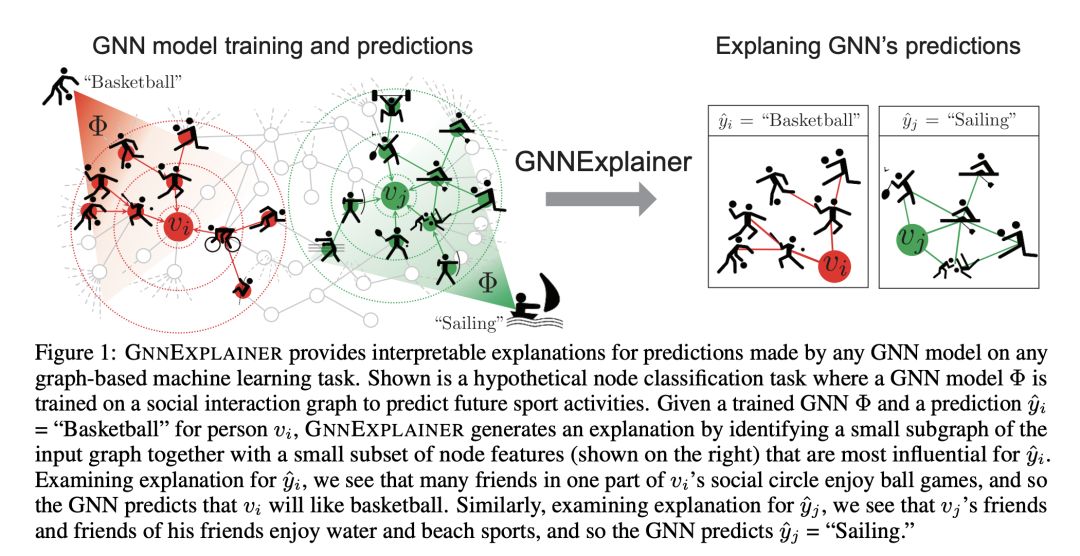

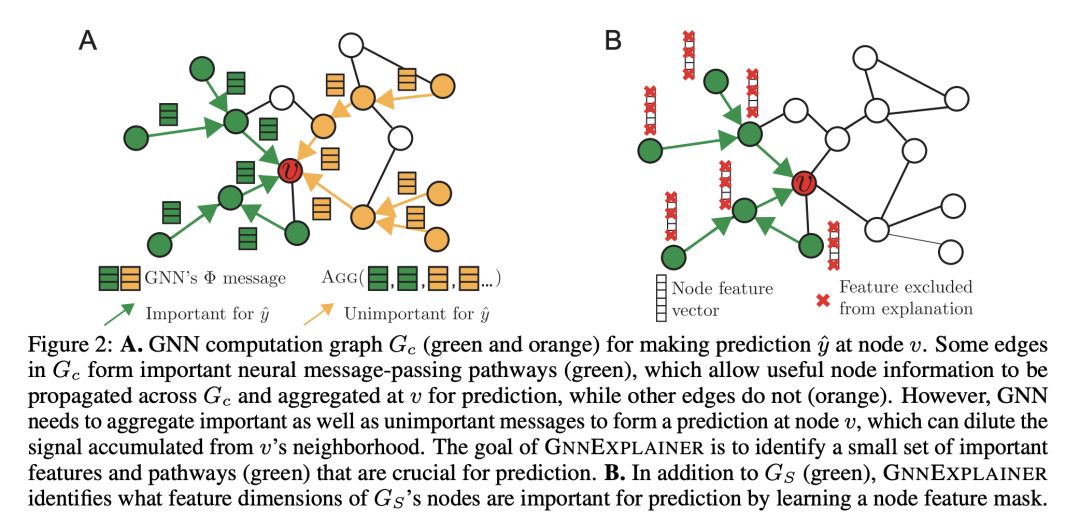

9. GNNExplainer: Generating Explanations for Graph Neural Networks

作者:Rex Ying, Dylan Bourgeois, Jiaxuan You, Marinka Zitnik and Jure Leskovec

摘要:图神经网络(GNNs)是机器学习在图结构数据上学习的一个有效的工具。GNNs通过沿着输入图中节点之间的边循环地传递神经信息来聚合图中节点之间的特征。然而,把图结构和特征信息融合到一起会导致模型变得更加复杂,而且关于GNNs的可解释性预测仍旧无法得到解决。我们提出了GNNExplniner, 这是第一种通用的,与模型无关的方法,可为任何基于图的机器学习任务模型的预测提供解释。给定一个实例, GNNExplainer会确定一个子图结构和一小部分在GNN预测中起关键作用的节点特征。此外,GNNExplainer可以为整个实例生成一致和简洁的解释。我们将GNNExplainer定义为一个优化任务,它最大化了GNN的预测结果和可能的子图结构分布之间的相互信息。实验表明,我们的方法能够识别重要的图结构和节点特征,并且在解释精度上比其他基线方法高出43.0%。GNNExplainer的优点有很多,从可视化语义相关结构的能力到解释预测结果的能力,再到深入了解有缺点的GNNs网络的错误之处。

网址:

https://papers.nips.cc/paper/9123-gnnexplainer-generating-explanations-for-graph-neural-networks

请关注专知公众号(点击上方蓝色专知关注)

后台回复“NIPS2019GNN2” 就可以获取《9篇论文》的下载链接~

https://www.zhuanzhi.ai/topic/2001785662228213/paper