【重磅】深度学习顶会ICLR2018评审结果出炉,一文快速了解评审分析简报和评分最高的十篇论文

点击上方“专知”关注获取专业AI知识!

【导读】ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年2017年办到第六届,已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。ICLR 采用Open Review 评审制度。Open Review 则非常不同,根据规定,所有提交的论文都会公开姓名等信息,并且接受所有同行的评价及提问(open peer review),任何学者都可或匿名或实名地评价论文。而在公开评审结束后,论文作者也能够对论文进行调整和修改。这几天ICLR 2018的审稿结果陆续出来了,让我们来看一下。

【重磅】深度学习顶会 ICLR 2018 匿名提交论文列表(附pdf下载链接)

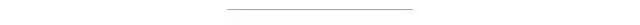

今年ICLR 2018共收到981篇有效稿件,截止2017年12月1日,已经有979篇论文收到至少一个评分。下图是平局分的分布,平均得分是5.24,中位得分是5.33 。

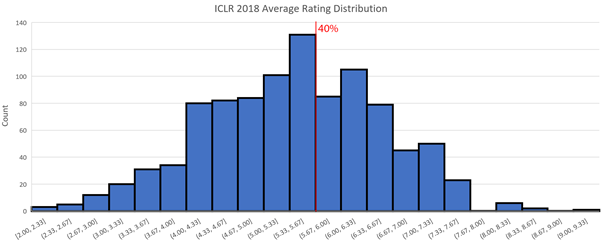

根据karpathy之前的博客统计,ICLR2017共收到491篇论文提交,其中15篇被录用为oral论文占3%,183篇录用为Poster论文占37.3%。之前统计ICLR2017Poster论文的得分分布见下图。

▌得分最高的十篇论文

| Ranking | Rating | Title |

| 9.00 | Certifiable Distributional Robustness with Principled Adversarial Training |

| 8.56 | On theConvergence of Adam and Beyond |

| 8.33 | Emergence of grid-like representations by training recurrent neural networks toperform spatial localization |

|8.33 | Multi-Scale Dense Networks for Resource Efficient Image Classification |

| 8.09 | i-RevNet: Deep Invertible Networks |

| 8.00 | Wasserstein Auto-Encoders |

| 8.00 | Stabilizing Adversarial Nets with Prediction Methods |

| 8.00 | Learning to Represent Programs with Graphs |

| 8.00 | Boosting Dilated Convolutional Networks with Mixed Tensor Decompositions |

| 8.00 | Continuous Adaptation via Meta-Learning in Nonstationary and CompetitiveEnvironments |

需要注意的是,目前并不是所有的评分都已经打出来了。现在得分最高的论文是 《Certifiable DistributionalRobustness with Principled Adversarial Training》。另外一篇值得注意的论文是 《Progressive Growing of GANs forImproved Quality, Stability, and Variation 》得分为 8,8,1

声明:

本文是受@plrz77 的ICLR2017的统计报告启发。

相关链接:

Search ICLR 2018

http://search.iclr2018.smerity.com/

ICLR 2017Overview by @plrz77.

https://prlz77.github.io/iclr2017-stats/

ICLR 2017 vs arxiv-sanity by @karpathy

https://medium.com/@karpathy/iclr-2017-vs-arxiv-sanity-d1488ac5c131

参考链接:

https://liyaguang.github.io/iclr2018-stats

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域24个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

同时欢迎各位用户进行专知投稿,详情请点击:

【诚邀】专知诚挚邀请各位专业者加入AI创作者计划!了解使用专知!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请扫一扫加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!

点击“阅读原文”,使用专知!