CMU开源NLP生成句子评估工具,帮你快速分析模型产出

【导读】机器翻译、自动摘要、对话生成等NLP里的很多任务,其目的都是生成句子。为了更好的生成句子,提升句子质量,我们需要对模型生成的句子进行多种维度的分析,近期卡内基梅陇大学的NeuLab团队,开源了其使用的句子生成评估工具:compare-mt。

对于NLP研究者来说,评估模型生成的句子是再频繁不过的操作,日常有各种评估方法,如:BLEU,ROUGE等等。但是对于不同的任务,人们需要写多种质量评估方法;而且为了更好的调整模型,人们还需要很多特定的评估,如:Aggregate Scores,N-gram Difference Analysis等。CMU NeuLab开源的Compare-mt希望改变上述现状,旨在快速且全面的评估生成的句子的质量。

compare-mt(“compare my text”)是一个比较多个系统生成的句子的程序,比如机器翻译、摘要、对话框响应生成等。要使用它,你需要一个ground-truth和两个不同系统的输出。基于此,compare-mt将运行一些分析,试图找出系统之间的显著差异,这将使您更容易了解一个系统比另一个系统做得更好的地方。

【安装】

# 把git 库拉下来

git clone https://github.com/neulab/compare-mt

# 安装依赖

pip install -r requirements.txt

# 安装软件包

python setup.py install

【使用】

compare-mt example/ted.ref.eng example/ted.sys1.eng example/ted.sys2.eng

其中:

ted.ref.eng是ground-truth的结果

ted.sys1.eng是 system 1的结果

ted.sys2.eng是 system 2的结果

【分析结果】

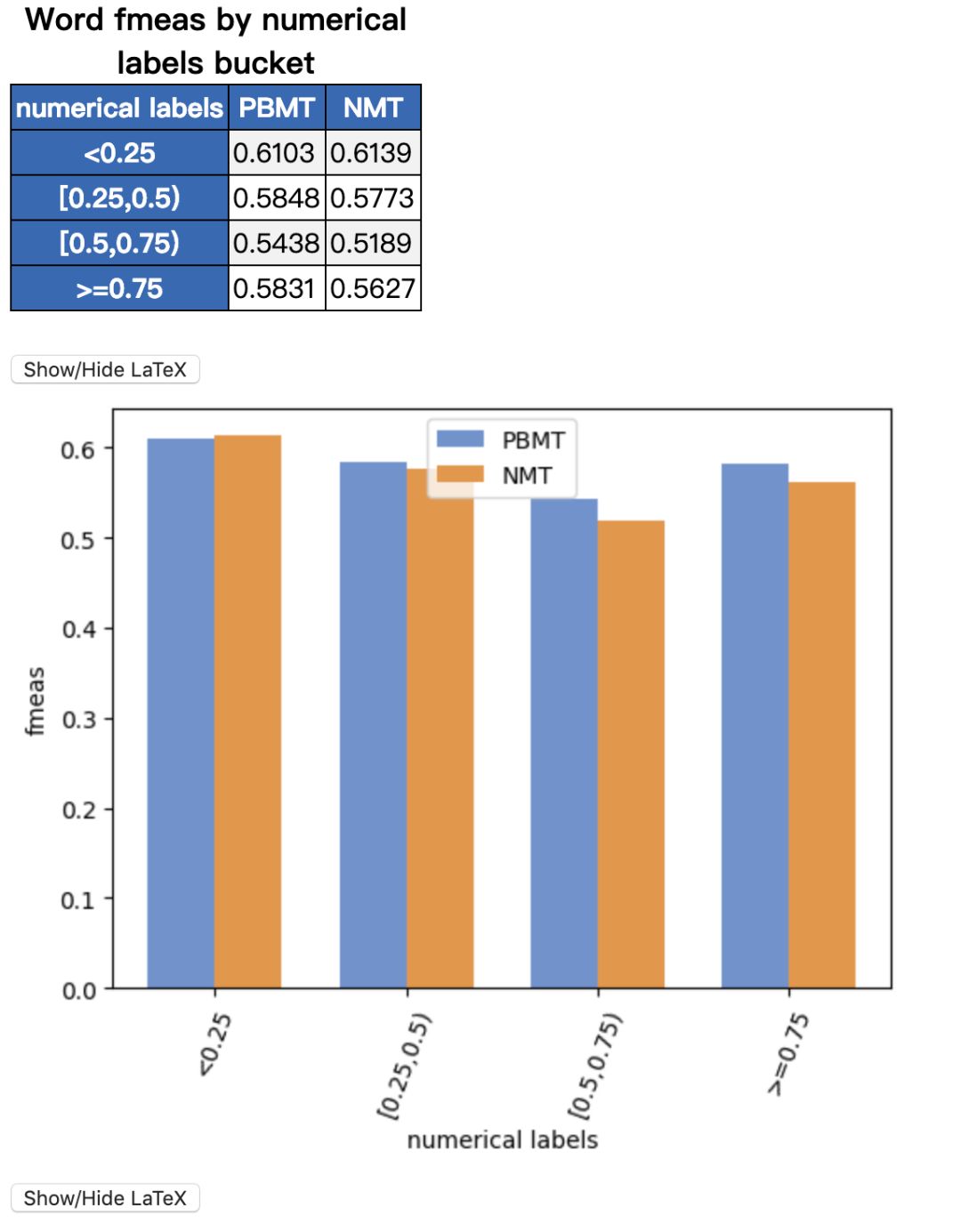

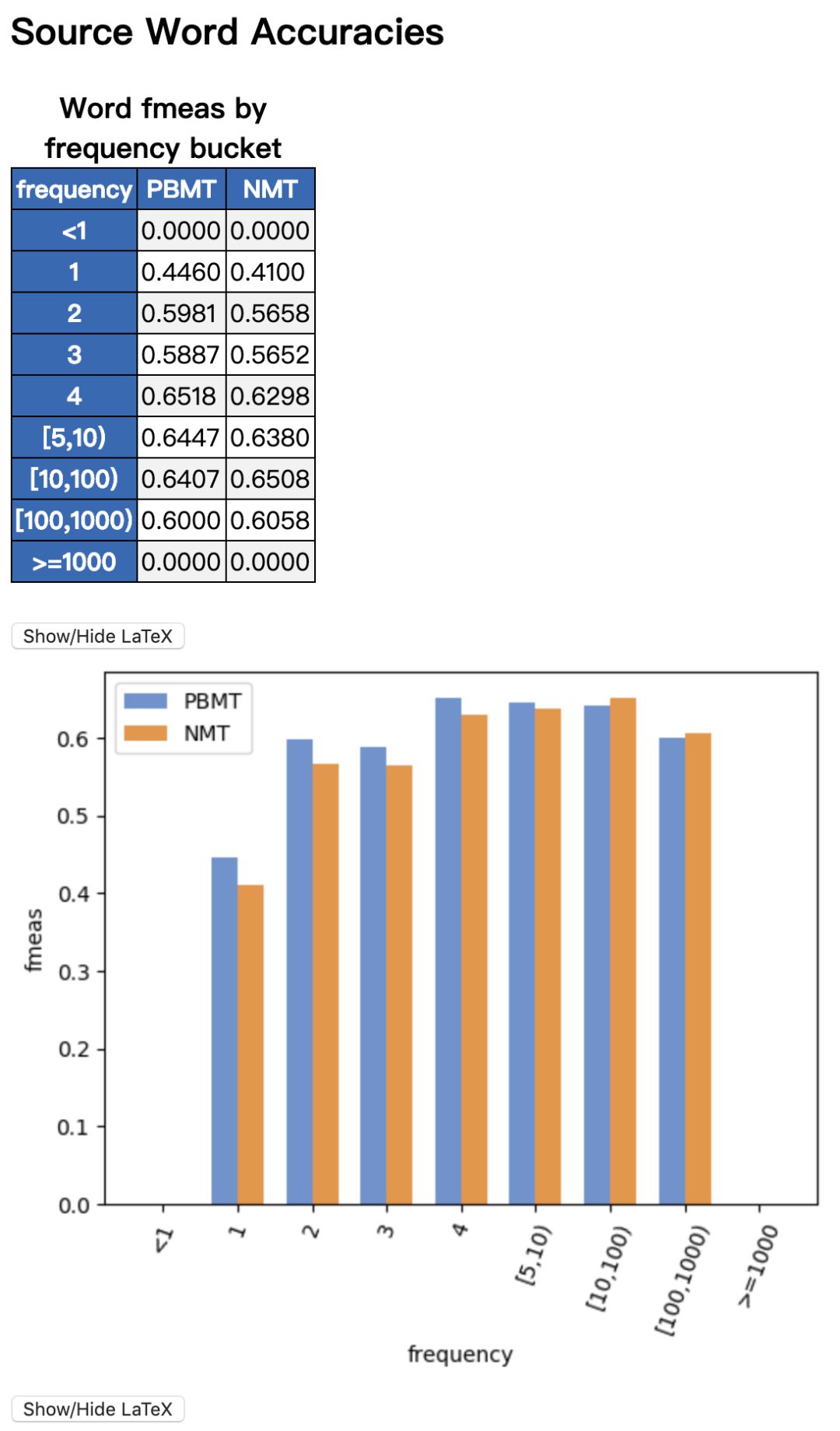

默认配置的分析器,会对上述句子,进行如下分析:

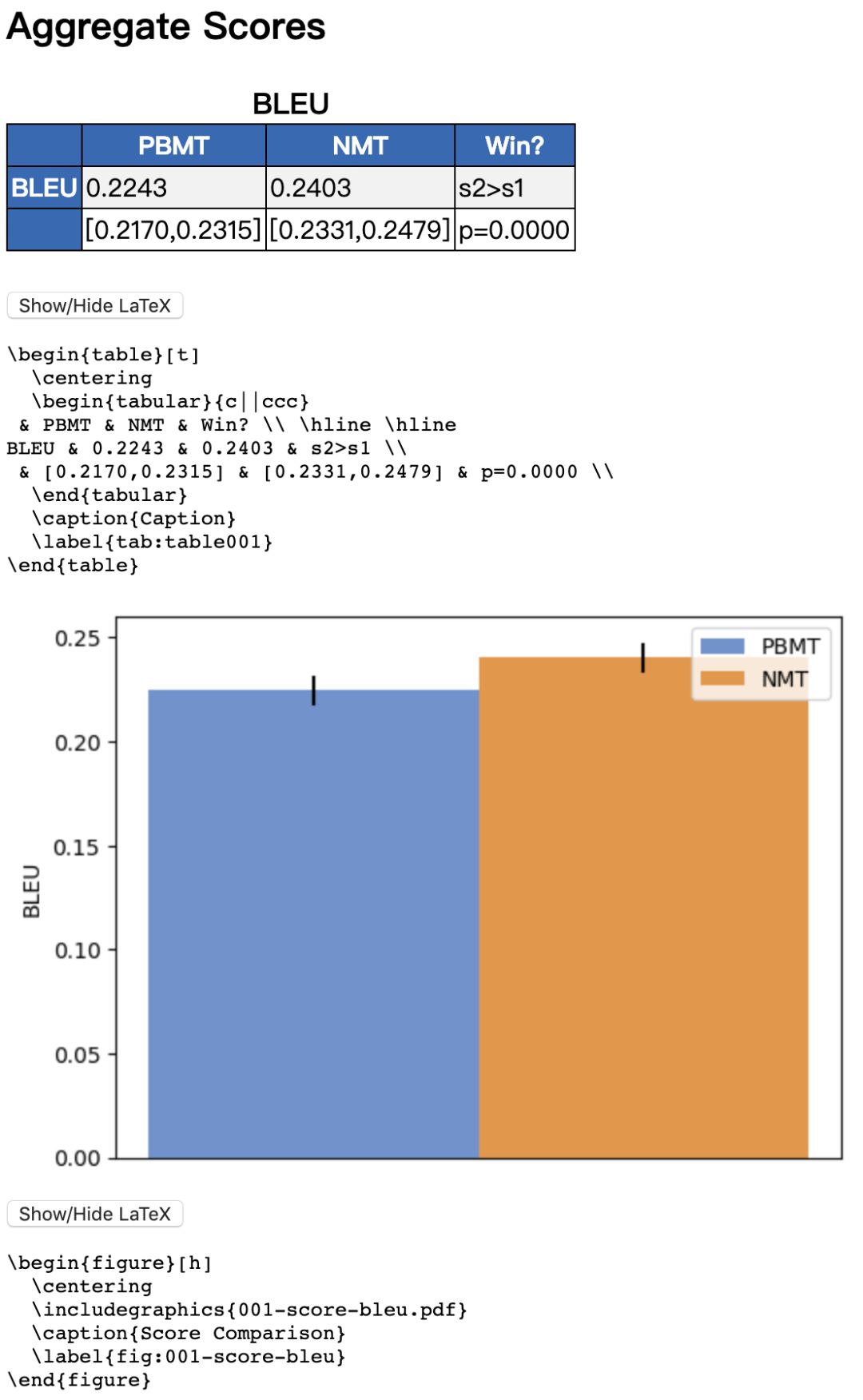

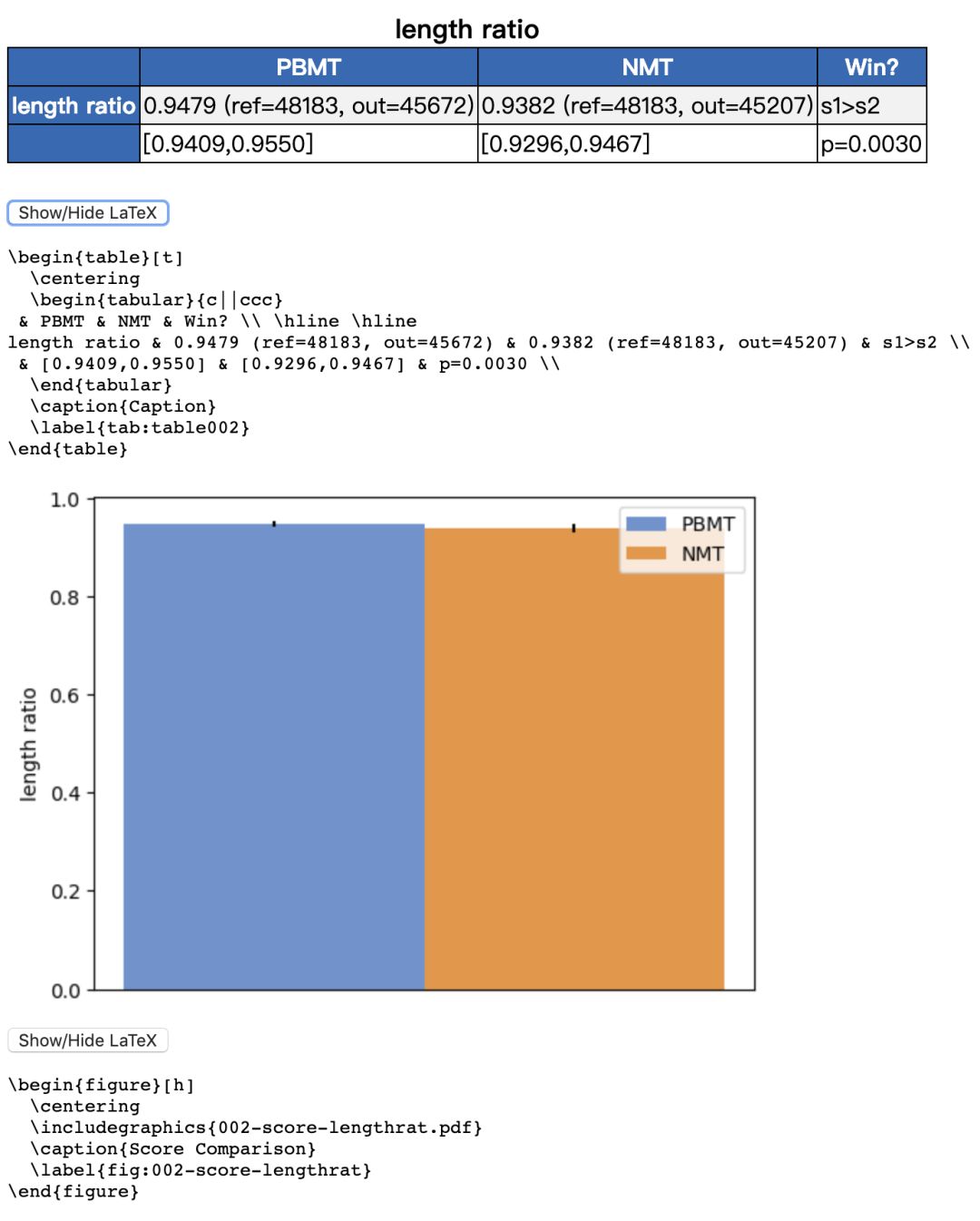

Aggregate Scores:

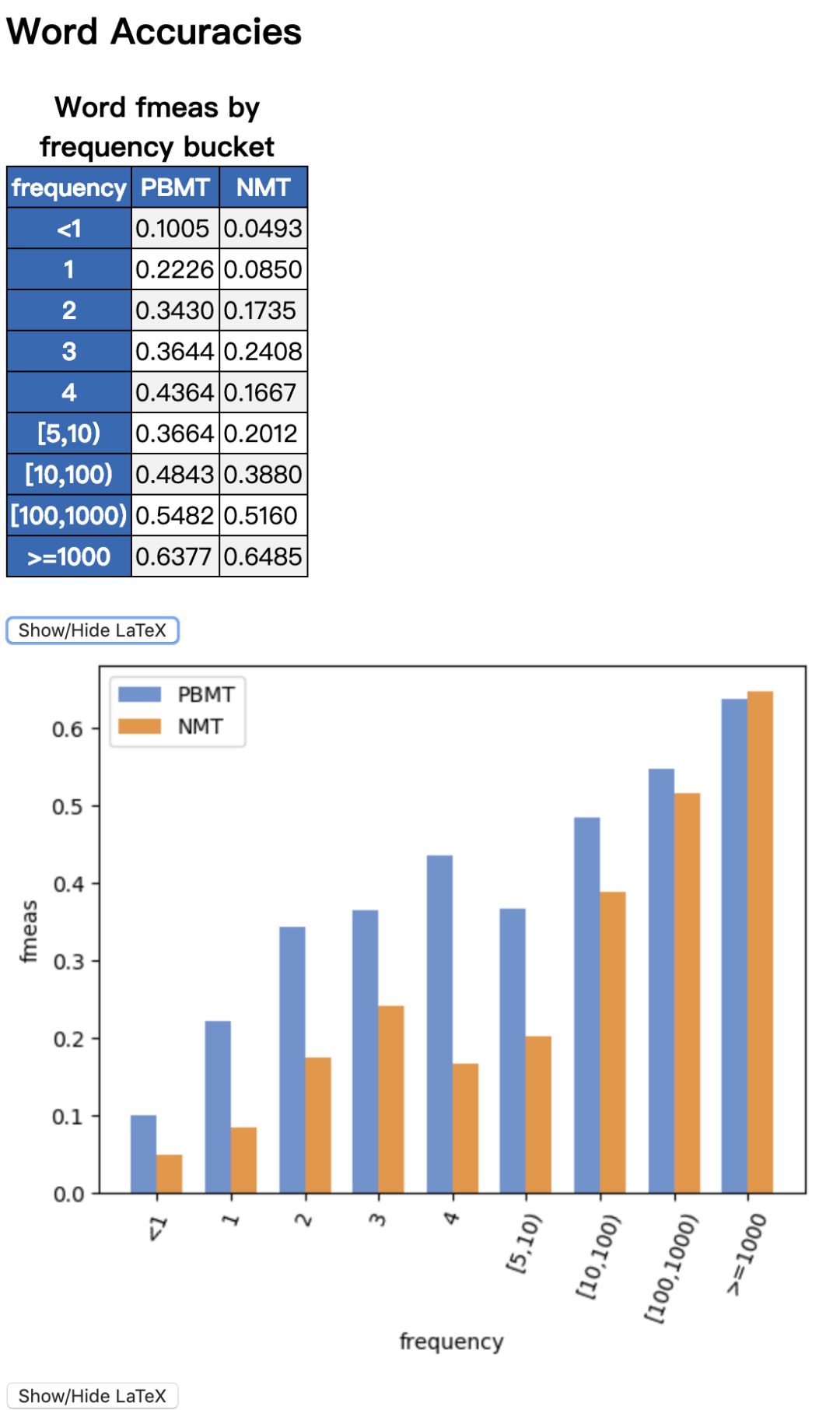

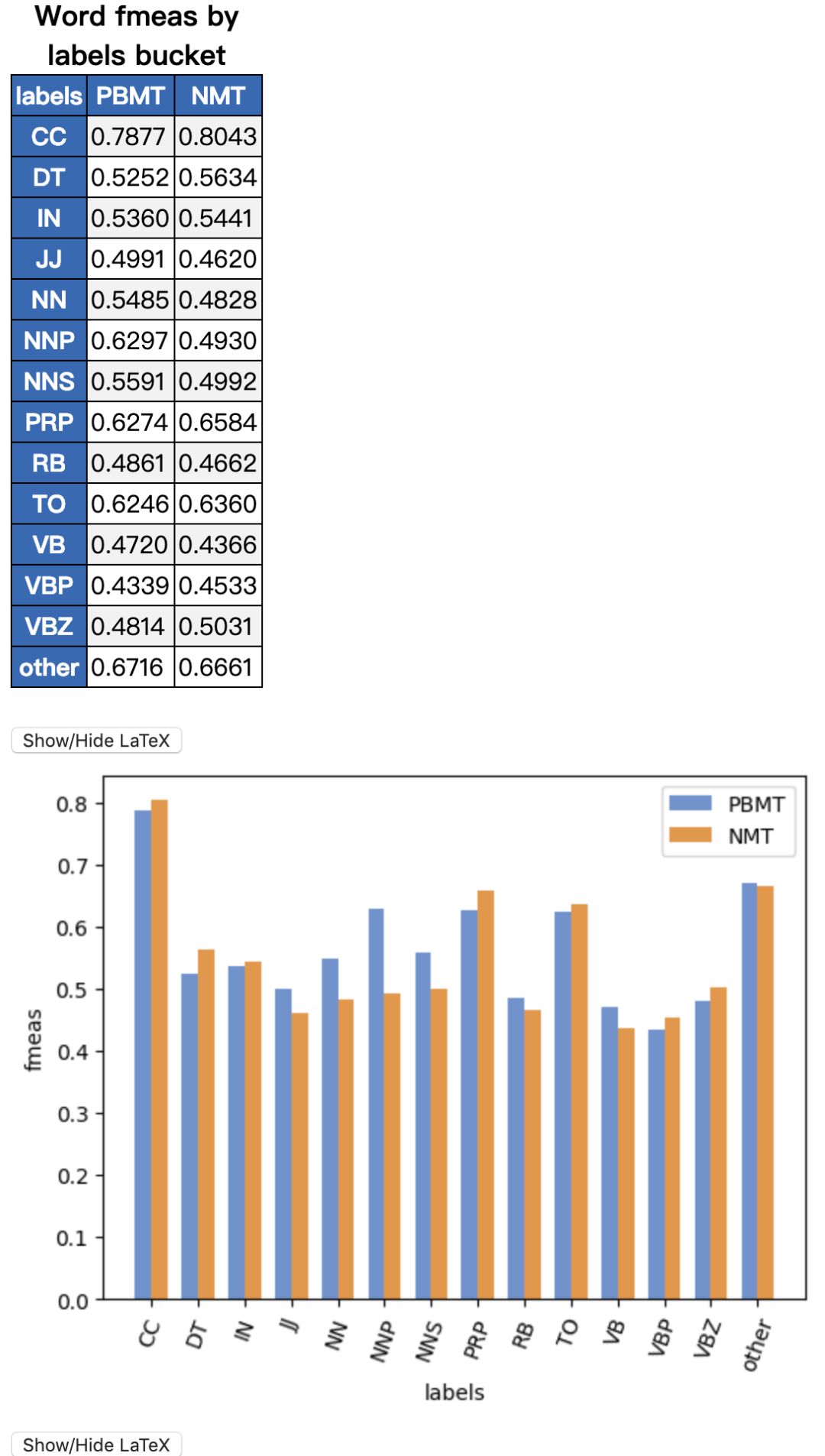

Word Accuracy Analysis

Sentence Bucket Analysis

N-gram Difference Analysis

Sentence Examples

每一项,都会自动生成图表,并配以Latex的表格源码,简直不能更贴心。

更多信息,请访问该库的github地址:

https://github.com/neulab/compare-mt

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!480+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程