面向自然语言处理的神经网络迁移学习,NLP网红Ruder博士329页论文(附下载)

【导读】Sebastian Ruder 最近从爱尔兰国立大学博士毕业,NLP知名博主ruder.io,毕业后加入DeepMind成为研究科学家。今天他的博士论文《面向自然语言处理的神经网络迁移学习》公开,总共329页,详细探讨了当前自然语言处理(NLP)中最为突出的四个领域:领域适应、多任务学习、跨语言学习和序列迁移学习,是了解NLP迁移学习非常好的文献。

http://ruder.io/thesis/

面向自然语言处理的神经网络迁移学习

论文摘要:

当前的基于神经网络的自然语言处理模型擅长于从大量标记数据中学习。基于这些功能,自然语言处理越来越多地应用于新任务、新领域和新语言。然而,目前的模型对噪声和对抗性样例很敏感,容易过度拟合。这种脆弱性,加上注意力的成本,成为监督学习范式的挑战。

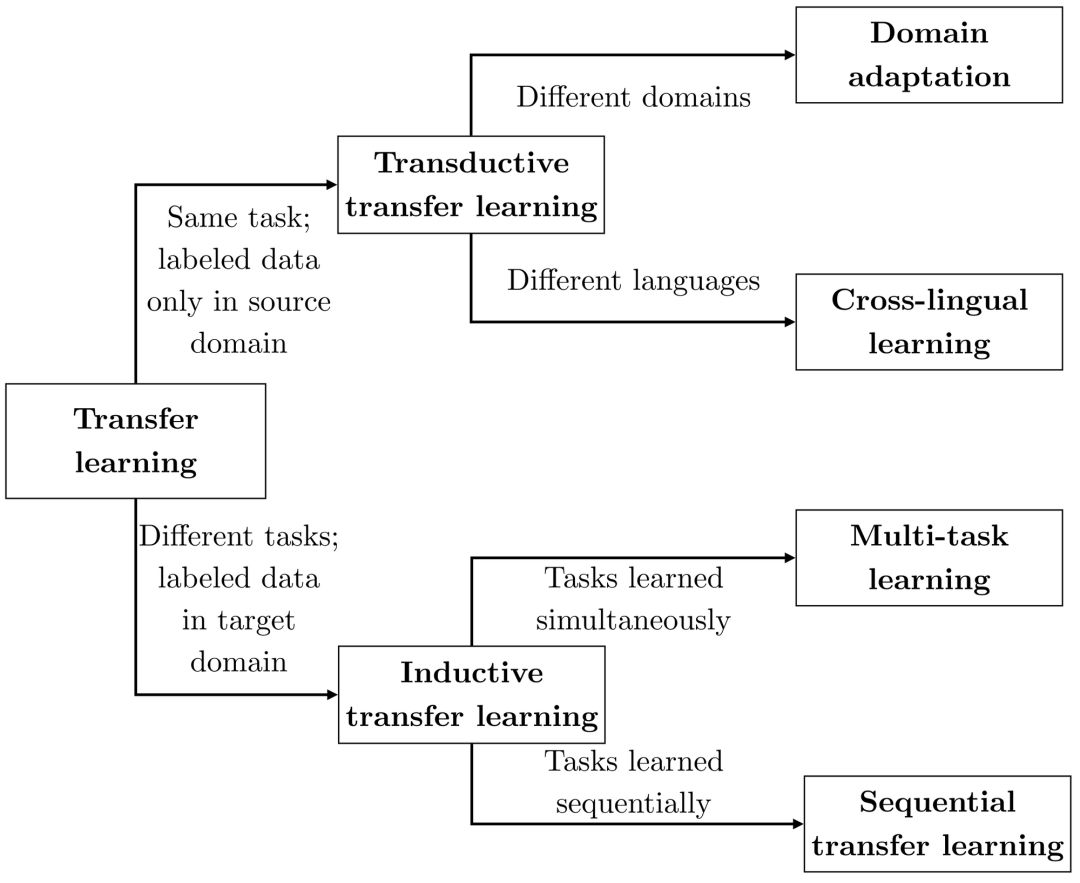

迁移学习允许我们利用从相关数据中获得的知识来提高目标任务的性能。在自然语言处理过程中,以预训练的词表示形式进行的内隐迁移学习是一个常见的组成部分。在这篇论文中,我们认为更显式的迁移学习是解决训练数据缺乏和提高自然语言处理模型下游任务性能的关键。我们展示了从支持这一假设的相关领域、任务和语言转移知识的实验结果。

我们在自然语言处理的迁移学习方面做出了一些贡献: 首先,我们提出了自动选择相关数据进行监督和非监督域适应的新方法。其次,我们提出了两种新的体系结构,以改善多任务学习的共享,并优于单任务学习和最先进的。第三,分析了当前无监督跨语言迁移模型的局限性,提出了一种克服模型局限性的方法,并提出了一种新的隐变量跨语言词嵌入模型。最后,我们提出了一个基于微调语言模型的顺序迁移学习框架,并分析了适应阶段。

论文结构:

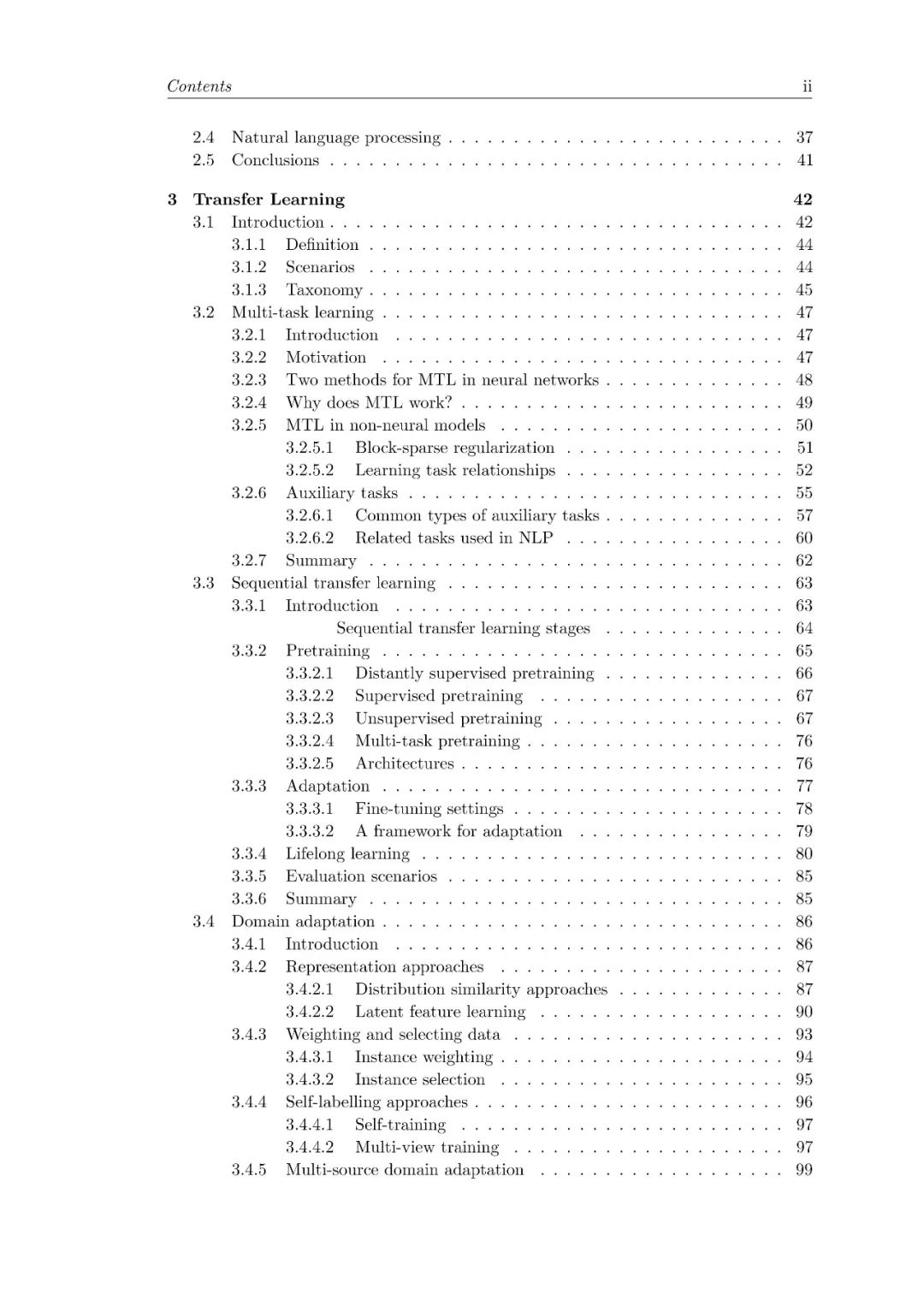

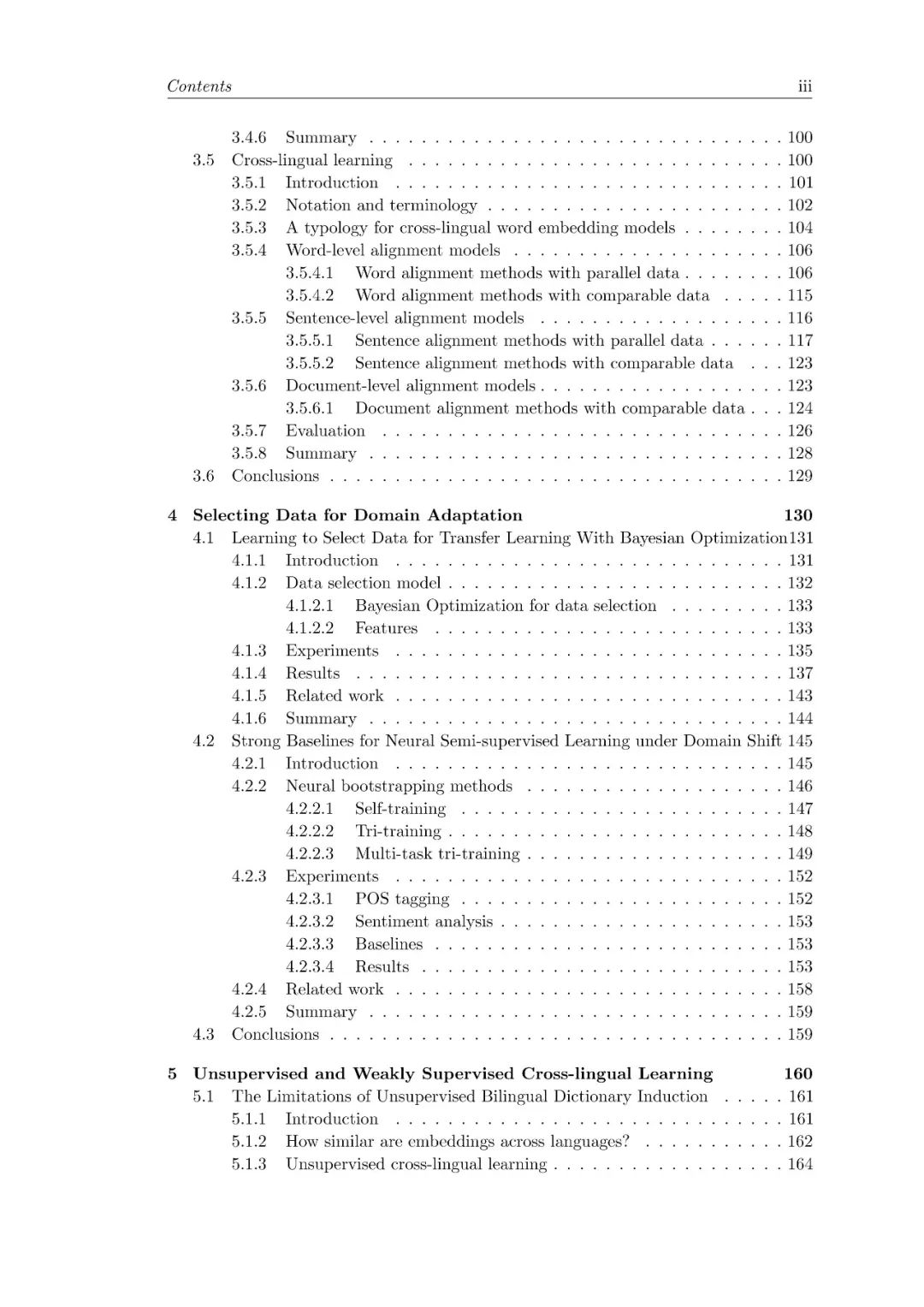

包含 领域适应、多任务学习、跨语言学习和序列迁移学习

背景章节(§2),列出概率论、信息论、机器学习、神经网络和NLP等关键概念,并将这些概念与后续章节的使用联系起来;

一种NLP的迁移学习分类(§3.1.3,见下文),它使Pan和Yang(2010)的分类适应于NLP中的当代设置;

多任务学习的最新回顾(§3.2),讨论多任务学习的最新进展和选择;

序列迁移学习和领域适应的回顾(§3.3和§3.4),确定每个研究领域的共同主题;

论文slides:

Ruder博士答辩41页PPT,面向自然语言处理的神经网络迁移学习

论文下载:

请关注专知公众号(点击上方蓝色专知关注)

后台回复“TL4NLP” 就可以获取Sebastian Ruder博士论文《Neural Transfer Learning for Natural Language Processing》的下载链接~

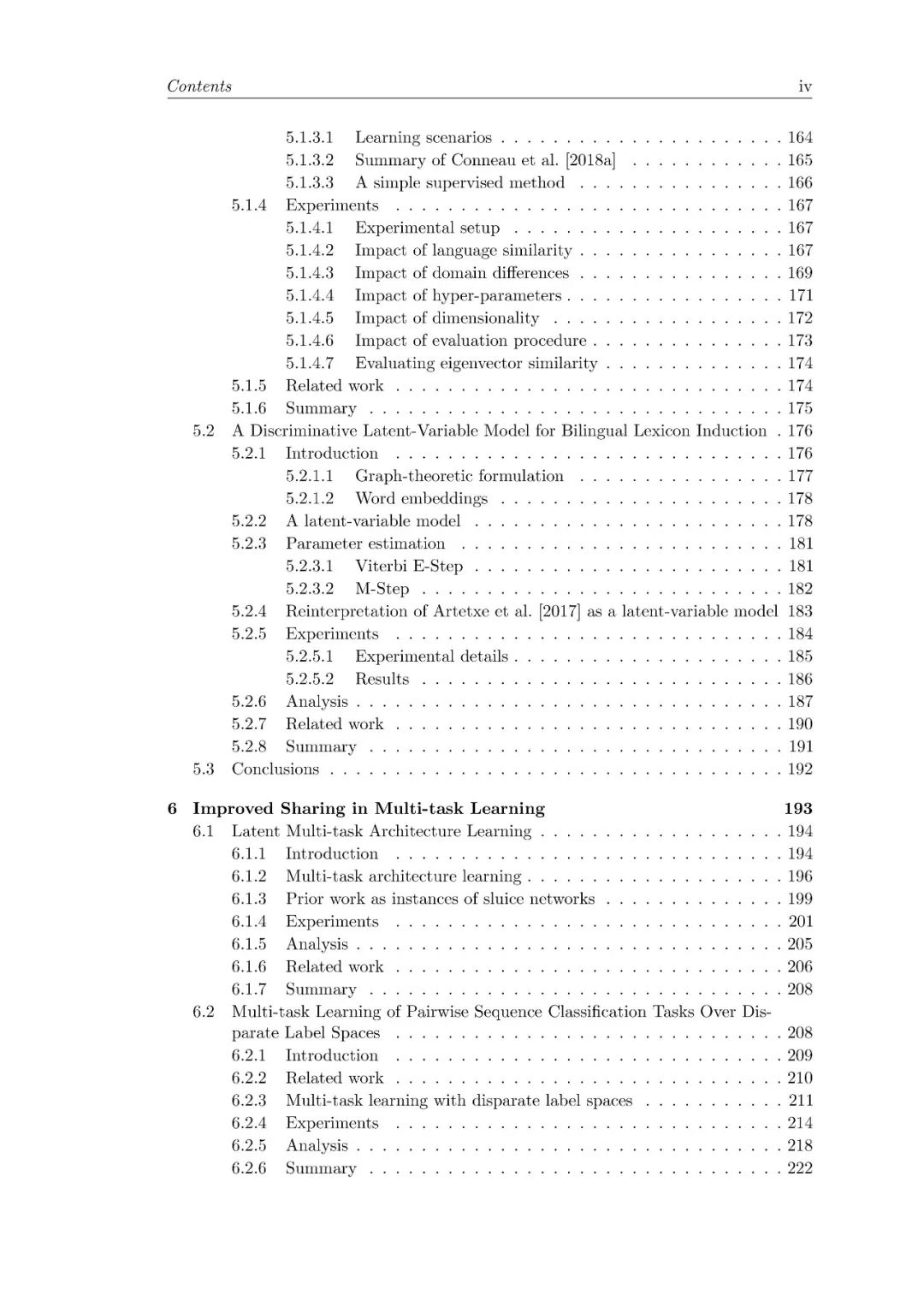

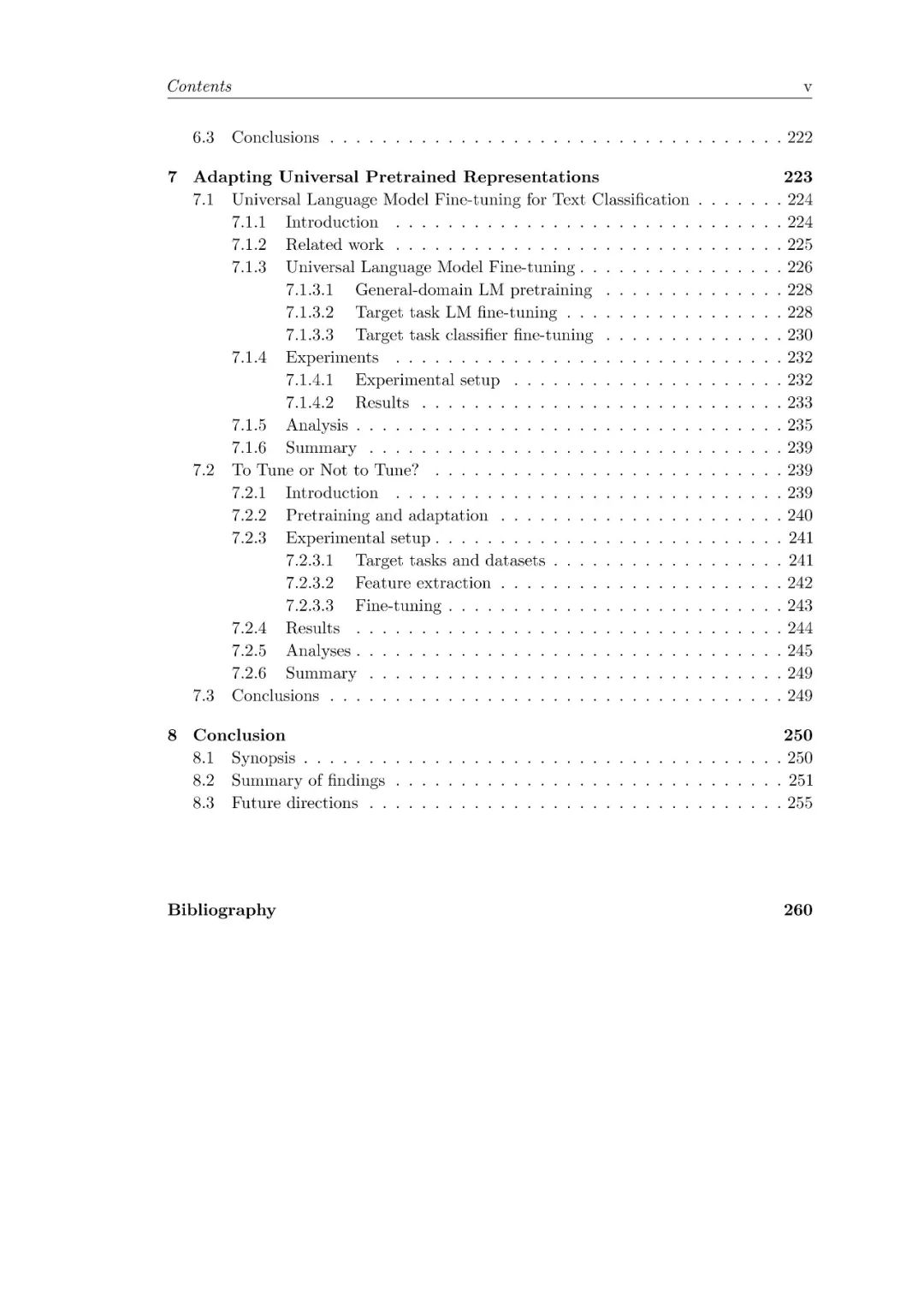

论文目录:

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!510+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询《深度学习:算法到实战》课程,咨询技术商务合作~

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程