最近必读的六篇【Meta-Learning(元学习)】相关论文和代码

【导读】Meta-Learning(元学习)是当下研究热点,结合最新的热点方法,在应用到自己的领域,已经是大部分研究者快速出成果的一个必备方式。元学习旨在通过一些训练少量样本可以学习新技能或快速适应新环境的模型!今天小编专门整理最新八篇Meta-Learning(元学习)包括NeuralPS、CIKM、EMNLP、WSDM2020等顶会论文,涵盖图元学习、隐式梯度元学习等。

近期必读的八篇【Meta-Learning(元学习)】相关论文和代码

请关注专知公众号(点击上方蓝色专知关注)

后台回复“元学习论文” 就可以获取所有元学习论文下载链接~

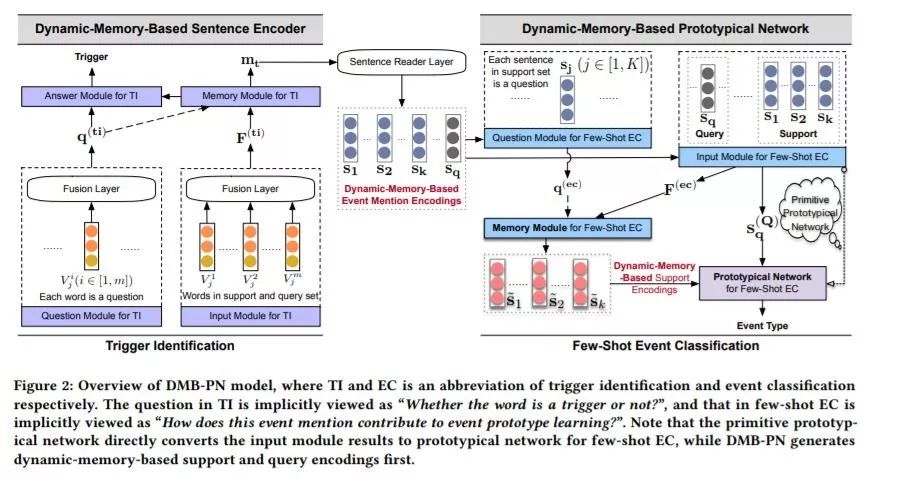

1、Meta-Learning with Dynamic-Memory-Based Prototypical Network for Few-Shot Event Detection(元学习与动态记忆为基础的原型网络的小样本突发事件检测)

WSDM ’20 ,浙江大学,阿里巴巴

作者:Shumin Deng, Ningyu Zhang, Jiaojian Kang, Yichi Zhang, Wei Zhang, Huajun Chen

摘要:事件检测(Event detection, ED)是事件抽取的一个子任务,包括识别触发器和对事件提及进行分类。现有的方法主要依赖于监督学习,并且需要大规模的带标记的事件数据集,不幸的是,这些数据集在许多实际的应用场景中并不容易获得。在本文中,我们将在有限标记数据条件下的ED任务考虑为一个小概率学习问题。提出了一种基于动态记忆的原型网络(DMB-PN),该网络利用动态记忆网络(DMN)不仅能更好地学习事件类型的原型,而且能对事件提及产生更健壮的句子编码。与传统的通过平均计算事件原型的网络不同,我们的模型更健壮,并且由于DMNs的多跳机制,能够多次从事件提及中提取上下文信息。实验结果表明,DMB-PN不仅比一系列基线模型更能有效地处理样本稀缺问题,而且在事件类型变化较大、实例数量极少时表现得更为稳健。

网址:

https://www.zhuanzhi.ai/paper/55e991cc9627d73058c1f74155858216

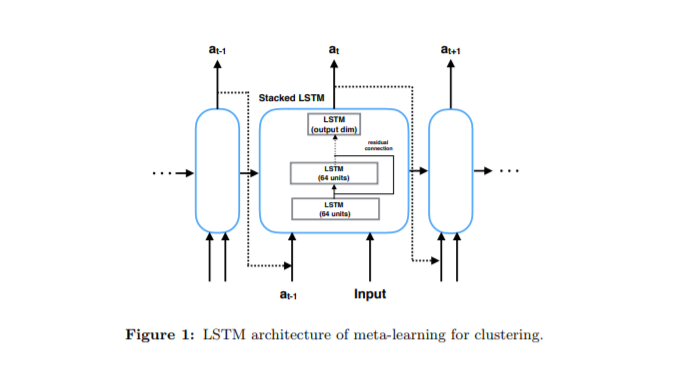

2、Meta-Learning to Cluster(元学习聚类)

哥伦比亚大学

作者:Yibo Jiang, Nakul Verma

摘要:聚类是探索性数据分析中最基本、最广泛应用的技术之一。然而,聚类的基本方法并没有真正改变:专业人员手工挑选特定于任务的聚类损失,以优化并适合给定的数据,以揭示底层聚类结构。某些类型的损失——例如k-means或其非线性版本:kernelized k-means(基于质心的)和DBSCAN(基于密度的)——由于它们在一系列应用中具有良好的经验性能,因此很受欢迎。尽管使用这些标准损失的聚类输出常常不能揭示底层结构,而且执行者必须自定义设计它们自己的变体。在这项工作中,我们采用了一种本质上不同的聚类方法:我们不是根据特定的聚类损失来拟合数据集,而是训练一个学习如何聚类的递归模型。该模型使用数据集的示例(作为输入)和相应的聚类标识(作为输出)作为训练对。通过提供多种类型的训练数据集作为输入,我们的模型能够很好地泛化不可见的数据集(新的集群任务)。实验表明,与标准的基准聚类技术相比,在简单的综合生成数据集或现有的真实数据集上进行训练,可以获得更好的聚类性能。我们的元聚类模型即使对于通常的深度学习模型表现较差的小数据集也能很好地工作。

网址:

https://www.zhuanzhi.ai/paper/383823947526bc3a25d9bdd67339a3d8

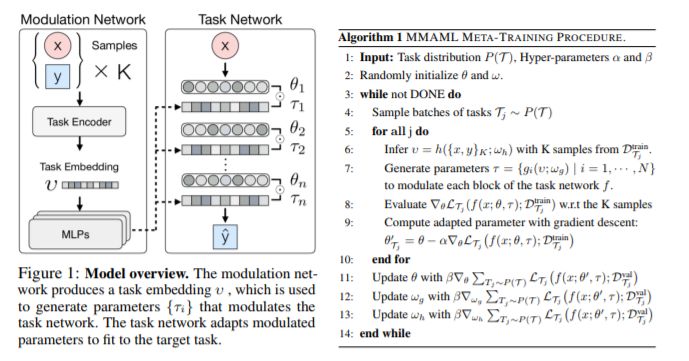

3、Multimodal Model-Agnostic Meta-Learning via Task-Aware Modulation(多模态模型无关元学习)

NeuralPS‘19,南加州大学

作者:Risto Vuorio, Shao-Hua Sun, Hexiang Hu, Joseph J. Lim

摘要:模型无关元学习的目标是从相似的任务中获取元学习参数,以适应分布相同但梯度更新较少的新任务。由于模型选择的灵活性,这些框架在诸如小样本图像分类和增强学习等多个领域表现出了良好的性能。然而,此类框架的一个重要限制是,它们寻求在整个任务分布中共享的公共初始化,这极大地限制了它们能够学习的任务分布的多样性。在本文中,我们增强了MAML的能力,以识别从多模式任务分布中采样的任务模式,并通过梯度更新快速适应。具体来说,我们提出了一个多模态MAML (MMAML)框架,该框架能够根据所识别的模式调整其元学习先验参数,从而实现更高效的快速适应。我们在一组不同的小样本学习任务上对所提出的模型进行评估,包括回归、图像分类和强化学习。结果不仅证明了我们的模型在调整元学习先验以响应任务特征方面的有效性,而且表明了多模态分布的训练比单模态训练有更好的效果。

网址:

https://www.zhuanzhi.ai/paper/b313367453f43f42d588572caaa4d362

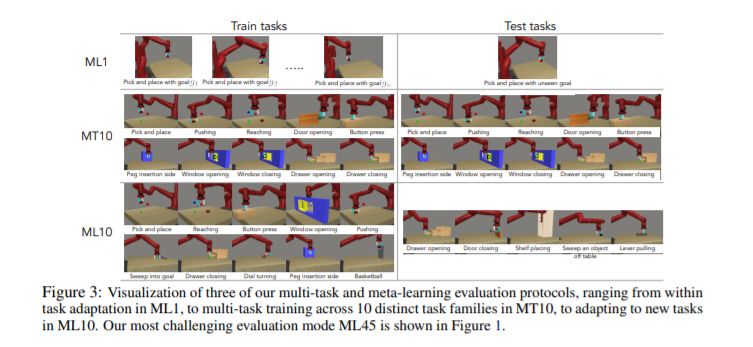

4、Meta-World: A Benchmark and Evaluation for Multi-Task and Meta Reinforcement Learning(元世界:多任务和元强化学习的基准和评估)

CoRL‘19,伯克利分校,Google

作者:Tianhe Yu, Deirdre Quillen, Zhanpeng He, Ryan Julian, Karol Hausman, Chelsea Finn, Sergey Levine

摘要:元强化学习算法可以利用以前的经验来学习如何学习,从而使机器人更快地获得新技能。然而,目前关于元强化学习的研究大多集中在任务分布非常狭窄的情况下。例如,一个常用的元强化学习基准对一个模拟机器人使用不同的运行速度作为不同的任务。当策略在如此狭窄的任务分布上进行元训练时,它们不可能泛化到更快速地获取全新的任务。因此,如果这些方法的目的是更快地获取全新的行为,那么我们必须在任务分布上对它们进行评估,这些任务分布足够广泛,从而能够对新行为进行泛化。在本文中,我们提出了一种元强化学习和多任务学习的开源模拟基准,由50个不同的机器人操作任务组成。我们的目标是使开发算法成为可能,从而加速获取全新的、未完成的任务。我们评估了6种最先进的元强化学习和多任务学习算法。令人惊讶的是,虽然每个任务及其变体(例如,具有不同的对象位置)都可以成功地学习,但这些算法很难同时学习多个任务,即使只有10个不同的训练任务。我们的分析和开源环境为未来多任务学习和元学习的研究铺平了道路,这些研究可以使有意义的概括成为可能,从而释放这些方法的全部潜力。

网址:

https://www.zhuanzhi.ai/paper/21dc1304e5c17132cd68a3faf41e9052

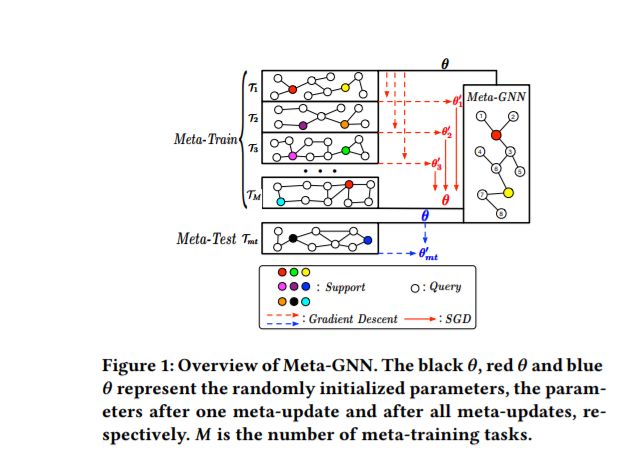

5、Meta-GNN: On Few-shot Node Classification in Graph Meta-learning(图元学习少样本节点分类)

CIKM‘19,电子科技大学

作者:Fan Zhou, Chengtai Cao, Kunpeng Zhang, Goce Trajcevski, Ting Zhong, Ji Geng

摘要:元学习作为一种模仿人类智能的可能方法,近来受到了极大的关注,即,学习新的知识和技能。现有的元学习方法多用于解决图像、文本等少数样本的学习问题,在欧几里得域比较常见。然而,将元学习应用于非欧几里得域的研究工作非常少,最近提出的图神经网络(GNNs)模型在处理图少样本学习问题时表现不佳。为此,我们提出了一种新的图元学习框架——元GNN,以解决图元学习环境中节点分类问题。该算法通过对多个相似的少样本学习任务进行训练,获得分类器的先验知识,然后利用标记样本数量较少的新类对节点进行分类。此外,Meta-GNN是一个通用模型,可以直接纳入任何现有的最先进的GNN。我们在三个基准数据集上的实验表明,我们的方法不仅在元学习范式中大大提高了节点分类性能,而且为任务适应提供了一个更通用、更灵活的模型。

网址:

https://www.zhuanzhi.ai/paper/21dc1304e5c17132cd68a3faf41e9052

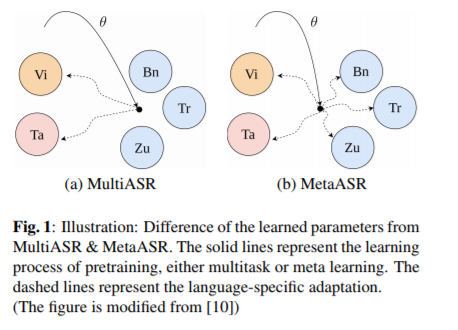

6、Meta Learning for End-to-End Low-Resource Speech Recognition(元学习低资源语音识别)

ICASSP‘2020提交论文,国立台湾大学

作者:Jui-Yang Hsu, Yuan-Jui Chen, Hung-yi Lee

摘要:在本文中,我们提出将元学习方法应用于低资源的自动语音识别(ASR)。我们将不同语言的ASR表示为不同的任务,并通过最近提出的模型无关元学习算法(MAML),从许多预训练语言中学习初始化参数,以实现对未知目标语言的快速适应。我们以六种语言为训练前任务,四种语言为目标任务,对提出的方法进行了评估。初步结果表明,MetaASR方法在训练前不同语言组合的所有目标语言上显著优于目前最先进的多任务训练前方法。此外,由于MAML的模型无关性,本文也为元学习在更多语音相关应用中的应用开辟了新的研究方向。

网址:

https://www.zhuanzhi.ai/paper/6d57ba6566347fccbd0ba52cb423c6e4

更多“元学习”论文请上专知网站(www.zhuanzhi.ai )进行查看!成为VIP,查看更多干货!

https://www.zhuanzhi.ai/topic/2001324265251387/paper