深度学习“反唱者”Gary Marcus新出力作:AI下个十年,向‘强’人工智能迈进的四步骤(附59页论文下载)

【导读】深度学习“反唱者”Gary Marcus 一直“”杠怼”深度学习。前一久刚和Bengio论战- 【大佬约架】Yoshua Bengio与Gary Marcus之圣诞AI论战「 AI 之道」。 最近Gary Marcus新出一篇论文《The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence》,提出一系列思想如何构建Robust AI。 最近在人工智能和机器学习方面的研究开始越来越多的强调通用学习以及越来越大的训练集和越来越多的计算。相比之下,作者提出了一种混合的、知识驱动的、基于推理的方法,该方法以认知模型为核心。与目前的方法相比,作者提出的模型可以为人工智能提供更丰富、更健壮的基础。

原文链接:

https://arxiv.org/abs/2002.06177

1. 朝着‘强‘’人工智能前进

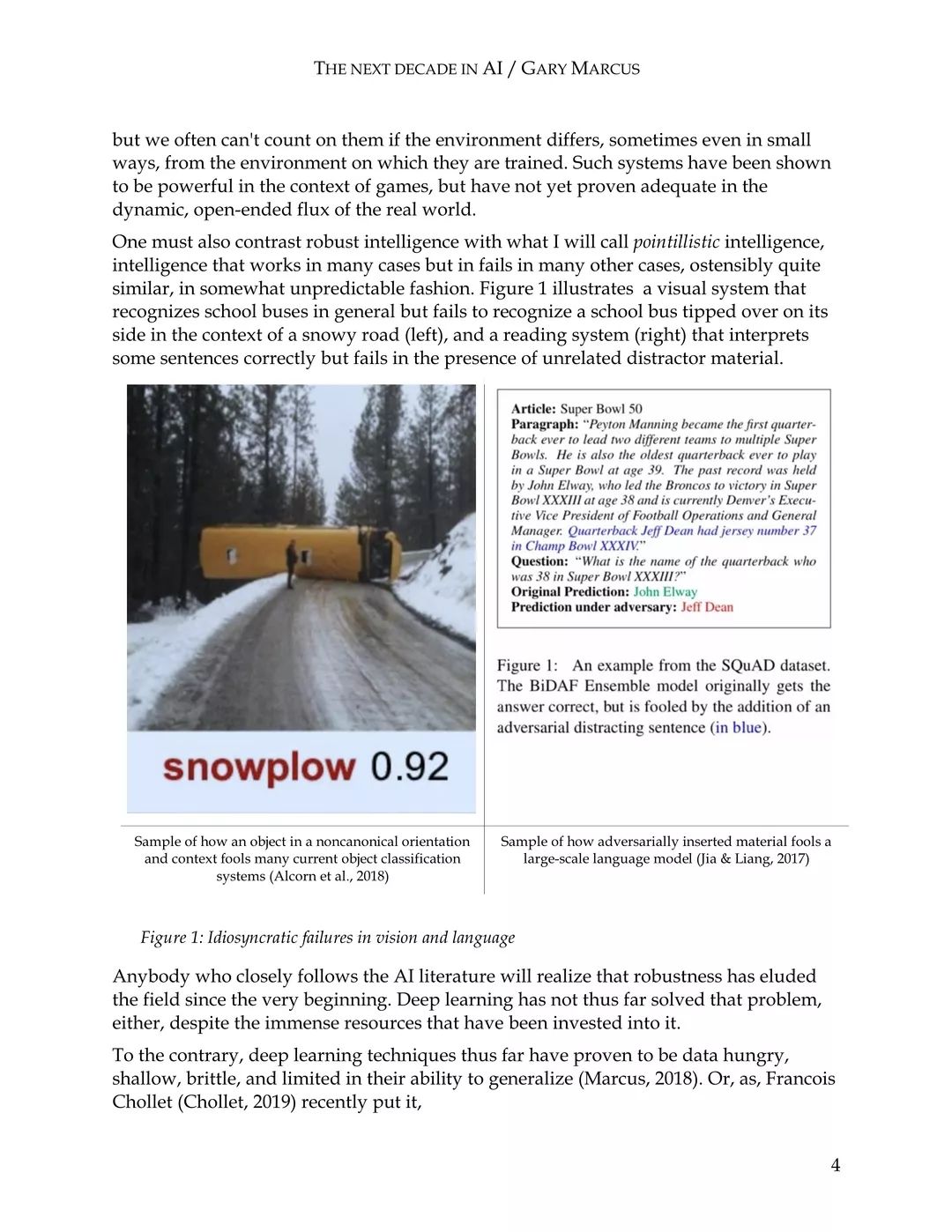

虽然没有人确切地知道在未来的几十年里,深度学习或人工智能将会发展成什么样子,但如果我们要达到一个新的水平,有必要考虑一下我们从过去十年中学到了什么,以及接下来应该研究什么。

让我们暂且称呼这种新级别的人工智能为‘强’人工智能:智能,尽管不一定是具有超人一样的能力或者能够自我提高的能力,但是我们可以指望这种级别的智能能够以一种系统和可靠的方式把它所知道的应用到广泛的问题上,综合各种来源的知识,能够灵活和动态地对世界进行推理。把它在一种环境中所学习到的东西迁移到另一种环境中,就像我们期望一个普通成年人能够举一反三一样。

2. 一种混合的,知识驱动的,基于认知模型的方法

许多认知科学家,包括我自己,都把认知视为一种循环:生物从外界获取感知信息,他们会基于他们所获取到的信息构建一个模型,然后根据这些认知模型作出决定。这其中可能会包括在外部世界中包含哪些种类的实体信息,他们的属性是什么,这些实体之间是如何关联到一起的。尽管认知科学家普遍将这些认知模型视为不完善或者不精确的模型,但是依旧把它们看作是生物体看待世界的核心。即使是不完美的,认知模型也可以作为一个强大的指南来认知世界。在很大程度上,一个有机体在世界上的繁荣程度取决于这些内部认知模型的好坏。

2.1 混合架构

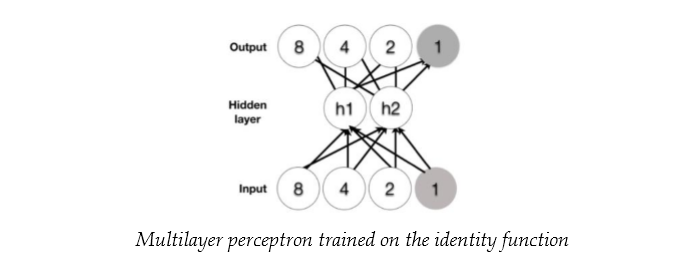

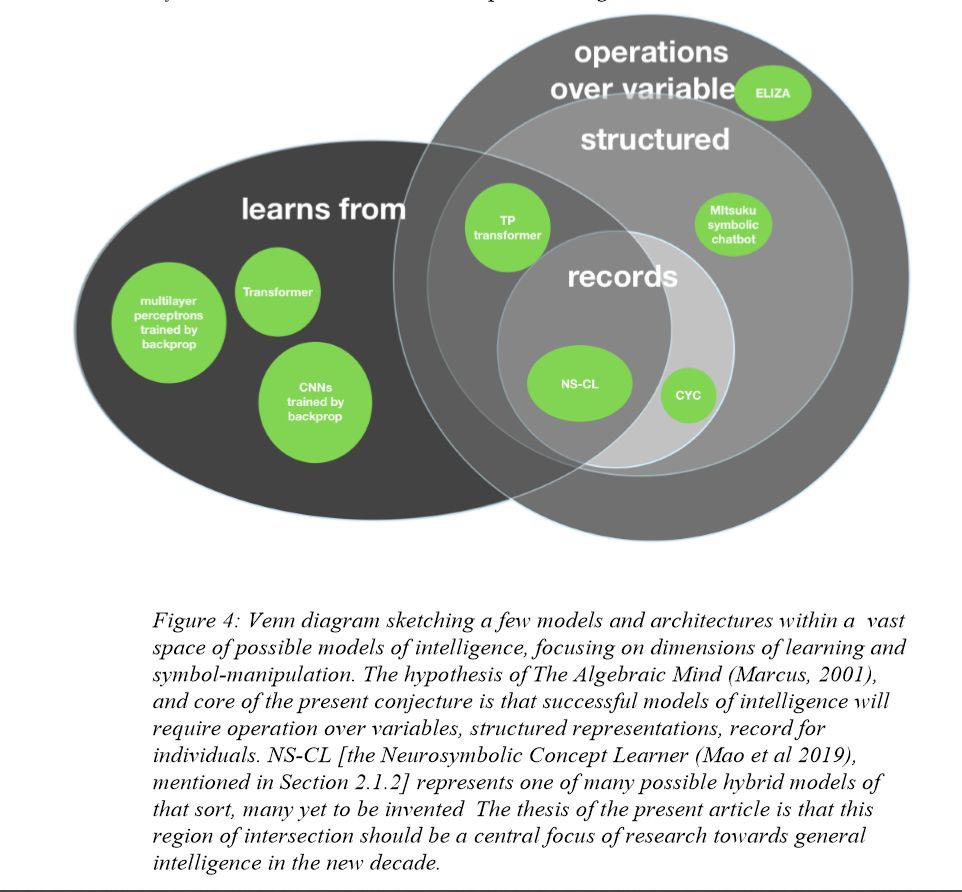

我们对变量符号的操作提供了一个潜在的答案——这一解决方案每天都要被使用数万亿次,几乎是全世界所有软件的基础。特别是,几乎每个计算机程序都有四个基本概念作为基础:变量、实例、将变量绑定到实例以及变量上的操作。而混合本身并不是什么新鲜事:Pinker和我三十年前就提出孩子们学习英语过去式的最好方法就是混合模式:规则(在动词干上加-ed),用于形成规则动词的过去式,以及类似神经网络的系统,用于获取和检索不规则动词。事实上,将符号知识和感性知识结合的需求由来已久(如人们希望通过把对马的外貌的感性认识与把斑马比作条纹马的口头定义结合起来识别斑马)。而计算机科学家在90年代就开始提倡混合模型,并且已经证明了将有限的逻辑子集转化为神经网络是可能的。

2.2 大规模的数据当中有些是抽象的,具有因果关系的

我们可以操作符号对抽象知识进行表示,但如何积累和表示抽象知识到目前为止依旧是一项艰苦的工作,所取得的成绩远远不能令人满意。另外目前的大型数据库如谷歌知识图谱、Freebase和YAGO主要关注事实而不是常识,这导致我们不能很好的理解和使用这些抽象的知识数据。

2.3 推理

推理提供了另外一种选择;你不需要记住所有的东西,也不需要在你之前可能遇到过的近邻之间进行插值,你只需要进行推理。而不是强行记住一些东西。你需要学习一个普遍的真理:所有人类都是终有一死的,并根据需要将这一普遍真理应用于这一范畴内的所有具体实例。正如我们所看到的那样,诸如Transformers这样的神经网络也不能作出值得信赖的推理。它们有时可能奏效,但效果不佳;但是好在只要有足够的知识,他们至少提供了朝着正确方向前进的希望。

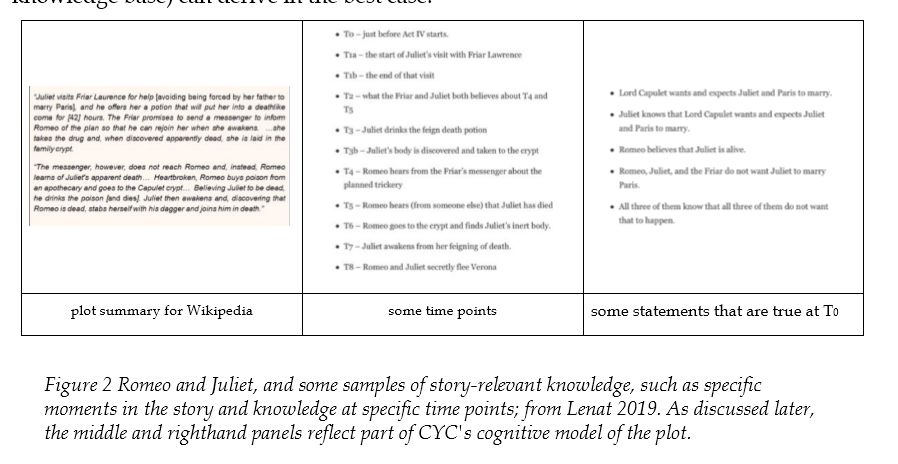

2.4 认知模型

特殊类型的知识是随着时间的推移积累起来的关于事物特定状态的知识,诸如在一次交谈之中我们会对朋友有所了解,阅读新闻时会对国家的某些事物有所了解。在认知心理学中,我们把这种累积表征称为认知模型。总的来说,认知模型大体上有一些实体知识(故事中的人物和他们拥有的物品),一些属性和一些时间,事件信息(人物x在时间t会见了人物y,在时间t,人物x了解到了什么信息)组成。

3. 讨论

3.1 把持久的知识作为基础的智能

没有我们,或者像我们这样的其他生物,世界将继续存在,但它不会被描述、提炼或理解。鸟儿可能会拍打翅膀,鸟儿可能会飞翔。事物之间也许会有关联,但没有因果描述。人类的生活将充满抽象和因果。我们的孩子会花大量时间问为什么;科学家提出这些问题是为了得出理论。我们力量的一个重要部分来自于我们以科学、文化和技术的形式去努力理解和描述这个世界。这些努力大多以知识的形式表现出来,有些是具体的,有些是笼统的,有些是口头的,有些是写于纸面的。经典人工智能的主要目标是将这些知识提炼成机器可解释的形式。

3.2 逐步窥探事物全貌

深度学习向我们展示了从大量数据中可以学到多少有用的东西。同现统计和类似的统计可能只是可靠知识的影子,但肯定有很多类似影子,也许我们可以利用这些影子。只要我们敏锐地意识到它们的长处和局限性就可以掌握更加复杂的技术。

3.3 结论,展望和启示

我提出了一个四步走方案:首先完善神经-符号混合架构,然后是建立丰富的、具有认知能力的框架和大规模的知识数据库,随后进一步开发能够用在此类框架上进行抽象推理的工具,最后,发展更复杂的认知模型和归纳机制。综上所述,这四个先决条件的进展可以为更丰富、更智能的系统提供基础。我认为这将重新定义我们学习的意义,产生一种(也许是新的)学习方式,通过抽象的、类似语言的归纳,从数据到知识和认知模型,将推理真正作为学习过程的一部分。

马库斯是谁?深度学习怀疑论者

Gary Marcus

加里 · 马库斯 (Gary Marcus) 是一位科学家、畅销书作家和企业家。他是 Robust.AI 公司的创始人和首席执行官,Geometric Intelligence 公司 (2016 年被优步收购) 的创始人兼首席执行官,出版著作包括《代数思维》、《怪诞脑科学 (Kluge)》、《思维的诞生》等,最新著作是与 Ernest Davis 合著的《Rebooting AI : 构建我们可以信任的人工智能》。

马库斯也是著名的深度学习怀疑论者。作为认知心理学家,他一直高调参与人工智能辩论,与 Yann LeCun、AAAI 前主席 Thomas Dietterich 等 AI 大牛都展开过激烈辩论。

他曾撰文批判深度学习 (Marcus, 2018), 称深度学习实际上并没解决什么问题。这篇文章引起了人工智能圈极大的反响,几天之内,成千上万的人在推特上发表了自己对这个问题的看法,有些人热情支持马库斯的论点(例如,“这是我多年来读到的有关深度学习和 AI 的最好的观点),有些相反(例如,“有思考...... 但大部分都是错误的”)。

在那篇批判深度学习的文章中,马库斯概括了深度学习的十大挑战,直言深度学习本身虽然有用,但它不可能实现通用人工智能。他建议把深度学习视为 “一种非普遍的解决方法,而只是一种工具。”

他说:“相比纯粹的深度学习,我呼吁混合模型,不仅包括深度学习的监督形式,还包括其他技术,例如符号处理(symbol-manipulation),以及无监督学习(它本身也可能被重新概念化)。我也敦促社区考虑将更多的内在结构纳入 AI 系统。”

部分论文展示:

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FRAI” 就可以获取《The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence》59页pdf论文专知下载链接