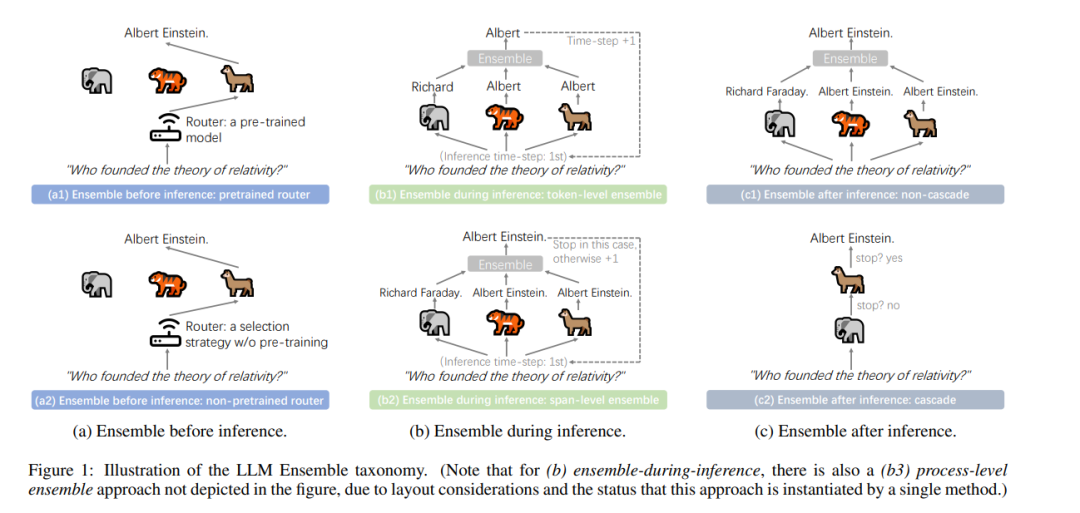

LLM集成——即全面利用多个大型语言模型(LLM),每个模型旨在处理下游推理中的用户查询,从而发挥其各自的优势——近年来已获得了广泛关注。大型语言模型的广泛可用性,以及它们各自的优势和开箱即用的特性,深刻推动了LLM集成领域的发展。本文首次系统性地回顾了LLM集成领域的最新进展。首先,我们介绍了LLM集成的分类法,并讨论了几个相关的研究问题。接着,我们根据‘推理前集成、推理中集成、推理后集成’的广泛分类,对各种方法进行了更深入的分类,并回顾了所有相关方法。最后,我们介绍了相关的基准测试和应用,总结了现有的研究成果,并提出了若干未来的研究方向。关于LLM集成的文献汇总列表,请访问 https://github.com/junchenzhi/Awesome-LLM-Ensemble。1 引言近年来,人工智能领域的格局因大型语言模型(LLM)的发展而发生了剧变,代表性的模型包括Gemini [Team et al., 2023]、GPT-4 [Achiam et al., 2023]、Llama [Touvron et al., 2023],以及最近推出的DeepSeek [Liu et al., 2024a]。这些LLM的成功继续激发广泛的研究热情,目前Hugging Face库中已可访问超过182,000个大型语言模型。 然而,在这股研究热潮背后,我们可以识别出两个主要方面: 1) 性能问题:LLM的直接开箱即用能力(零样本推理)和间接开箱即用能力(上下文学习的少样本推理)仍然引发性能担忧,包括准确性、幻觉和与人类意图的不对齐等问题; 2) LLM的优缺点差异及其推理成本:由于架构、参数大小、分词方法、词典、训练数据和方法论的差异,这些LLM表现出显著的变异性,其响应可能存在较大差异。考虑到上述两个方面,并借鉴集成学习的精神,自然地可以考虑,对于每个任务查询,与其在公共排名或其他标准的基础上持续依赖单一LLM,不如同时考虑多个LLM候选模型(可以开箱即用),并利用它们各自的优势。这正是新兴的LLM集成领域所探索的内容。现有的LLM集成方法大体可以根据LLM推理和集成的顺序分为三种类型: 1) 推理前集成方法:利用给定的查询信息,并考虑所有LLM候选模型的不同特性,以便为推理选择合适的模型(此方法类似于集成学习中的硬投票策略); 2) 推理中集成方法:在解码过程中,聚合来自多个LLM的不完整响应(例如,令牌级信息),并将组合结果反馈给所有模型; 3) 推理后集成方法:在所有模型或其子集生成完整响应(而非片段)后进行集成。尽管最近基于这些广泛范式衍生出了众多方法,但目前仍缺乏一篇正式的综述,提供对快速发展的LLM集成领域的核心思想和相关研究的全面回顾。本文呈现了首个关于LLM集成的全面综述,介绍了最新进展,并重点讨论了分类法、相关问题、方法、基准、应用和未来方向。我们希望这篇综述能够为研究人员提供全面的回顾,并激发进一步的探索。