李航统计学习方法(第二版)(一):基本概念以及符号

1绪论

1 统计学习

统计学习:统计学习是关于计算机基于数据构建概率统计模型并运用模型对数据进行预测与分析的一门学科。

统计学习的对象:统计学习研究的对象是数据(data.)。数据是多样的,包括存在于计算机及网络土的各种数字、文字、图像、视频、音频数据以及它们的组合。

统计学习的目的:统计学习用于对数据的预测与分析,特别是对未知新数据的预测与分析。

统计学习的方法:基于数据构建概率统计模型从而对数据进行预测与分析。统计学习由监督学习、无监督学习、强化学习等组成

统计学习方法可以概括如下

从给定的、有限的、用于学习的训练数据(training data)集合出发,假设数据是独立同分布产生的:并且假设要学习的模型属于某个函数的集合,称为假设空间(hypothesis space );应用某个评价准则(evaluation criterion ),从假设空间中选取个最优模型,使它对已知的训练数据及未知的测试数据(test data.)在给定的评价准则下有最优I狗预测:最优模型的选取由算一法实现。这样,统计学习方法包括模型的假设空间、模型选择的准则以及模型学习的算法。称其为统计学习方法的三要素,简称为模型 ( model)、策略(strategy)、算法(algorithm)

实现统计学习方法的步骤:

1) 得到一个有限的训练数据集合;

2) 确定包含所有可能的模型的假设空间,即学习模型的集合;

3) 确定模型选择的准则,即学习的策略;

4) 实现求解最优模型的算法,即学习的算法;

5) 通过学习方法选择最优模型;

6) 利用学习的最优模型对新数据进行预测或分析。

2 统计学习的分类

2.1.监督学习

监督学习(supervised learning)是指从标注数据中’赞习预测模型的机器学习问题。标注数据表示输入输出的对应关系,预测模型对给定的输入产生相应的输出。监督学习的本质是学习输入到输出的映射的统计规律。

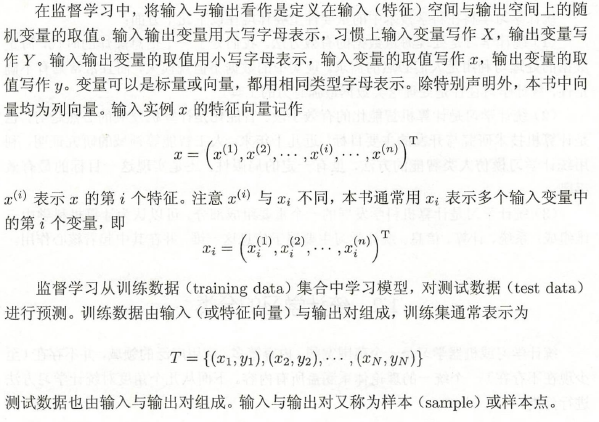

(1)输入空间、特征空间和输出空间

监督学习中,将输入与输出所有可能取值的集合分别称为输入空间(input space )与输出空间(output space)。

每个具体的输入是一个实例(instance),通常由特征向量(feature vector)表示。这时,特征向量存在的空间称为特征空间 (feature space)。特征空间的每一维对应于一个特征。模型实际上都是定义在特征空间上的。

(2)联合概率分布

监督学习假设输入与输出的随机变量X和Y遵循联合概率分布P(X, Y).

P(X, Y)表示分布函数,或分布密度函数。训练数据与测试数据被看作是依联合概率分布P(X, Y)独立同分布产生的。

统计学习假设数据存在一定的统计规律,X和Y具有联合概率分布就是监督学习关于数据的基术假设。

(3)假设空间

监督学习的目的在于学习一个由输入到输出的映射,这一映射由模型来表示。模型属于由输入空间到输出空问的映射的集合,这个集合就是假设空间(hypothesis space)。假设空间的确定意味着学习的范围的确定。

(4)问题的形式化

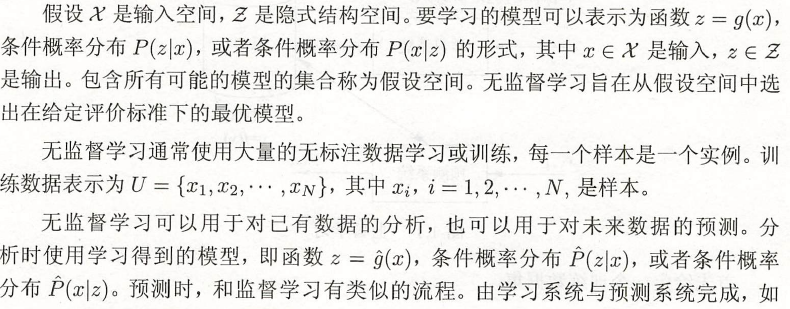

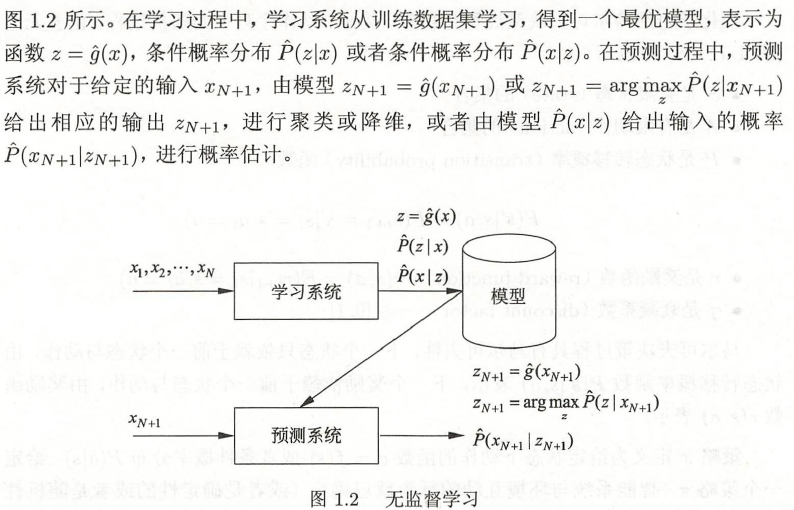

2.2.无监督学习

无监督学习(unsupervised learning)是指从无标注数据中学习预测模型的机器学习问题。无标注数据是自然得到的数据,预测模型表示数据的类别、转换或概率。无监督学习的本质是学习数据中的统计规律或潜在结构。

2.3.强化学习

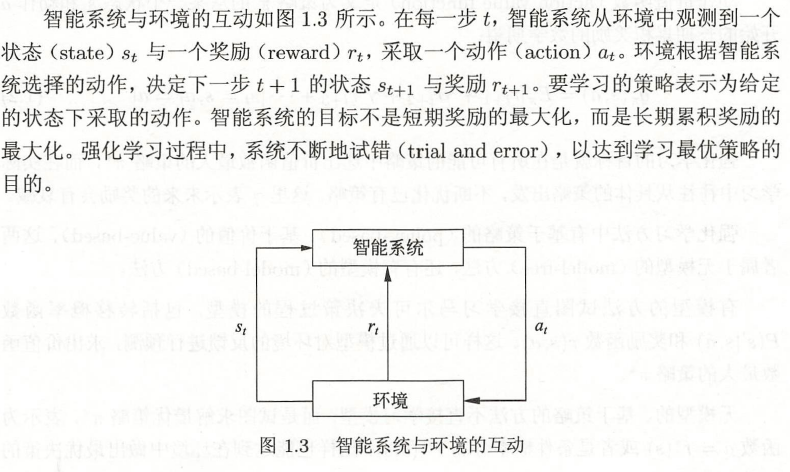

强化学习(reinforcement learning)是指智能系统在与环境的连续互动中学习最优行为策略的机器学习问题。假设智能系统与环境的互动基于马尔可夫决策过

程(Marlcov decision process)智能系统能观测到的是与环境互动得到的数据序列。强化学习的本质是学习最优的序贯决策。

2.4.半监督学习与主动学习

半监督学习(semi-supervised learning)是指利用标注数据和未标注数据学习预测模型的机器学习问题。

主动学习(active learning)是指机器不断主动给出实例让教师进行标注,然后利用标注数据学习预测模型的机器学习问题。

3 统计学习方法三要素

统训一学习方法都是由模型、策略和算法构成的,即统计学习方法由二要素构成。

3.1 模型

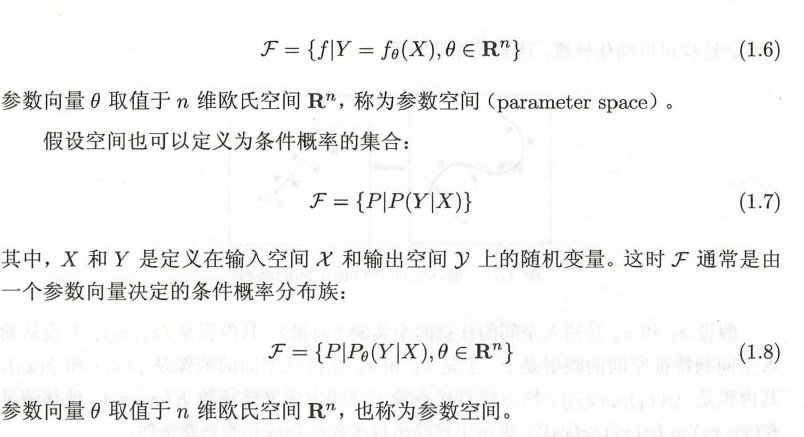

在监督学习过程中,模型就是所要学习的条件概率分布或决策函数。模型的假设空间(hypothesis space)包含所有可能的条件概率分布或决策函数。

3.2 策略

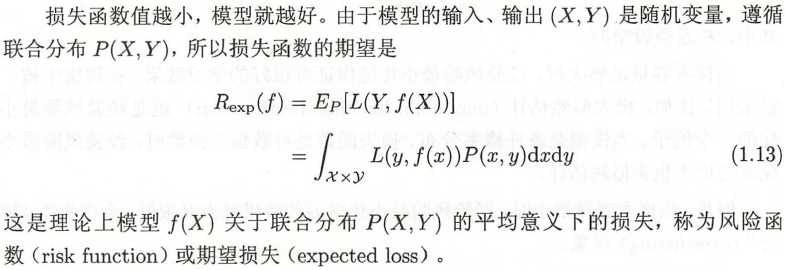

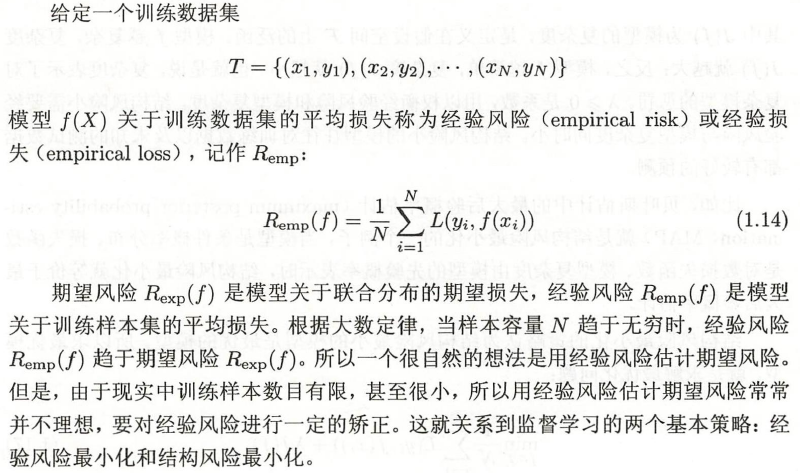

损失函数与风险函数

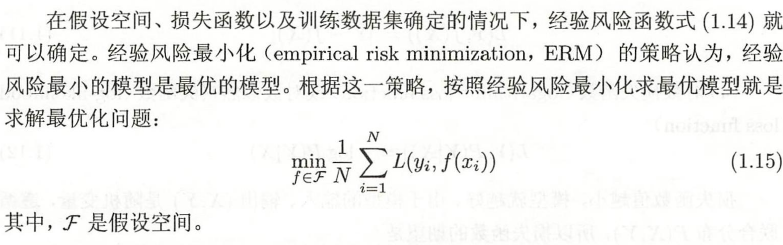

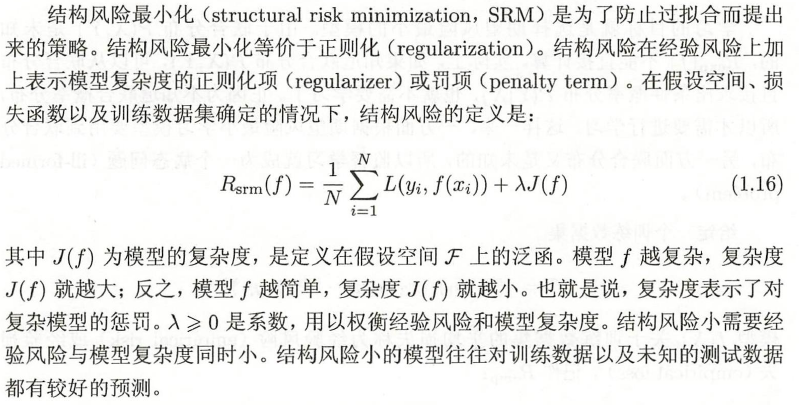

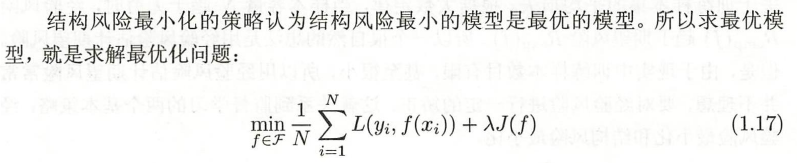

经验风险最小化与结构风险最小化

极大似然估计(maximum likelihood estimation)就是经验风险最小化的一个例子。当模型是条件概率分布、损失函数是对数损失函数时,经验风险最小

化就等价于极大似然估计。

3.3 算法

算法是指学习模型的具体计算方法。统计学习基于训练数据集,根据学习策略,从假设空间中选择最优模型,最后需要考虑用什么样的计算方法求解最优模型。

4 模型评佑与模型选择

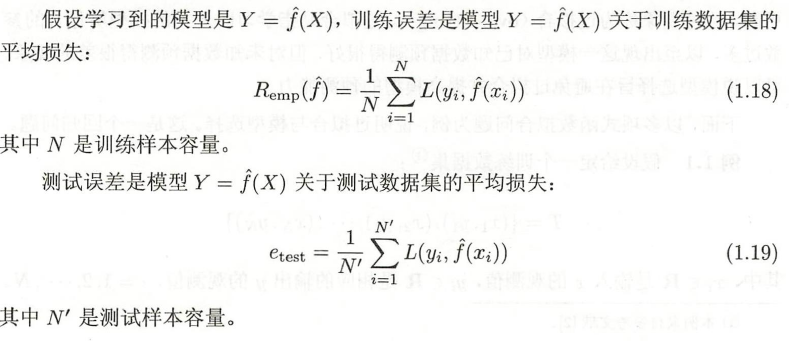

训练误差(training error)和模型的测试误差(test error)

泛化能力:通常将学习方法对未知数据的预测能力称为泛化能力(generalizationability )。

4.2过拟合与模型选择

过拟合是指学习时选择的模型所包含的参数过多,以至出现这一模型对己知数据预测得很好,但对未知数据预测得很差的现象。

可以说模型选择旨在避免过拟合并提高模型的预测能力。

5 正则化与交叉验证

常用的模型选择方法:正则化与交叉验证。

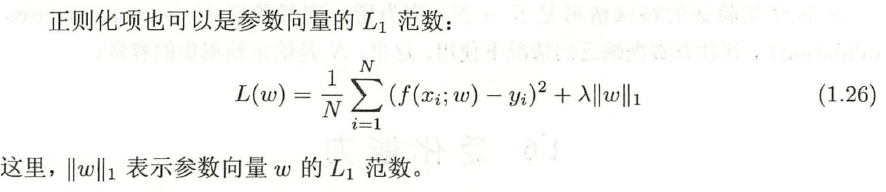

正则化是结构风险最小化策略的实现,是在经验风险上加一个正则化项(regularizer)或罚项(penalty term)。

交叉验证

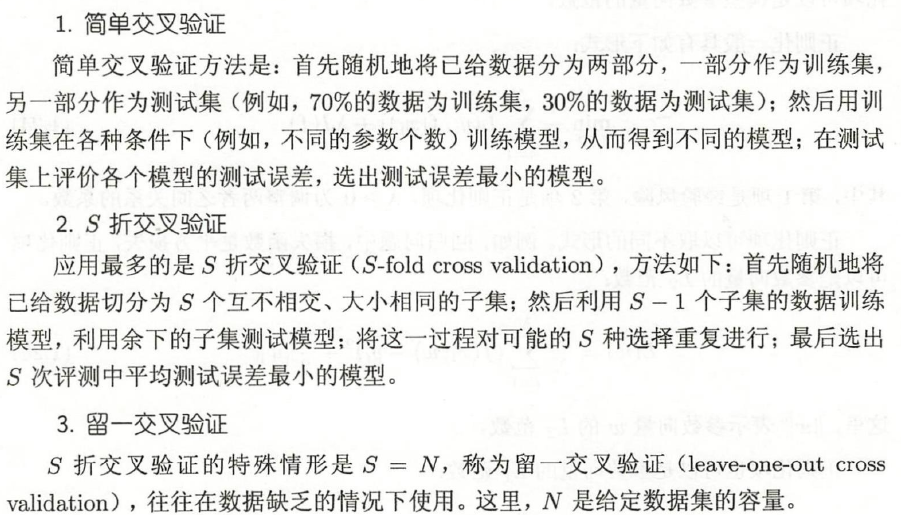

如果给定的样本数据充足,进行模型选择的一种简单方法是随机地将数据集切分成三部分,分别为训练集(training set)、验证集(validation set) ,测试集(test set)。训练集用来训练模型,验证集用于模型的选择,而测试集用于最终对学习方法的评估。在学习到的不同复杂度的模型中,选择对验证集有最小预测误差的模型。由于验证集有足够多的数据,用它对模型进行选择也是有效的。

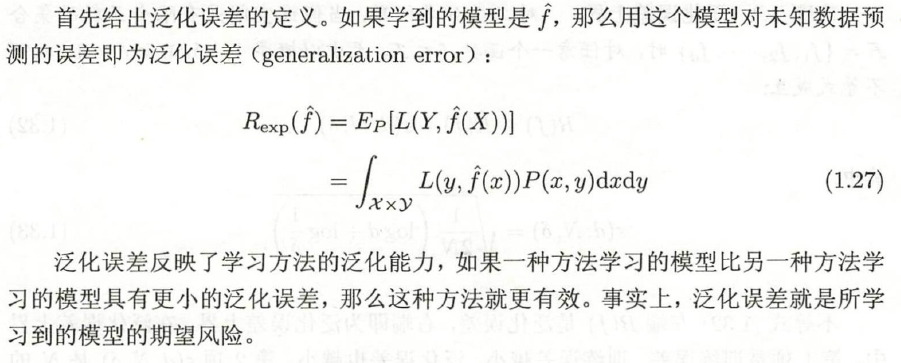

6 泛化能力

学习方法的泛化能力(generalization ability)是指由该方法学习到的模型对未知数据的预测能力,是学习方法本质上重要的性质。

学习方法的泛化能力分析往往是通过研究泛化误差的概率上界进行的,简称为泛化误差上界(generalization error bound )。具体来说,就是通过比较两种学习方法的泛化误差上界的大小来比较它们的优劣。

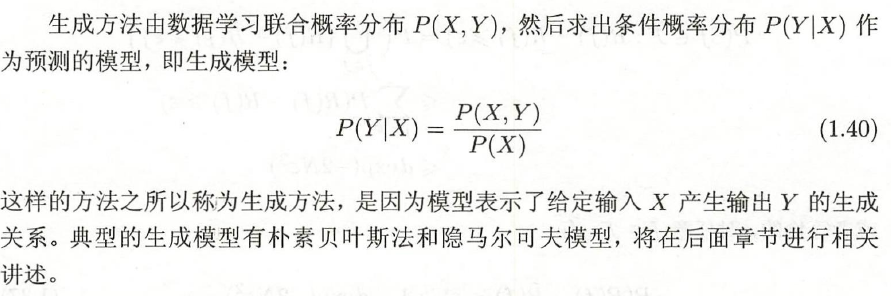

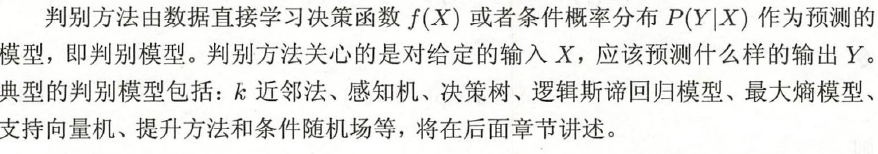

7 生成模型与判别模型

监督学习方法又可以分为生成方法(generative approach)和判别方法(discriminative approa)。所学到的模型分别称为生成模型( generative model )和判别模型(discriminative model)。

8 监督学习应用

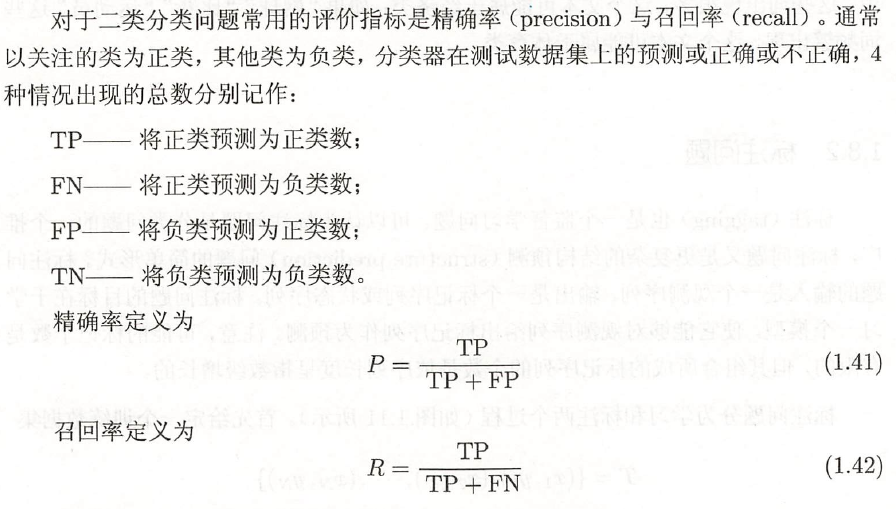

8.1分类问题

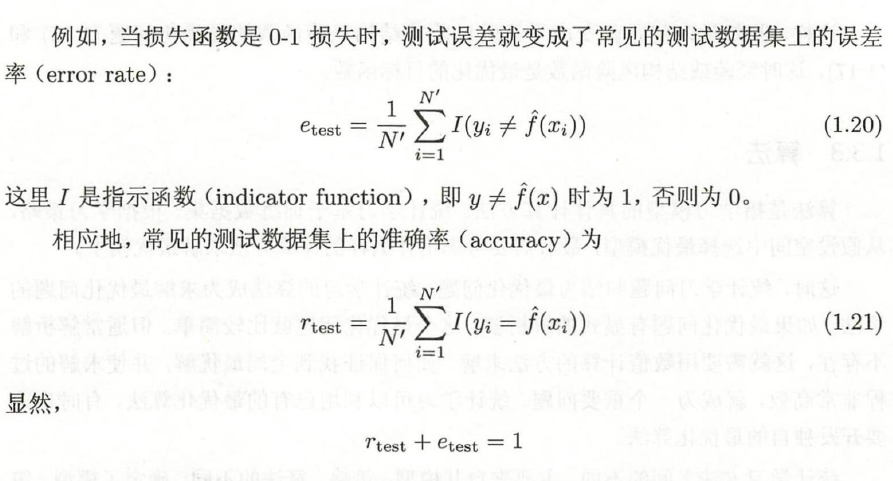

监督学习从数据中学习一个分类模型或分类决策函数,称为分类器(classifier)。分类器对新的输入进行输出的预测,称为分类(classification )。可能的输出称为类别(class )。

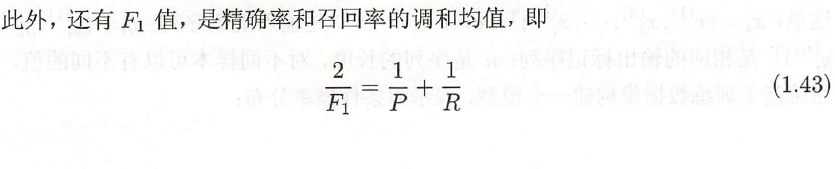

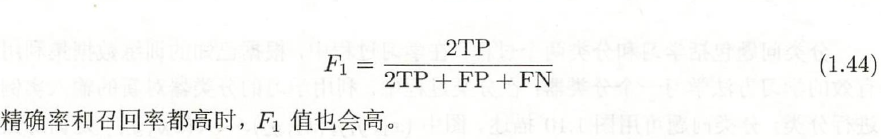

评价分类器性能的指标一般是分类准确率(accuracy),其定义是:对于给定的测试数据集,分类器正确分类的样本数与总样本数之比。也就是损失函数是0-1损失时测试数据集上的准确率(见式(1.21) )

8.2标注问题

标注( tugging)也是一个监件学习问题o }"J以认为标注问题足分类问题的一个扣标注问题又是更复杂的结构预测(stractnre prediction)问题的简单形式。

标注常用的统计学习方法有:隐马尔可夫模型、条件随机场。

8.3回归问题

回归用于预测输入变量(自变量)和输出变量(因变量)之间的关系,特别是当输入变量的值发生变化时,输出变量的值随之发生的变化。回归模型正是表示从输入变量到输出变量之间映射的函数。回归问题的学习等价于函数拟合:选择一条函数曲线使其很好地拟合已知数据且很好地预测未知数据。

回归学习最常用的损失函数是平方损失函数,在此情况下,回归问题可以由著名的最小二乘法(least squares)求解。

9.梯度、梯度方向、梯度下降、随机梯度下降

本文来自博客园,作者:秋华,转载请注明原文链接:https://www.cnblogs.com/qiu-hua/p/12707363.html