创造可解释的人工智能,迈向认知智能,深度理解自然语言实例(3)

爱因斯坦名言:“傻瓜都知道,关键是要理解”。人工智能要理解人类语言,首先要做到可解释。通过解释其思维过程,了解AI是否真的理解每一句话的意思。这就需要知道AI自己是怎么想的。

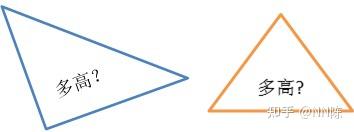

举例:“这个三角形的高度是多少”?

要理解这句话,手动写个程序来计算高度可能就是几行代码的事。但这不是人工智能,这是人脑智能。通过设计好的代码来返回高度,AI几乎没做任何思考。比如返回高度168,这个高度正确吗?是我要问的这个三角形的高度吗?

可解释的AI需要知道这个答案是怎么来的。

1. 高度的计算公式是什么?

2. 高度取决于哪些数据?

3. 每项数据又是怎么得来的。通过展示具体数据,就可判断是不是我们要求的三角形。

4. 最后的数据运算又是什么。

再比如:“换成蓝色”,这句话信息很少,只有颜色。AI是否正确理解,需要把完整的意思表达出来。有可能是“用蓝色填充某个三角形”,也可能是“换成蓝色的衣服”等等。可解释才能证明理解正确。

但不是所有事情都可以完美解释,比如:识别一种动物。很难用详细的语言来描述各种动物之间的区别。这需要用到感性思维。

比如,猫和狗的区别。看似很像,明知有区别,但又不好描述。实在要说又能说出一些差别。这里面既有感性思维又有理性思维。

深度学习在感性思维的路上走得很远,但是很难解释。符号主义在理性思维的路上走得很远,但是不能解决感性问题,规则定义起来很苦难。真正会思考的人工智能需要同时具备两种能力。

探索通向认知智能之路,自然语言实例(3),视频演示:

发布于 2021-06-24 17:19